Gids voor het genereren van synthetische data: definitie, typen en toepassingen

Het is geen geheim dat bedrijven met uitdagingen worden geconfronteerd bij het verwerven en delen van data van hoge kwaliteit. Synthetische datageneratie is een praktische oplossing die helpt bij het produceren van grote kunstmatige datasets en hoogwaardige testdata zonder privacyrisico's of administratieve rompslomp.

Synthetische datasets kunnen op verschillende manieren worden gemaakt en bieden uiteenlopende toepassingen. Wanneer ze op de juiste manier worden geëvalueerd, helpen synthetische datasets die zijn gegenereerd met behulp van geavanceerde algoritmen organisaties hun analyses, onderzoek en testen te versnellen. Laten we het dus eens nader bekijken.

In dit artikel maak je kennis met synthetische data, inclusief de belangrijkste typen, verschillen met geanonimiseerde datasets en nuances in de regelgeving. Je leert hoe kunstmatig gegenereerde data kritieke dataproblemen oplost en bepaalde risico's minimaliseert. We bespreken ook de toepassingen ervan in verschillende sectoren, vergezeld van voorbeelden uit onze casestudy's.

Inhoudsopgave

Synthetische data: definitie en marktstatistieken

Synthetische data is kunstmatig gegenereerde informatie zonder vertrouwelijke inhoud, en dient als alternatief voor echte datasets. Datawetenschappers bellen vaak AI-gegenereerde synthetische data een synthetische data-tweeling vanwege de hoge statistische nauwkeurigheid bij het nabootsen van echte data.

Kunstmatige datasets worden gemaakt met behulp van kunstmatige intelligentie (AI)-algoritmen en simulaties die de patronen en correlaties van de originele data behouden. Deze data kunnen tekst, tabellen en afbeeldingen bevatten. De algoritmen vervangen persoonlijk identificeerbare informatie (PII) door nepdata.

Grand View Onderzoeksvoorspellingen waar de markt voor is synthetische datageneratie met generatieve AI zal groeien van $1.63 miljard in 2022 naar ongeveer $13.5 miljard in 2030, bij een CAGR van 35%. Volgens Gartner is 60% van de data die in 2024 voor AI worden gebruikt, zal synthetisch zijn – dat is 60 keer meer dan in 2021.

Ook synthetische dataplatforms zijn in opkomst. Markt Statesville verwacht de mondiale markt voor synthetische dataplatforms zal groeien van 218 miljoen dollar in 2022 naar 3.7 miljard dollar in 2033.

Waarom zijn kunstmatige data in opkomst? Eén drijvende factor is de vrijheid van regelgevend toezicht.

Reguleert de privacywetgeving de door AI gegenereerde synthetische data?

Veel VS en EU databeveiliging en privacy Op identificeerbare persoonsdata zijn regels van toepassing.

Maar die regels zijn niet van toepassing op synthetische data — synthetische data worden op dezelfde manier behandeld als geanonimiseerde data. Ze vormen de zogenaamde ‘kern’ van andere rechtsregels.

Bijvoorbeeld overweging 26 van de AVG zegt dat regels voor privacybescherming alleen van toepassing zijn op data die betrekking hebben op een identificeerbare persoon. Als uw synthetische data zodanig worden gegenereerd dat deze niet kunnen worden herleid tot identificeerbare personen, zijn ze vrijgesteld van toezicht door de toezichthouder. Afgezien van het toezicht door de toezichthouders zijn er nog andere obstakels voor het gebruik van echte data, die bedrijven ertoe aanzetten synthetische data te genereren.

Belangrijkste uitdagingen bij het gebruik van echte data

Veel bedrijven hebben moeite met het vinden en gebruiken van relevante data van hoge kwaliteit, vooral in voldoende hoeveelheden voor AI-algoritmetraining. Zelfs als ze deze wel vinden, kan het delen of gebruiken van de datasets een uitdaging zijn vanwege privacyrisico's en compatibiliteitsproblemen. In dit gedeelte wordt de sleutel uiteengezet daagt synthetische data uit kan oplossen.

Privacyrisico’s belemmeren het gebruik en delen van data

Regelgeving voor databeveiliging en privacy, zoals GDPR en HIPAA, introduceren bureaucratische obstakels voor het delen en gebruiken van data. In sectoren als de gezondheidszorg kan zelfs het delen van PII tussen afdelingen binnen dezelfde organisatie tijdrovend zijn vanwege governancecontroles. Het delen van data met externe entiteiten is nog uitdagender en brengt meer veiligheidsrisico's met zich mee.

uit onderzoek van Fortuin Zakelijke Inzichten identificeert toenemende privacyrisico’s als een primaire katalysator voor het adopteren van synthetische datapraktijken. Hoe meer data u opslaat, hoe groter het risico dat uw privacy in gevaar komt. Volgens het IBM Security Cost of a Data Breach Report 2023bedroegen de gemiddelde kosten voor datalekken in de VS $9.48 miljoen. Wereldwijd bedroegen de gemiddelde kosten $ 4.45 miljoen; bedrijven met minder dan 500 werknemers verliezen 3.31 miljoen dollar per inbreuk. En dat houdt geen rekening met reputatieschade.

Moeilijkheden bij het vinden van data van hoge kwaliteit

Een 2022-enquête van de 500 dataprofessionals onthulde dat 77% van de ingenieurs, analisten en datawetenschappers te maken kreeg met problemen met de datakwaliteit. Volgens het rapport belemmert de datakwaliteit de financiële prestaties en productiviteit van een bedrijf en maakt het moeilijk om een holistisch beeld van de diensten te krijgen.

Bedrijven beschikken mogelijk niet over voldoende data uit specifieke demografische data om hun machine learning-modellen (ML) goed te trainen. En datasets bevatten vaak inconsistenties, onnauwkeurigheden en ontbrekende waarden. Als u uw AI-platforms traint met machine learning-modellen op basis van data van lage kwaliteit zonder demografische diversiteit zal het onnauwkeurige, bevooroordeelde voorspellingen doen. Op dezelfde manier kunnen ongeraffineerde algoritmen, net als bij het genereren van geanonimiseerde data, onbetrouwbare kunstmatige datasets produceren die de uitkomst van data-analyse beïnvloeden.

Upsampling met synthetische data kan de datakwaliteit verbeteren door onevenwichtigheden in datasets aan te pakken. Dit zorgt ervoor dat ondervertegenwoordigde klassen een meer proportionele vertegenwoordiging krijgen en vertekening vermindert. Een robuustere en representatievere dataset levert betere analyseresultaten en modeltraining op.

Incompatibiliteit met datasets

Gegevenssets afkomstig uit verschillende bronnen of uit databases met meerdere tabellen kunnen incompatibiliteit met zich meebrengen, waardoor complexiteit ontstaat bij de dataverwerking en -analyse en innovatie wordt belemmerd.

Gegevensaggregatie in de gezondheidszorg omvat bijvoorbeeld elektronische medische dossiers (EPD's), wearables, eigen software en tools van derden. Elke bron kan verschillende dataformaten en informatiesystemen gebruiken, wat tijdens de integratie tot verschillen in dataformaten, structuren of eenheden kan leiden. Het gebruik van synthetische data kan deze uitdaging aangaan, door compatibiliteit te garanderen en mogelijk te maken data genereren in het gewenste formaat.

Anonimisering is onvoldoende

Anonimiseringstechnieken zijn niet voldoende om privacyrisico's of problemen met de datakwaliteit te ondervangen. Bovendien, het maskeren of verwijderen van identificatiedata kan details wegnemen die nodig zijn voor diepgaande analyse in grote datasets.

Bovendien kunnen geanonimiseerde data opnieuw worden geïdentificeerd en tot individuen worden herleid. Kwaadwillige actoren kunnen geavanceerde analyses gebruiken om op tijd gebaseerde patronen bloot te leggen die de anonimiteit van schijnbaar geanonimiseerde data in gevaar brengen. Synthetische data zijn wat dat betreft superieur aan geanonimiseerde data.

Anders anonimisering, synthetische data verandert bestaande datasets niet, maar genereert nieuwe data die lijken op de kenmerken en structuur van de ruwe data, met behoud van het nut ervan. Het is een geheel nieuwe dataset die geen persoonlijk identificeerbare informatie bevat.

Maar het ligt genuanceerder dan dat. Er zijn verschillende soorten methoden voor het genereren van synthetische data.

Soorten synthetische datageneratie

Synthetische datacreatie processen variëren afhankelijk van het type data dat vereist is. Synthetische datatypen omvatten volledig door AI gegenereerde, op regels gebaseerde en nepdata, die allemaal aan een andere behoefte voldoen.

Volledig door AI gegenereerde synthetische data

Dit soort synthetische data is helemaal opnieuw opgebouwd met behulp van ML-algoritmen. De machine learning-model treinen verder echte data om meer te weten te komen over de structuur, patronen en relaties van de data. Generatieve AI gebruikt deze kennis vervolgens om nieuwe data te genereren die sterk lijken op de statistische eigenschappen van het origineel (opnieuw, terwijl ze deze niet-identificeerbaar maken).

Dit soort volledig synthetische data is nuttig voor AI-modeltraining en is goed genoeg om te gebruiken alsof het echte data zijn. Het is vooral handig als u uw datasets niet kunt delen vanwege contractuele privacyafspraken. Om synthetische data te genereren heb je echter een aanzienlijke hoeveelheid originele data nodig als uitgangspunt machine learning-model training.

Synthetische nepdata

Deze synthetische data type verwijst naar kunstmatig gecreëerde data die de structuur en het formaat van echte data imiteren, maar niet noodzakelijkerwijs de feitelijke informatie weerspiegelen. Het helpt ontwikkelaars ervoor te zorgen dat hun applicaties verschillende invoer en scenario's kunnen verwerken zonder gebruik te maken van echte, privé- of gevoelige data en, belangrijker nog, zonder te vertrouwen op data uit de echte wereld. Deze praktijk is essentieel voor het testen van de functionaliteit en het verfijnen van softwareapplicaties op een gecontroleerde en veilige manier.

Wanneer kunt u het gebruiken: Ter vervanging van directe identificatiemiddelen (PII) of wanneer u momenteel geen data heeft en liever geen tijd en energie investeert in het definiëren van regels. Ontwikkelaars gebruiken vaak nepdata om de functionaliteit en het uiterlijk van applicaties te evalueren tijdens de vroege ontwikkelingsfasen, waardoor ze potentiële problemen of ontwerpfouten kunnen identificeren.

Ook al missen nepdata de authenticiteit van informatie uit de echte wereld, het blijft een waardevol hulpmiddel om de goede werking en visuele representatie van systemen te garanderen vóór de daadwerkelijke dataintegratie.

Opmerking: synthetische nepdata worden vaak 'valse data,' hoewel we niet aanraden deze termen door elkaar te gebruiken, omdat ze qua connotaties kunnen verschillen.

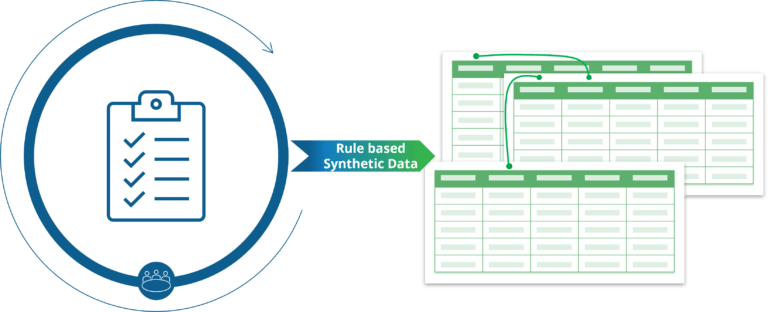

Op regels gebaseerde synthetische data

Op regels gebaseerde synthetische data is een handig hulpmiddel voor het genereren van aangepaste datasets op basis van vooraf gedefinieerde regels, beperkingen en logica. Deze methode biedt flexibiliteit doordat gebruikers de datauitvoer kunnen configureren op basis van specifieke zakelijke behoeften, waarbij parameters zoals minimum-, maximum- en gemiddelde waarden worden aangepast. In tegenstelling tot volledig door AI gegenereerde data, waarbij maatwerk ontbreekt, bieden op regels gebaseerde synthetische data een oplossing op maat om aan specifieke operationele vereisten te voldoen. Dit synthetisch proces voor het genereren van data blijkt bijzonder nuttig bij testen, ontwikkelen en analyseren, waarbij nauwkeurige en gecontroleerde datageneratie essentieel is.

Elke methode voor het genereren van synthetische data heeft verschillende toepassingen. Het platform van Syntho onderscheidt zich door het creëren van synthetische datatweelingen met weinig tot geen inspanning van uw kant. Je wordt statistisch accuraat, synthetische data van hoge kwaliteit voor uw behoeften, zonder compliance-overhead.

Synthetische data in tabelvorm

De term synthetische data in tabelvorm verwijst naar het creëren van kunstmatige data subsets die de structuur en statistische eigenschappen van de echte wereld nabootsen Tabeldata, zoals data die zijn opgeslagen in tabellen of spreadsheets. Dit synthetische data is gemaakt met behulp van algoritmen voor het genereren van synthetische data en technieken die zijn ontworpen om de kenmerken van de data bron terwijl ervoor wordt gezorgd dat vertrouwelijke of gevoelige data wordt niet bekendgemaakt.

Technieken om te genereren tabel synthetische data meestal gaat het om statistische modellen, machine learning-modellenof generatieve modellen zoals generatieve vijandige netwerken (GAN's) en variatieve autoencoders (VAE's). Deze tools voor het genereren van synthetische data analyseer de patronen, verdelingen en correlaties die aanwezig zijn in de echte dataset en dan nieuwe genereren data punten dat lijken sterk op echte data maar bevatten geen echte informatie.

Typisch tabellarisch gebruiksscenario's voor synthetische data omvatten het aanpakken van privacyproblemen, het vergroten van de beschikbaarheid van data en het faciliteren van onderzoek en innovatie in datagestuurde toepassingen. Het is echter essentieel om ervoor te zorgen dat de synthetische data legt nauwkeurig de onderliggende patronen en verdelingen van de originele data vast die moeten worden onderhouden datahulpprogramma en geldigheid voor downstream-taken.

Meest populaire synthetische datatoepassingen

Kunstmatig gegenereerde data openen innovatiemogelijkheden voor de gezondheidszorg, de detailhandel, de productie, de financiële sector en andere sectoren. De primaire toepassingen omvatten data-upsampling, analyse, testen en delen.

Upsampling om datasets te verbeteren

Upsampling betekent het genereren van grotere datasets uit kleinere datasets voor schaalvergroting en diversificatie. Deze methode wordt toegepast wanneer echte data schaars, onevenwichtig of onvolledig zijn.

Beschouw een paar voorbeelden. Voor financiële instellingen kunnen ontwikkelaars de nauwkeurigheid van fraudedetectiemodellen verbeteren door zeldzame observaties en activiteitspatronen in de database te upsamplen financiële data. Op dezelfde manier zou een marketingbureau kunnen upsamplen om de data over ondervertegenwoordigde groepen te vergroten, waardoor de nauwkeurigheid van de segmentatie wordt verbeterd.

Geavanceerde analyses met door AI gegenereerde data

Bedrijven kunnen door AI gegenereerde synthetische data van hoge kwaliteit inzetten voor datamodellering, bedrijfsanalyses en klinisch onderzoek. Gegevens synthetiseren blijkt een haalbaar alternatief te zijn wanneer het verwerven van echte datasets te duur of tijdrovend is.

Synthetische data stelt onderzoekers in staat diepgaande analyses uit te voeren zonder de vertrouwelijkheid van de patiënt in gevaar te brengen. Data wetenschappers en onderzoekers krijgen toegang tot patiëntdata, informatie over klinische aandoeningen en behandelingsdetails, waardoor inzichten worden verkregen die met echte data aanzienlijk tijdrovender zouden zijn. Bovendien kunnen fabrikanten vrijelijk data delen met leveranciers, waarbij ze gemanipuleerde GPS- en locatiedata gebruiken om algoritmen te creëren voor prestatietests of voorspellend onderhoud te verbeteren.

Echter, evaluatie van synthetische data is kritisch. De output van de Syntho Engine wordt gevalideerd door een intern kwaliteitsborgingsteam externe deskundigen van het SAS Instituut. In een onderzoek naar voorspellende modellen hebben we er vier getraind machine learning-modellen op echte, geanonimiseerde en synthetische data. De resultaten toonden aan dat modellen die op onze synthetische datasets waren getraind hetzelfde nauwkeurigheidsniveau hadden als modellen die op echte datasets waren getraind, terwijl geanonimiseerde data het nut van de modellen verminderden.

Externe en interne datauitwisseling

Synthetische data vereenvoudigt het delen van data binnen en tussen organisaties. Jij kan synthetische data gebruiken naar informatie uitwisselen zonder het risico te lopen op schending van de privacy of niet-naleving van de regelgeving. De voordelen van synthetische data zijn onder meer versnelde onderzoeksresultaten en effectievere samenwerking.

Retailbedrijven kunnen inzichten delen met leveranciers of distributeurs met behulp van synthetische data die het gedrag van klanten, voorraadniveaus of andere belangrijke statistieken weerspiegelen. Om echter het hoogste niveau te garanderen data Privacy, gevoelige klantdata en bedrijfsgeheimen worden vertrouwelijk behandeld.

Syntho won de Global SAS Hackathon 2023 voor ons vermogen om te genereren en te delen anauwkeurige synthetische data effectief en zonder risico. We hebben patiëntdata voor meerdere ziekenhuizen met verschillende patiëntenpopulaties gesynthetiseerd om de effectiviteit van voorspellende modellen aan te tonen. Het gebruik van de gecombineerde synthetische datasets bleek net zo nauwkeurig te zijn als het gebruik van echte data.

Synthetische testdata

Synthetische testdata zijn kunstmatig gegenereerde data die zijn ontworpen om te simuleren data testen omgevingen voor softwareontwikkeling. Naast het verminderen van de privacyrisico's, stellen synthetische testdata ontwikkelaars in staat de prestaties, beveiliging en functionaliteit van applicaties rigoureus te beoordelen in een reeks potentiële scenario's zonder het echte systeem te beïnvloeden.

Onze samenwerking met één van de grootste Nederlandse banken vitrines voordelen van synthetische data voor softwaretesten. Het genereren van testdata met de Syntho Engine resulteerde in productie-achtige datasets die de bank hielpen de softwareontwikkeling en bugdetectie te versnellen, wat leidde tot snellere en veiligere softwarereleases.

Technieken om te genereren tabel synthetische data meestal gaat het om statistische modellen, machine learning-modellenof generatieve modellen zoals generatieve vijandige netwerken (GAN's) en variatieve autoencoders (VAE's). Deze tools voor het genereren van synthetische data analyseer de patronen, verdelingen en correlaties die aanwezig zijn in de echte dataset en dan nieuwe genereren data punten dat lijken sterk op echte data maar bevatten geen echte informatie.

Typisch tabellarisch gebruiksscenario's voor synthetische data omvatten het aanpakken van privacyproblemen, het vergroten van de beschikbaarheid van data en het faciliteren van onderzoek en innovatie in datagestuurde toepassingen. Het is echter essentieel om ervoor te zorgen dat de synthetische data legt nauwkeurig de onderliggende patronen en verdelingen van de originele data vast die moeten worden onderhouden datahulpprogramma en geldigheid voor downstream-taken.

Syntho's platform voor het genereren van synthetische data

Syntho biedt een slim platform voor het genereren van synthetische data, waarmee organisaties data op intelligente wijze kunnen transformeren in een concurrentievoordeel. Door alle methoden voor het genereren van synthetische data in één platform aan te bieden, biedt Syntho een uitgebreide oplossing voor organisaties die data willen gebruiken die betrekking hebben op:

- AI-gegenereerde synthetische data die statistische patronen van originele data nabootst in synthetische data met de kracht van kunstmatige intelligentie.

- Slimme de-identificatie beschermen gevoelige data door persoonlijk identificeerbare informatie (PII) te verwijderen of te wijzigen.

- Test data management dat maakt het mogelijk creatie, onderhoud en controle van representatieve testdata voor niet-productieomgevingen.

Onze platforms kunnen worden geïntegreerd in elke cloud- of lokale omgeving. Bovendien verzorgen wij de planning en inzet. Ons team zal uw medewerkers trainen in het gebruik ervan Syntho-engine effectief, en we bieden continue ondersteuning na de implementatie.

Lees meer over de mogelijkheden van Syntho's synthetische data generatieplatform in de Oplossingengedeelte van onze website.

Wat staat de toekomst te bieden voor synthetische data?

Synthetische datageneratie met generatieve AI helpt bij het creëren en delen van grote hoeveelheden relevante data, waarbij compatibiliteitsproblemen met formaten, wettelijke beperkingen en het risico op datalekken worden omzeild.

In tegenstelling tot anonimisering, synthetische data genereren maakt het mogelijk om structurele relaties in de data te behouden. Dit maakt synthetische data geschikt voor geavanceerde analyses, onderzoek en ontwikkeling, diversificatie en testen.

Het gebruik van synthetische datasets zal alleen maar toenemen tussen sectoren. Bedrijven zijn er klaar voor synthetische data creëren, de reikwijdte ervan wordt uitgebreid naar complexe afbeeldingen, audio- en video-inhoud. Bedrijven zullen het gebruik ervan uitbreiden machine learning-modellen naar meer geavanceerde simulaties en toepassingen.

Wil je meer praktische toepassingen leren van synthetische data? Voel je vrij om plan een demo in onze website.

Over Syntho

syntho biedt een slimme synthetische datageneratie platform, benutten meerdere synthetische dataformulieren en generatiemethoden, waardoor organisaties data op intelligente wijze kunnen transformeren in een concurrentievoordeel. Onze door AI gegenereerde synthetische data bootsen statistische patronen van originele data na, waardoor nauwkeurigheid, privacy en snelheid worden gegarandeerd, zoals beoordeeld door externe experts zoals SAS. Met slimme de-identificatiefuncties en consistente mapping wordt gevoelige informatie beschermd terwijl de referentiële integriteit behouden blijft. Ons platform maakt het creëren, beheren en controleren van testdata voor niet-productieomgevingen mogelijk, op basis van regels methoden voor het genereren van synthetische data voor gerichte scenario's. Bovendien kunnen gebruikers programmatisch synthetische data genereren en verkrijgen realistische testdata om met gemak uitgebreide test- en ontwikkelingsscenario's te ontwikkelen.

Over de auteur

Wim Kees Janssen

CEO & oprichter

Syntho, de scale-up die de data-industrie ontwricht met door AI gegenereerde synthetische data. Wim Kees heeft met Syntho bewezen dat hij privacygevoelige data kan ontsluiten om data slimmer en sneller beschikbaar te maken zodat organisaties datagedreven innovatie kunnen realiseren. Als gevolg hiervan hebben Wim Kees en Syntho de prestigieuze Philips Innovation Award gewonnen, de SAS global hackathon in gezondheidszorg en life science gewonnen en door NVIDIA geselecteerd als leidende generatieve AI Scale-Up.