De onzichtbare boosdoener van AI: het ontrafelen van de innerlijke vooroordelen

Bias blogserie: deel 1

Introductie

In onze wereld van steeds kunstmatigere vormen van intelligentie komen machines die belast zijn met het nemen van complexe beslissingen steeds vaker voor. Er is een groeiende hoeveelheid literatuur die het gebruik van AI aangeeft in verschillende domeinen, zoals het bedrijfsleven, besluitvorming met hoge inzet en de afgelopen jaren in de medische sector. Met deze groeiende prevalentie hebben mensen echter de tendensen in deze systemen opgemerkt; Dat wil zeggen: hoewel ze inherent zijn ontworpen om puur patronen in de data te volgen, hebben ze tekenen van vooroordeel vertoond, in de zin dat er verschillende seksistische en discriminerende gedragingen kunnen worden waargenomen. De recente Europese AI-wet, bestrijkt ook de kwestie van dergelijke vooroordelen vrij uitgebreid en legt een basis voor het aanpakken van de daarmee samenhangende problemen.

Door de jaren heen van technische documentatie hebben mensen de neiging gehad om de term ‘vooroordeel’ te gebruiken om dit scheve gedrag ten opzichte van bepaalde demografische groepen te beschrijven; een woord waarvan de betekenis varieert, wat verwarring veroorzaakt en de taak om het aan te pakken bemoeilijkt.

Dit artikel is het eerste in een reeks blogposts over het onderwerp vooringenomenheid. In deze serie streven we ernaar u een duidelijk, begrijpelijk inzicht te geven in de vooroordelen in AI. We introduceren manieren om vooroordelen te meten en te minimaliseren en onderzoeken de rol van synthetische data op dit pad naar eerlijkere systemen. We geven u ook een kijkje in hoe Syntho, een toonaangevende speler op het gebied van het genereren van synthetische data, aan deze inspanning kan bijdragen. Dus of u nu een praktijkbeoefenaar bent die op zoek is naar bruikbare inzichten of gewoon nieuwsgierig bent naar dit onderwerp, u bent op de juiste plek.

Vooroordeel in actie: een voorbeeld uit de praktijk

Je vraagt je misschien af: “Deze vooringenomenheid in AI is heel belangrijk, maar wat betekent het voor mij, voor gewone mensen?” De waarheid is dat de impact verreikend is, vaak onzichtbaar maar krachtig. Vooringenomenheid bij AI is niet louter een academisch concept; het is een reëel probleem met ernstige gevolgen.

Neem het Nederlandse kinderwelzijnsschandaal als voorbeeld. Het geautomatiseerde systeem, zogenaamd een hulpmiddel dat is ontwikkeld om eerlijke en efficiënte resultaten te genereren met minimale menselijke tussenkomst, was bevooroordeeld. Het heeft duizenden ouders ten onrechte gemarkeerd wegens fraude op basis van gebrekkige data en aannames. Het resultaat? Gezinnen raakten in rep en roer, persoonlijke reputatie werd beschadigd en financiële problemen, allemaal als gevolg van vooroordelen in een AI-systeem. Het zijn voorbeelden als deze die de urgentie benadrukken van het aanpakken van vooroordelen op het gebied van AI.

Bron: "Compensatie ouders toeslagenaffaire kan zomaar tot 2030 duren”, 2023. NR

Maar laten we daar niet bij blijven. Dit incident is geen op zichzelf staand geval van vooringenomenheid die grote schade aanricht. De impact van vooringenomenheid in AI strekt zich uit tot alle hoeken van ons leven. Van wie wordt aangenomen voor een baan, wie wordt goedgekeurd voor een lening, tot wie welke medische behandeling krijgt: bevooroordeelde AI-systemen kunnen bestaande ongelijkheden bestendigen en nieuwe creëren.

Denk hier eens over na: een AI-systeem dat is getraind op bevooroordeelde historische data zou een goed gekwalificeerde kandidaat een baan kunnen ontzeggen, simpelweg vanwege zijn geslacht of etniciteit. Of een bevooroordeeld AI-systeem zou een lening aan een verdienstelijke kandidaat kunnen weigeren vanwege zijn postcode. Dit zijn niet alleen hypothetische scenario’s; ze gebeuren nu.

De specifieke soorten vooroordelen, zoals historische vooroordelen en meetvooroordelen, leiden tot dergelijke gebrekkige beslissingen. Ze zijn inherent aan de data, diep geworteld in maatschappelijke vooroordelen en weerspiegeld in de ongelijke uitkomsten tussen verschillende demografische groepen. Ze kunnen de beslissingen van voorspellende modellen vertekenen en tot een oneerlijke behandeling leiden.

In het grote geheel kan vooringenomenheid in AI fungeren als een stille beïnvloeder, die op subtiele wijze onze samenleving en ons leven vormgeeft, vaak op manieren die we ons niet eens realiseren. Al deze hierboven genoemde punten kunnen ertoe leiden dat u zich afvraagt waarom er geen actie is ondernomen om te stoppen, en of het zelfs mogelijk is.

Met nieuwe technologische ontwikkelingen wordt het zelfs steeds toegankelijker om dergelijke problemen aan te pakken. De eerste stap om dit probleem aan te pakken is echter het begrijpen en erkennen van het bestaan en de impact ervan. Voorlopig is de erkenning van het bestaan ervan gecreëerd, waardoor de kwestie van ‘begrijpen’ nog steeds behoorlijk vaag blijft.

Vooroordelen begrijpen

Hoewel de oorspronkelijke definitie van vooringenomenheid zoals gepresenteerd door de Cambridge woordenboek niet te ver afdwaalt van het hoofddoel van het woord, aangezien het betrekking heeft op AI, zijn er zelfs van deze unieke definitie veel verschillende interpretaties mogelijk. Taxonomieën, zoals die gepresenteerd door onderzoekers zoals Hellström et al (2020) en Kliegr (2021), bieden diepere inzichten in de definitie van vooringenomenheid. Een simpele blik op deze artikelen zal echter onthullen dat een grote vernauwing van de definitie van de term nodig is om het probleem effectief aan te pakken.

Hoewel het een verandering van gebeurtenissen is, kan men, om de betekenis van vooringenomenheid optimaal te definiëren en over te brengen, beter het tegenovergestelde definiëren, namelijk Eerlijkheid.

Het definiëren van eerlijkheid

Zoals het wordt gedefinieerd in verschillende recente literatuur, zoals Castelnovo et al. (2022)kan eerlijkheid worden uitgewerkt, gegeven een goed begrip van de term potentiële ruimte. Zoals het bestaat, verwijst potentiële ruimte (PS) naar de omvang van de capaciteiten en kennis van een individu, ongeacht of hij of zij tot een bepaalde demografische groep behoort. Gegeven deze definitie van het concept van PS kan men rechtvaardigheid gemakkelijk definiëren als de gelijkheid van behandeling tussen twee individuen met gelijke PS, ongeacht hun waarneembare en verborgen verschillen in vooroordelen veroorzakende parameters (zoals ras, leeftijd of geslacht). Elke afwijking van deze definitie, ook wel gelijke kansen genoemd, is een duidelijke indicatie van vooringenomenheid en verdient verder onderzoek.

De beoefenaars onder de lezers zouden kunnen opmerken dat het bereiken van iets zoals hier gedefinieerd volkomen onmogelijk zou kunnen zijn gezien de inherente vooroordelen die in onze wereld bestaan. Dat is waar! De wereld waarin we leven, samen met alle data die worden verzameld over gebeurtenissen in deze wereld, is onderhevig aan veel historische en statistische vooroordelen. Dit vermindert inderdaad het vertrouwen dat we op een dag de gevolgen van vooringenomenheid op voorspellende modellen die op dergelijke ‘bevooroordeelde’ data zijn getraind, volledig zullen kunnen verzachten. Door het gebruik van verschillende methoden kan men echter proberen de gevolgen van vooringenomenheid te minimaliseren. Als dit het geval is, zal de terminologie die in de rest van deze blogpost(s) wordt gebruikt, verschuiven naar het idee om de impact van vooringenomenheid te minimaliseren in plaats van deze volledig te verzachten.

Oké! Dus nu er een idee naar voren is gekomen over wat vooroordeel is en hoe je het bestaan ervan zou kunnen evalueren; Als we het probleem echter goed willen aanpakken, moeten we weten waar al deze vooroordelen vandaan komen.

De bronnen en typen begrijpen

Bestaand onderzoek biedt waardevolle inzichten in de verschillende soorten vooroordelen in machine learning. Als Mehrabi et. al. (2019) zijn overgegaan tot het verdelen van vooroordelen in machinaal leren, kunnen vooroordelen in drie hoofdcategorieën worden verdeeld. Namelijk die van:

- Data to Algorithm: een categorie die vooroordelen omvat die voortkomen uit de data zelf. Zou dat veroorzaakt kunnen worden door gebrekkige dataverzameling, inherente vooroordelen die in de wereld bestaan, enz.

- Algorithm to User: een categorie die zich richt op vooroordelen die voortkomen uit het ontwerp en de functionaliteit van de algoritmen. Het omvat de manier waarop algoritmen bepaalde datapunten kunnen interpreteren, wegen of overwegen ten opzichte van andere, wat tot vertekende resultaten kan leiden.

- User to Data: heeft betrekking op vooroordelen die voortkomen uit gebruikersinteractie met het systeem. De manier waarop gebruikers data invoeren, hun inherente vooroordelen of zelfs hun vertrouwen in de systeemoutputs kunnen de uitkomsten beïnvloeden.

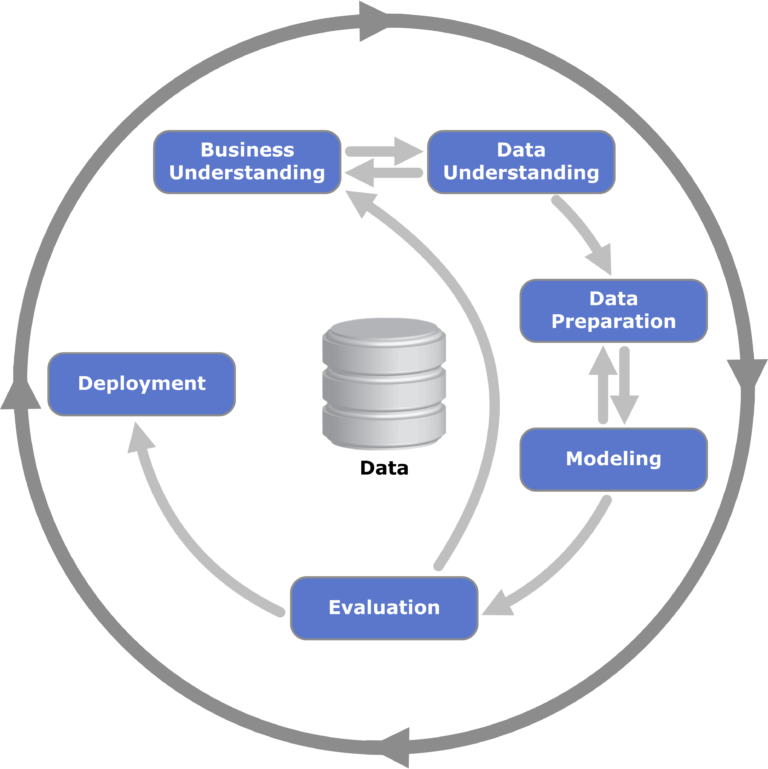

Figuur 1: Een visualisatie van het CRISP-DM-framework voor datamining; vaak gebruikt in datamining en relevant voor het proces van het identificeren van de stadia waarin vooringenomenheid kan ontstaan.

Hoewel de namen indicatief zijn voor de vorm van vooringenomenheid, kun je nog steeds vragen hebben over de soorten vooroordelen die je onder deze overkoepelende termen zou kunnen categoriseren. Voor de enthousiastelingen onder onze lezers hebben we links gegeven naar literatuur die verband houdt met deze terminologie en classificatie. Voor de eenvoud zullen we in deze blogpost een aantal geselecteerde vooroordelen bespreken die relevant zijn voor de situatie (die bijna allemaal in de categorie data tot algoritme vallen). De specifieke soorten vooroordelen zijn als volgt:

- Historische vooroordelen: een soort vooroordelen die inherent zijn aan de data en die worden veroorzaakt door de natuurlijke vooroordelen die in de wereld bestaan in verschillende sociale groepen en in de samenleving in het algemeen. Het is vanwege de inherente aard van deze data in de wereld dat deze niet kunnen worden verzacht door middel van verschillende manieren van bemonstering en kenmerkselectie.

- Measurement Bias & Representation Bias: Deze twee nauw verwante biases treden op wanneer de verschillende subgroepen van de dataset ongelijke hoeveelheden “gunstige” uitkomsten bevatten. Dit soort vertekening kan daarom de uitkomst van voorspellende modellen vertekenen

- Algoritmische bias: bias die puur verband houdt met het gebruikte algoritme. Zoals ook is waargenomen in uitgevoerde tests (hierover verderop in dit bericht uitgewerkt), kan dit soort vertekening een enorm effect hebben op de eerlijkheid van een bepaald algoritme.

Deze fundamentele inzichten in vooroordelen in machinaal leren zullen worden gebruikt om het probleem in latere berichten effectiever aan te pakken.

Conclusie

In dit onderzoek naar vooroordelen binnen kunstmatige intelligentie hebben we de diepgaande implicaties ervan belicht in onze steeds meer door AI aangedreven wereld. Van praktijkvoorbeelden zoals het Nederlandse kinderwelzijnsschandaal tot de ingewikkelde nuances van categorieën en typen vooroordelen: het is duidelijk dat het herkennen en begrijpen van vooroordelen van het grootste belang is.

Hoewel de uitdagingen die voortkomen uit vooroordelen – of deze nu historisch, algoritmisch of door de gebruiker veroorzaakt zijn – aanzienlijk zijn, zijn ze niet onoverkomelijk. Als we de oorsprong en uitingen van vooringenomenheid goed begrijpen, zijn we beter toegerust om deze aan te pakken. Herkenning en begrip zijn echter slechts de uitgangspunten.

Naarmate we verder komen in deze serie, zal onze volgende focus liggen op de tastbare instrumenten en raamwerken die ons ter beschikking staan. Hoe meten we de mate van vertekening in AI-modellen? En nog belangrijker: hoe minimaliseren we de impact ervan? Dit zijn de prangende vragen waar we ons hierna op zullen verdiepen, om ervoor te zorgen dat AI, naarmate AI zich blijft ontwikkelen, dit doet in een richting die zowel eerlijk als performant is.

Gegevens zijn synthetisch, maar ons team is echt!

Neem contact op met Syntho en een van onze experts neemt razendsnel contact met je op om de waarde van synthetische data te onderzoeken!