مصنوعی ڈیٹا جنریٹرز میں افادیت اور مشابہت کا اندازہ: ایک تکنیکی گہرا غوطہ اور تقابلی تجزیہ

تعارف

آج کے ڈیجیٹل دور میں، ڈیٹا پرائیویسی کے بارے میں بیداری میں نمایاں اضافہ ہوا ہے۔ صارفین تیزی سے اپنے ڈیٹا کو ایک منفرد ڈیجیٹل فنگر پرنٹ کے طور پر پہچانتے ہیں، جس سے ڈیٹا کی خلاف ورزی کی صورت میں ان کی پرائیویسی کو خطرہ ہوتا ہے۔ اس تشویش کو جی ڈی پی آر جیسے ضوابط سے مزید تقویت ملتی ہے، جو صارفین کو اپنے ڈیٹا کو حذف کرنے کی درخواست کرنے کا اختیار دیتے ہیں۔ اگرچہ بہت زیادہ ضرورت ہے، یہ قانون سازی کمپنیوں کے لیے بہت مہنگی ہو سکتی ہے کیونکہ ڈیٹا تک رسائی کم سے کم ہے۔ پابندیاں جن پر قابو پانے کے لیے اکثر وقت اور وسائل خرچ ہوتے ہیں۔

کی میز کے مندرجات

مصنوعی ڈیٹا جنریٹرز کیا ہیں؟

مصنوعی ڈیٹا درج کریں، اس مسئلے کا حل۔ مصنوعی ڈیٹا جنریٹر ڈیٹا سیٹ بناتے ہیں جو گمنامی اور رازداری کو برقرار رکھتے ہوئے حقیقی صارف کے ڈیٹا کی نقل کرتے ہیں۔ یہ نقطہ نظر تمام صنعتوں میں، صحت کی دیکھ بھال سے لے کر مالیات تک، جہاں پرائیویسی سب سے اہم ہے۔

صحیح مصنوعی ڈیٹا جنریشن کا طریقہ کیسے منتخب کریں؟

مصنوعی ڈیٹا جنریشن کے متنوع منظر نامے میں، طریقوں کی کثرت دستیاب ہے، ہر ایک اپنی منفرد صلاحیتوں کے ساتھ توجہ کے لیے کوشاں ہے۔ کسی خاص ایپلیکیشن کے لیے موزوں ترین طریقہ کا انتخاب کرنے کے لیے ہر آپشن کی کارکردگی کی خصوصیات کی مکمل تفہیم کی ضرورت ہوتی ہے۔ یہ باخبر فیصلہ کرنے کے لیے اچھی طرح سے متعین میٹرکس کے سیٹ کی بنیاد پر مختلف مصنوعی ڈیٹا جنریٹرز کی ایک جامع تشخیص کی ضرورت ہے۔

اس کے بعد ایک معروف اوپن سورس فریم ورک، سنتھیٹک ڈیٹا والٹ (SDV) کے ساتھ ساتھ سنتھو انجن کا سخت تقابلی تجزیہ ہے۔ اس تجزیے میں، ہم نے عام طور پر استعمال ہونے والی بہت سی میٹرکس کا استعمال کیا جیسے کہ شماریاتی وفاداری، پیشین گوئی کی درستگی اور انٹر متغیر تعلق۔

مصنوعی ڈیٹا کی تشخیص میٹرکس

کسی بھی مخصوص میٹرک کو متعارف کرانے سے پہلے، ہمیں یہ تسلیم کرنا چاہیے کہ مصنوعی ڈیٹا کا جائزہ لینے کے بارے میں بہت سے نظریات ہیں، جن میں سے ہر ایک ڈیٹا کے ایک خاص پہلو کی بصیرت فراہم کرتا ہے۔ اس بات کو ذہن میں رکھتے ہوئے، درج ذیل تین زمرے اہم اور جامع ہونے کے طور پر سامنے آتے ہیں۔ یہ میٹرکس ڈیٹا کے معیار کے مختلف پہلوؤں کی بصیرت فراہم کرتے ہیں۔ یہ زمرے ہیں:

- شماریاتی مخلصی میٹرکس: ڈیٹا کی بنیادی شماریاتی خصوصیات کی جانچ کرنا، جیسے کہ ذرائع اور تغیرات، اس بات کو یقینی بنانے کے لیے کہ مصنوعی ڈیٹا اصل ڈیٹاسیٹ کے شماریاتی پروفائل کے ساتھ ہم آہنگ ہو۔

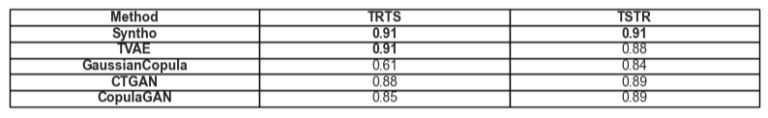

- پیشین گوئی کی درستگی: مصنوعی ڈیٹا جنریشن ماڈل کی کارکردگی کا جائزہ لینا، اصل ڈیٹا کے ساتھ تربیت یافتہ، اور مصنوعی ڈیٹا (ٹرین ریئل - ٹیسٹ سنتھیٹک، TRTS) اور اس کے برعکس (ٹرین سنتھیٹک - ٹیسٹ ریئل، TSTR) کا جائزہ لینا

- متغیر تعلقات: اس مشترکہ زمرے میں شامل ہیں:

- خصوصیت کا تعلق: ہم اس بات کا اندازہ لگاتے ہیں کہ مصنوعی اعداد و شمار باہمی ربط کے قابلیت کا استعمال کرتے ہوئے متغیر کے درمیان تعلقات کو کتنی اچھی طرح سے برقرار رکھتا ہے۔ ایک معروف میٹرک جیسا کہ Propensity Mean Squared Error (PMSE) اس قسم کا ہوگا۔

- باہمی معلومات: ہم متغیرات کے درمیان باہمی انحصار کی پیمائش کرتے ہیں تاکہ ان رشتوں کی گہرائی کو صرف ارتباط سے باہر سمجھا جا سکے۔

تقابلی تجزیہ: سنتھو انجن بمقابلہ اوپن سورس متبادل

تقابلی تجزیہ ایک معیاری تشخیصی فریم ورک اور تمام ماڈلز بشمول سنتھو انجن اور SDV ماڈلز میں یکساں جانچ تکنیک کا استعمال کرتے ہوئے کیا گیا تھا۔ یکساں ذرائع سے ڈیٹا سیٹس کی ترکیب کرکے اور انہیں ایک ہی شماریاتی ٹیسٹ اور مشین لرننگ ماڈل کے جائزوں سے مشروط کرکے، ہم ایک منصفانہ اور غیر جانبدارانہ موازنہ کو یقینی بناتے ہیں۔ سیکشن جو مندرجہ بالا پیش کردہ میٹرکس کی رینج میں ہر مصنوعی ڈیٹا جنریٹر کی کارکردگی کی تفصیلات دیتا ہے۔

جہاں تک تشخیص کے لیے استعمال کیے گئے ڈیٹاسیٹ کا تعلق ہے، ہم نے استعمال کیا۔ UCI بالغوں کی مردم شماری کا ڈیٹا سیٹ جو مشین لرننگ کمیونٹی میں ایک معروف ڈیٹاسیٹ ہے۔ ہم نے تمام ٹریننگ سے پہلے ڈیٹا کو صاف کیا اور پھر ڈیٹاسیٹ کو دو سیٹوں میں تقسیم کیا (ایک ٹریننگ اور ٹیسٹنگ کے لیے ایک ہولڈ آؤٹ سیٹ)۔ ہم نے ہر ایک ماڈل کے ساتھ 1 ملین نئے ڈیٹا پوائنٹس بنانے کے لیے ٹریننگ سیٹ کا استعمال کیا اور ان تیار کردہ ڈیٹا سیٹس پر مختلف میٹرکس کا جائزہ لیا۔ مشین لرننگ کے مزید جائزوں کے لیے، ہم نے میٹرکس کی جانچ کرنے کے لیے ہولڈ آؤٹ سیٹ کا استعمال کیا جیسے کہ TSTR اور TRTS سے متعلق۔

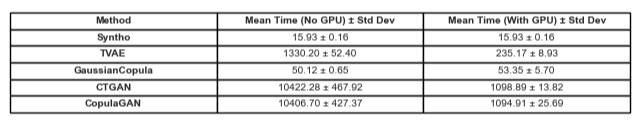

ہر جنریٹر کو پہلے سے طے شدہ پیرامیٹرز کے ساتھ چلایا جاتا تھا۔ جیسا کہ کچھ ماڈلز، جیسے سنتھو، کسی بھی ٹیبلر ڈیٹا پر آؤٹ آف دی باکس کام کر سکتے ہیں، کوئی ٹھیک ٹیوننگ نہیں کی گئی۔ ہر ماڈل کے لیے صحیح ہائپر پیرامیٹرس کی تلاش میں کافی وقت لگے گا، اور جدول 2 پہلے سے ہی سنتھو کے ماڈل اور اس کے خلاف آزمائے گئے ماڈل کے درمیان وقت کا بڑا فرق ظاہر کرتا ہے۔

یہ قابل ذکر ہے کہ SDV میں باقی ماڈلز کے برعکس، Gaussian Copula Synthesizer شماریاتی طریقوں پر مبنی ہے۔ اس کے برعکس، باقی عصبی نیٹ ورکس پر مبنی ہیں جیسے جنریٹو ایڈورسریل نیٹ ورکس (GAN) ماڈلز اور تغیراتی آٹو انکوڈرز۔ یہی وجہ ہے کہ Gaussian Copula کو زیر بحث تمام ماڈلز کے لیے ایک بنیاد کے طور پر دیکھا جا سکتا ہے۔

نتائج کی نمائش

ڈیٹا کوالٹی

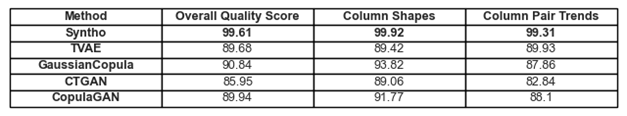

تصویر 1. تمام ماڈلز کے لیے بنیادی معیار کے نتائج کا تصور

اعداد و شمار میں رجحانات اور نمائندگی کے بارے میں پہلے بحث کی گئی تعمیل کو شکل 1 اور جدول 1 میں پایا جا سکتا ہے۔ یہاں، استعمال میں ہر ایک میٹرکس کی تشریح اس طرح کی جا سکتی ہے:

- مجموعی معیار کا اسکور: اعداد و شمار کی مماثلت اور ڈیٹا کی خصوصیات جیسے مختلف پہلوؤں کو ملا کر مصنوعی ڈیٹا کے معیار کا مجموعی جائزہ۔

- کالم کی شکلیں: اس بات کا اندازہ لگاتا ہے کہ آیا مصنوعی ڈیٹا ہر کالم کے حقیقی ڈیٹا کی طرح تقسیم کی شکل کو برقرار رکھتا ہے۔

- کالم جوڑے کے رجحانات: حقیقی اعداد و شمار کے مقابلے مصنوعی ڈیٹا میں کالموں کے جوڑوں کے درمیان تعلق یا ارتباط کا اندازہ کرتا ہے۔

مجموعی طور پر، یہ دیکھا جا سکتا ہے کہ سنتھو پورے بورڈ میں بہت زیادہ اسکور حاصل کرتا ہے۔ شروع کرنے کے لیے، مجموعی طور پر ڈیٹا کے معیار کو دیکھتے ہوئے (SDV میٹرکس لائبریری سے جانچا جاتا ہے) Syntho 99% سے اوپر کا نتیجہ حاصل کر سکتا ہے (99.92% کی کالم کی شکل کی پابندی اور 99.31% کی کالم جوڑی کی شکل کی پابندی کے ساتھ)۔ یہ اس وقت ہے جب SDV کو زیادہ سے زیادہ 90.84% کا نتیجہ ملتا ہے (Gaussian Copula کے ساتھ، کالم کی شکل کی پابندی 93.82% اور کالم جوڑی کی شکل کی پابندی 87.86% ہے)۔

جدول 1۔ فی ماڈل ہر تیار کردہ ڈیٹاسیٹ کے کوالٹی اسکورز کی ٹیبلولر نمائندگی

ڈیٹا کوریج

SDV کا تشخیصی رپورٹ ماڈیول ہماری توجہ میں لاتا ہے کہ SDV سے تیار کردہ ڈیٹا (تمام صورتوں میں) عددی حدود کے 10% سے زیادہ غائب ہے۔ Triplet-based Variational Autoencoder (TVAE) کے معاملے میں، اصل ڈیٹاسیٹ کے مقابلے میں اتنی ہی مقدار میں دوٹوک ڈیٹا بھی غائب ہے۔ Syntho کے استعمال سے حاصل کردہ نتائج کے ساتھ ایسی کوئی انتباہات پیدا نہیں کی گئیں۔

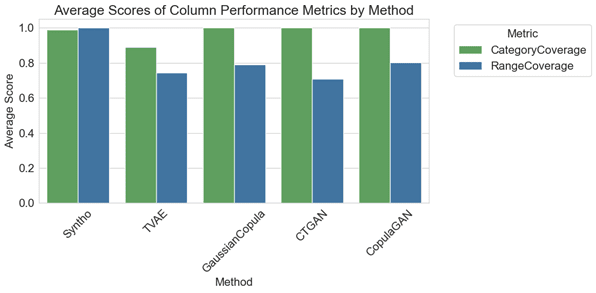

شکل 2. تمام ماڈلز کے لیے اوسط کالم وار کارکردگی میٹرکس کا تصور

تقابلی تجزیہ میں، شکل 2 کا پلاٹ واضح کرتا ہے کہ SDV اپنے کچھ ماڈلز (یعنی GaussianCopula، CopulaGAN، اور Conditional Tabular GAN - CTGAN کے ساتھ) زمرہ کی کوریج میں معمولی طور پر بہتر نتائج حاصل کرتا ہے۔ اس کے باوجود، اس بات کو اجاگر کرنا ضروری ہے کہ سنتھو کے ڈیٹا کی وشوسنییتا SDV ماڈلز سے زیادہ ہے، کیونکہ زمرہ جات اور رینجز میں کوریج میں تفاوت کم سے کم ہے، جو کہ محض 1.1% فرق کو ظاہر کرتا ہے۔ اس کے برعکس، SDV ماڈلز 14.6% سے لے کر 29.2% تک کافی تغیرات کا مظاہرہ کرتے ہیں۔

یہاں نمائندگی شدہ میٹرکس کی تشریح اس طرح کی جا سکتی ہے:

- زمرہ کوریج: حقیقی ڈیٹا کے مقابلے مصنوعی ڈیٹا میں تمام زمروں کی موجودگی کی پیمائش کرتا ہے۔

- رینج کوریج: اندازہ کرتا ہے کہ مصنوعی ڈیٹا میں اقدار کی رینج حقیقی ڈیٹا سے کتنی اچھی طرح سے ملتی ہے۔

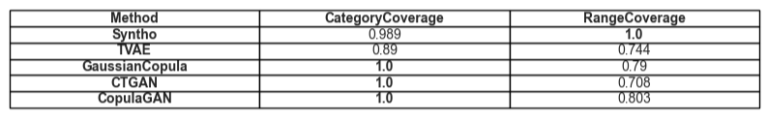

جدول 2. فی ماڈل ایک خاص قسم کی اوسط کوریج کی ٹیبلولر نمائندگی

یوٹیلٹی

مصنوعی ڈیٹا کی افادیت کے موضوع کی طرف بڑھتے ہوئے، ڈیٹا پر تربیتی ماڈلز کا معاملہ متعلقہ ہو جاتا ہے۔ تمام فریم ورکس کے درمیان متوازن اور منصفانہ موازنہ کرنے کے لیے ہم نے SciKit Learn لائبریری سے ڈیفالٹ گریڈینٹ بوسٹنگ کلاسیفائر کا انتخاب کیا ہے، یہ دیکھتے ہوئے کہ اسے باکس سے باہر کی ترتیبات کے ساتھ ایک اچھی کارکردگی کا مظاہرہ کرنے والے ماڈل کے طور پر قبول کیا جاتا ہے۔

دو مختلف ماڈلز کو تربیت دی جاتی ہے، ایک مصنوعی ڈیٹا (TSTR کے لیے) اور ایک اصل ڈیٹا پر (TRTS کے لیے)۔ مصنوعی ڈیٹا پر تربیت یافتہ ماڈل کا اندازہ ہولڈ آؤٹ ٹیسٹ سیٹ (جو مصنوعی ڈیٹا بنانے کے دوران استعمال نہیں کیا گیا تھا) کے ذریعے کیا جاتا ہے اور اصل ڈیٹا پر تربیت یافتہ ماڈل کو مصنوعی ڈیٹا سیٹ پر جانچا جاتا ہے۔

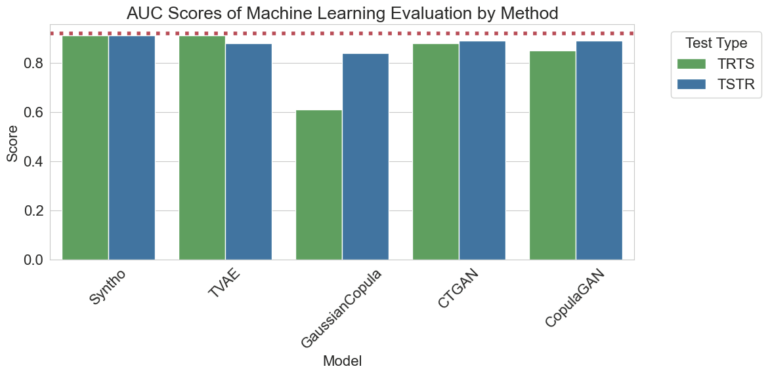

شکل 3. فی ماڈل فی طریقہ کار (AUC) سکور کے تحت علاقے کا تصور

اوپر دیکھے گئے نتائج دیگر طریقوں کے مقابلے میں سنتھو انجن کے ذریعہ مصنوعی ڈیٹا کی تیاری کی برتری کو ظاہر کرتے ہیں، یہ دیکھتے ہوئے کہ مختلف طریقوں سے حاصل کردہ نتائج میں کوئی فرق نہیں ہے (مصنوعی اور حقیقی ڈیٹا کے درمیان اعلی مماثلت کی طرف اشارہ کرتے ہوئے)۔ اس کے علاوہ، پلاٹ میں موجود سرخ نقطے والی لائن ٹرین ریئل، ٹیسٹ ریئل (TRTR) ٹیسٹ کی بنیادی کارکردگی کا جائزہ لے کر حاصل کردہ نتیجہ ہے تاکہ مشاہدہ شدہ میٹرکس کے لیے ایک بنیادی لائن فراہم کی جا سکے۔ یہ لائن 0.92 کی قدر کی نمائندگی کرتی ہے، جو کہ اصلی ڈیٹا پر تربیت یافتہ اور حقیقی ڈیٹا پر ٹیسٹ کیے گئے ماڈل کے ذریعے حاصل کردہ وکر سکور (AUC سکور) کے نیچے کا علاقہ ہے۔

جدول 3. فی ماڈل بالترتیب TRTS اور TSTR کے ذریعہ حاصل کردہ AUC اسکورز کی ٹیبلولر نمائندگی۔

وقت کے لحاظ سے موازنہ

قدرتی طور پر، ان نتائج کو پیدا کرنے میں لگائے گئے وقت پر غور کرنا بہت ضروری ہے۔ ذیل کا تصور صرف اس کی وضاحت کرتا ہے۔

تصویر 5. تربیت اور کارکردگی کا مظاہرہ کرنے میں لگنے والے وقت کا تصور مصنوعی ڈیٹا کی پیداوار GPU کے ساتھ اور بغیر ماڈل کے ساتھ 10 لاکھ ڈیٹا پوائنٹس۔

شکل 5 دو مختلف ترتیبات میں مصنوعی ڈیٹا تیار کرنے میں لگنے والے وقت کی وضاحت کرتا ہے۔ جن میں سے پہلی (یہاں GPU کے بغیر کہا جاتا ہے)، 16 GHz پر چلنے والے 2.20 کور کے ساتھ Intel Xeon CPU والے سسٹم پر ٹیسٹ رنز تھے۔ "GPU کے ساتھ چلائے گئے" کے بطور نشان زد ٹیسٹ AMD Ryzen 9 7945HX CPU والے سسٹم پر تھے جس میں 16 کور 2.5GHz پر چل رہے تھے اور NVIDIA GeForce RTX 4070 Laptop GPU۔ جیسا کہ تصویر 2 اور ذیل میں جدول 2 میں نمایاں ہے، یہ دیکھا جا سکتا ہے کہ سنتھو مصنوعی ڈیٹا (دونوں منظرناموں میں) پیدا کرنے میں نمایاں طور پر تیز ہے جو کہ متحرک ورک فلو میں اہم ہے۔

جدول 5۔ وقت کی ایک ٹیبلر نمائندگی مصنوعی ڈیٹا کی پیداوار GPU کے ساتھ اور بغیر ہر ماڈل کے ساتھ 10 لاکھ ڈیٹا پوائنٹس

نتائج صحیح مصنوعی ڈیٹا جنریشن کے طریقہ کار کو منتخب کرنے میں مکمل معیار کی جانچ کی اہمیت کو واضح کرتی ہیں۔ Syntho's Engine، اپنے AI سے چلنے والے اپروچ کے ساتھ، بعض میٹرکس میں قابل ذکر طاقتوں کا مظاہرہ کرتا ہے، جبکہ SDV جیسے اوپن سورس ٹولز اپنی استعداد اور کمیونٹی سے چلنے والی بہتری میں چمکتے ہیں۔

جیسا کہ مصنوعی ڈیٹا کا شعبہ مسلسل تیار ہوتا جا رہا ہے، ہم آپ کو ان میٹرکس کو اپنے پروجیکٹس میں لاگو کرنے، ان کی پیچیدگیوں کو دریافت کرنے اور اپنے تجربات کا اشتراک کرنے کی ترغیب دیتے ہیں۔ مستقبل کی پوسٹس کے لیے دیکھتے رہیں جہاں ہم دوسرے میٹرکس میں گہرائی میں جائیں گے اور ان کے اطلاق کی حقیقی دنیا کی مثالوں کو اجاگر کریں گے۔

دن کے اختتام پر، ان لوگوں کے لیے جو مصنوعی ڈیٹا پر پانی کی جانچ کرنا چاہتے ہیں، پیش کردہ اوپن سورس متبادل قابل رسائی انتخاب ہو سکتا ہے۔ تاہم، اس جدید ٹیکنالوجی کو اپنے ترقیاتی عمل میں شامل کرنے والے پیشہ ور افراد کے لیے، بہتری کے کسی بھی موقع کو استعمال کرنا چاہیے اور تمام رکاوٹوں سے گریز کرنا چاہیے۔ لہذا دستیاب بہترین آپشن کا انتخاب کرنا ضروری ہے۔ اوپر فراہم کردہ تجزیوں سے یہ بات بالکل واضح ہو جاتی ہے کہ سنتھو اور اس کے ساتھ سنتھو انجن پریکٹیشنرز کے لیے ایک بہت ہی قابل ٹول ہے۔

سنتھو کے بارے میں

سنتو۔ ایک سمارٹ مصنوعی ڈیٹا جنریشن پلیٹ فارم مہیا کرتا ہے، متعدد مصنوعی ڈیٹا فارمز اور جنریشن کے طریقوں کا فائدہ اٹھاتے ہوئے، تنظیموں کو ذہانت سے ڈیٹا کو مسابقتی برتری میں تبدیل کرنے کے لیے بااختیار بناتا ہے۔ ہمارا AI سے تیار کردہ مصنوعی ڈیٹا اصل ڈیٹا کے شماریاتی نمونوں کی نقل کرتا ہے، درستگی، رازداری اور رفتار کو یقینی بناتا ہے، جیسا کہ SAS جیسے بیرونی ماہرین نے اندازہ کیا ہے۔ سمارٹ ڈی-شناختی خصوصیات اور مسلسل نقشہ سازی کے ساتھ، حوالہ جاتی سالمیت کو برقرار رکھتے ہوئے حساس معلومات کی حفاظت کی جاتی ہے۔ ہمارا پلیٹ فارم غیر پیداواری ماحول کے لیے ٹیسٹ ڈیٹا کی تخلیق، نظم و نسق اور کنٹرول کو قابل بناتا ہے، ہدف بنائے گئے منظرناموں کے لیے اصول پر مبنی مصنوعی ڈیٹا تیار کرنے کے طریقوں کو استعمال کرتا ہے۔ مزید برآں، صارفین آسانی کے ساتھ جامع ٹیسٹنگ اور ترقیاتی منظرنامے تیار کرنے کے لیے مصنوعی ڈیٹا پروگرام کے مطابق تیار کر سکتے ہیں اور حقیقت پسندانہ ٹیسٹ ڈیٹا حاصل کر سکتے ہیں۔

کیا آپ مصنوعی ڈیٹا کی مزید عملی ایپلی کیشنز سیکھنا چاہتے ہیں؟ بلا جھجھک شیڈول ڈیمو!

مصنفین کے بارے میں

سافٹ ویئر انجینئرنگ انٹرن

روہam ڈیلفٹ یونیورسٹی آف ٹیکنالوجی میں بیچلر کا طالب علم ہے اور اس میں سافٹ ویئر انجینئرنگ کا انٹرن ہے۔ سنتو۔.

مشین سیکھنا انجینئر

میہائی نے پی ایچ ڈی کی ڈگری حاصل کی۔ برسٹل یونیورسٹی روبوٹکس پر لاگو ہائرارکیکل ریانفورسمنٹ لرننگ کے موضوع پر اور ایک ہے مشین لرننگ انجینئر اےt سنتو۔.

اپنے مصنوعی ڈیٹا گائیڈ کو ابھی محفوظ کریں!

- مصنوعی ڈیٹا کیا ہے؟

- تنظیمیں اسے کیوں استعمال کرتی ہیں؟

- مصنوعی ڈیٹا کلائنٹ کیسز کو ویلیو ایڈ کرنا

- آغاز کیسے کیا جائے