在人工智能形式日益增多的世界中,負責做出複雜決策的機器變得越來越普遍。 越來越多的文獻表明人工智能在商業、高風險決策等各個領域的應用,以及過去幾年在醫療領域的應用。 然而,隨著這種流行率的不斷提高,人們注意到了上述系統中的一些趨勢。 也就是說,雖然它們本質上是為了純粹遵循數據模式而設計的,但它們卻表現出了偏見的跡象,即可以觀察到各種性別歧視和歧視行為。 最近的 歐洲人工智能法案,也相當廣泛地涵蓋了這種偏見的問題,並為解決與之相關的問題奠定了基礎。

在多年的技術文檔中,人們傾向於使用“偏見”一詞來描述這種針對某些人群的傾斜行為。 這個詞的含義各不相同,導致混亂並使解決該問題的任務變得複雜。

本文是涵蓋偏見主題的一系列博客文章中的第一篇。 在本系列中,我們的目標是讓您對人工智能中的偏見有一個清晰易懂的理解。 我們將介紹衡量和最小化偏差的方法,並探討合成數據在通往更公平系統的道路上的作用。 我們還將讓您了解合成數據生成領域的領先企業 Syntho 如何為這項工作做出貢獻。 因此,無論您是尋求可行見解的從業者,還是只是對這個主題感到好奇,您都來對地方了。

你可能想知道,“人工智能中的這種偏見很重要,但這對我、對普通人來說意味著什麼?” 事實是,影響是深遠的,通常是看不見的,但卻是強大的。 人工智能中的偏見不僅僅是一個學術概念; 這是一個現實世界的問題,會帶來嚴重的後果。

以荷蘭兒童福利醜聞為例。 自動化系統被認為是一種以最少的人為乾預生成公平有效結果的工具,但存在偏見。 它基於有缺陷的數據和假設,錯誤地將數千名家長標記為欺詐。 結果? 家庭陷入混亂、個人聲譽受損、經濟困難,這一切都是人工智能係統的偏見造成的。 正是這樣的例子凸顯了解決人工智能偏見的緊迫性。

但我們還不止於此。 這起事件並不是偏見造成嚴重破壞的孤立案例。 人工智能偏見的影響延伸到我們生活的各個角落。 從誰被雇用、誰獲得貸款批准、到誰接受什麼樣的醫療——有偏見的人工智能係統可能會延續現有的不平等並創造新的不平等。

考慮一下:一個接受有偏見歷史數據訓練的人工智能係統可能會僅僅因為性別或種族而拒絕合格候選人的工作。 或者,有偏見的人工智能係統可能會因為郵政編碼而拒絕向符合資格的候選人提供貸款。 這些不僅僅是假設的場景;而且是真實的。 它們現在正在發生。

特定類型的偏差,例如歷史偏差和測量偏差,會導致此類有缺陷的決策。 它們是數據所固有的,深深植根於社會偏見,並反映在不同人口群體之間的不平等結果中。 它們可能會扭曲預測模型的決策並導致不公平的待遇。

從長遠來看,人工智能中的偏見可以充當沉默的影響者,以我們甚至沒有意識到的方式巧妙地塑造我們的社會和我們的生活。 所有上述幾點可能會讓您質疑為什麼沒有採取行動來阻止,以及是否有可能。

事實上,隨著新技術的進步,解決此類問題變得越來越容易。 然而,解決這個問題的第一步是理解並承認它的存在和影響。 目前,對其存在的承認已經形成,“理解”的問題仍然相當模糊。

雖然偏見的最初定義是由 劍橋詞典 雖然這個詞與人工智能相關,但它並沒有偏離這個詞的主要目的太遠,即使是這個單一的定義也可以有許多不同的解釋。 分類法,例如由研究人員提出的分類法,例如 Hellström 等人 (2020) 和 克利格爾 (2021),提供對偏見定義的更深入見解。 然而,簡單瀏覽一下這些論文就會發現,為了有效解決這個問題,需要極大地縮小該術語的定義。

雖然事件發生了變化,但為了最佳地定義和傳達偏見的含義,我們可以更好地定義相反的含義,即公平。

正如最近各種文獻中所定義的那樣,例如 卡斯泰爾諾沃等人。 (2022),在理解潛在空間一詞的情況下,可以對公平性進行詳細闡述。 就其存在而言,潛在空間(PS)是指個人的能力和知識程度,無論其屬於某個人口群體。 鑑於PS 概念的這一定義,人們可以輕鬆地將公平定義為具有相同PS 的兩個人之間的平等待遇,而不管他們在偏見誘導參數(例如種族、年齡或性別)方面存在可觀察到的和隱藏的差異。 任何偏離這一定義(也稱為機會平等)的行為都明確表明存在偏見,值得進一步調查。

讀者中的實踐者可能會注意到,鑑於我們世界中存在的固有偏見,實現此處定義的某些內容可能是完全不可能的。 那是真實的! 我們生活的世界,以及從這個世界上發生的事件收集的所有數據,都受到很多歷史和統計偏差的影響。 事實上,這降低了有一天完全減輕偏見對基於此類“偏見”數據訓練的預測模型的影響的信心。 然而,通過使用各種方法,人們可以盡量減少偏見的影響。 在這種情況下,本博客文章其餘部分中使用的術語將轉向最小化偏見影響而不是完全減輕偏見的想法。

好的! 現在我們已經提出了關於什麼是偏見以及如何評估其存在的想法; 然而,如果我們想正確解決這個問題,我們就需要知道所有這些偏見的根源。

現有研究為機器學習中不同類型的偏差提供了有價值的見解。 作為 梅赫拉比等。 等人。 (2019) 繼續劃分機器學習中的偏差,可以將偏差分為三大類。 即:

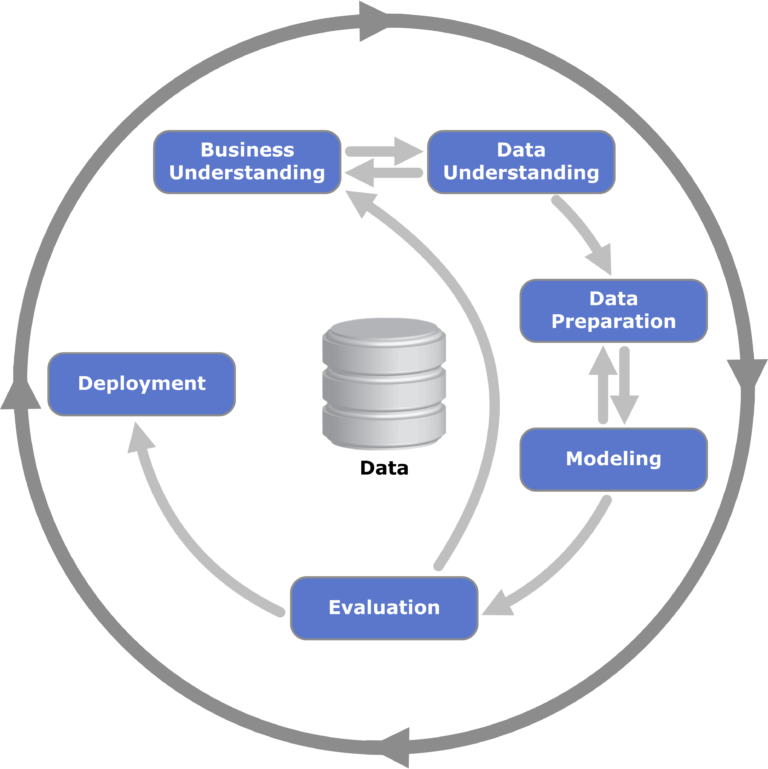

圖 1:數據挖掘 CRISP-DM 框架的可視化; 常用於數據挖掘,與識別可能出現偏差的階段的過程相關。

雖然這些名稱表明了偏見的形式,但人們可能仍然對這些總稱術語下可能歸類的偏見類型存有疑問。 對於我們的讀者中的愛好者,我們提供了一些與此術語和分類相關的文獻的鏈接。 為了在這篇博文中簡單起見,我們將介紹一些與情況相關的精選偏差(幾乎所有偏差都屬於數據到算法的類別)。 偏差的具體類型如下:

這些對機器學習偏差的基本理解將被利用,以便在後面的文章中更有效地解決問題。

在對人工智能內部偏見的探索中,我們闡明了它在日益人工智能驅動的世界中所具有的深遠影響。 從荷蘭兒童福利醜聞等現實世界的例子到偏見類別和類型錯綜複雜的細微差別,很明顯,認識和理解偏見至關重要。

雖然偏見帶來的挑戰——無論是歷史的、算法的還是用戶引起的——是巨大的,但它們並不是不可克服的。 牢牢掌握偏見的根源和表現形式,我們就能更好地解決這些問題。 然而,認可和理解只是起點。

隨著本系列文章的深入,我們的下一個重點將是我們可以使用的有形工具和框架。 我們如何衡量人工智能模型的偏差程度? 更重要的是,我們如何最大限度地減少其影響? 這些是我們接下來要深入研究的緊迫問題,確保隨著人工智能的不斷發展,它朝著既公平又高效的方向發展。