AI-genererad syntetisk data, enkel och snabb tillgång till högkvalitativ data?

AI genererade syntetisk data i praktiken

Syntho, en expert på AI-genererad syntetisk data, siktar på att vända privacy by design till en konkurrensfördel med AI-genererad syntetisk data. De hjälper organisationer att bygga en stark databas med enkel och snabb tillgång till högkvalitativ data och vann nyligen Philips Innovation Award.

Syntetisk datagenerering med AI är dock en relativt ny lösning som vanligtvis introducerar vanliga frågor. För att svara på dessa startade Syntho en fallstudie tillsammans med SAS, marknadsledare inom Advanced Analytics och AI-mjukvara.

I samarbete med Dutch AI Coalition (NL AIC) undersökte de värdet av syntetisk data genom att jämföra AI-genererad syntetisk data genererad av Syntho Engine med originaldata via olika bedömningar av datakvalitet, juridisk giltighet och användbarhet.

Är dataanonymisering inte en lösning?

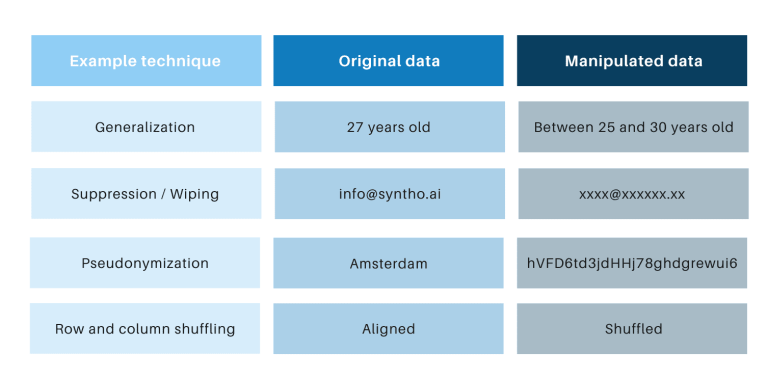

Klassiska anonymiseringstekniker har det gemensamt att de manipulerar originaldata för att förhindra spårning av individer. Exempel är generalisering, undertryckande, radering, pseudonymisering, datamaskering och blandning av rader och kolumner. Du hittar exempel i tabellen nedan.

Dessa tekniker introducerar tre viktiga utmaningar:

- De fungerar olika per datatyp och per datamängd, vilket gör dem svåra att skala. Dessutom, eftersom de fungerar olika, kommer det alltid att finnas debatt om vilka metoder som ska tillämpas och vilken kombination av tekniker som behövs.

- Det finns alltid en en-till-en-relation med originaldata. Detta innebär att det alltid kommer att finnas en integritetsrisk, särskilt på grund av alla öppna datauppsättningar och tillgängliga tekniker för att länka dessa datauppsättningar.

- De manipulerar data och förstör därmed data i processen. Detta är särskilt förödande för AI-uppgifter där "förutsägande kraft" är avgörande, eftersom data av dålig kvalitet kommer att resultera i dåliga insikter från AI-modellen (Garbage-in kommer att resultera i garbage-out).

Dessa punkter bedöms också via denna fallstudie.

En introduktion till fallstudien

För fallstudien var måldatauppsättningen en telekomdatauppsättning tillhandahållen av SAS innehållande data från 56.600 128 kunder. Datauppsättningen innehåller XNUMX kolumner, inklusive en kolumn som anger om en kund har lämnat företaget (dvs. "churned") eller inte. Målet med fallstudien var att använda syntetiska data för att träna några modeller för att förutsäga kundförlust och för att utvärdera prestandan hos dessa tränade modeller. Eftersom churn-förutsägelse är en klassificeringsuppgift valde SAS ut fyra populära klassificeringsmodeller för att göra förutsägelserna, inklusive:

- Slumpmässig skog

- Gradientförstärkning

- Logistisk återgång

- Neuralt nätverk

Innan den syntetiska datan genererades delade SAS slumpmässigt upp telekomdatauppsättningen i en tåguppsättning (för träning av modellerna) och en holdoutuppsättning (för poängsättning av modellerna). Att ha en separat uppsättning för poängsättning möjliggör en opartisk bedömning av hur väl klassificeringsmodellen kan prestera när den tillämpas på nya data.

Genom att använda tågsetet som indata använde Syntho sin Syntho Engine för att generera en syntetisk datauppsättning. För benchmarking skapade SAS även en manipulerad version av tågsetet efter att ha tillämpat olika anonymiseringstekniker för att nå en viss tröskel (av k-anonymitet). De tidigare stegen resulterade i fyra datamängder:

- En tågdatauppsättning (dvs. den ursprungliga datauppsättningen minus holdoutdatauppsättningen)

- En holdout-datauppsättning (dvs en delmängd av den ursprungliga datauppsättningen)

- En anonymiserad datauppsättning (baserat på tågdatauppsättningen)

- En syntetisk datauppsättning (baserad på tågdatauppsättningen)

Dataset 1, 3 och 4 användes för att träna varje klassificeringsmodell, vilket resulterade i 12 (3 x 4) tränade modeller. SAS använde därefter holdout-datasetet för att mäta noggrannheten med vilken varje modell förutsäger kundavgång. Resultaten presenteras nedan och börjar med lite grundläggande statistik.

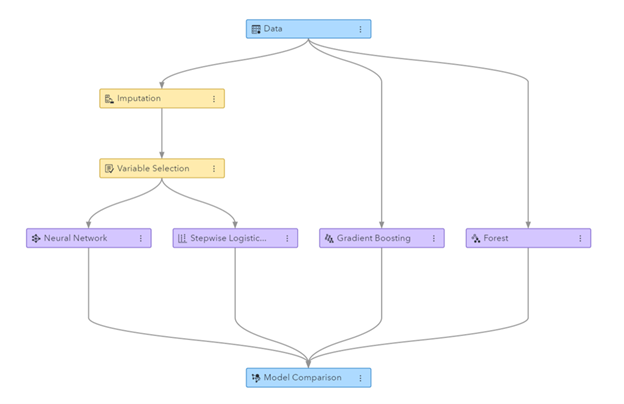

Figur: Machine Learning pipeline genererad i SAS Visual Data Mining och Machine Learning

Grundläggande statistik vid jämförelse av anonymiserad data med originaldata

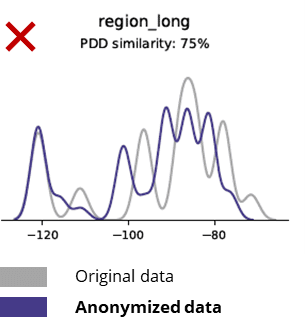

Anonymiseringstekniker förstör även grundläggande mönster, affärslogik, relationer och statistik (som i exemplet nedan). Att använda anonymiserad data för grundläggande analyser ger således opålitliga resultat. Faktum är att den dåliga kvaliteten på den anonymiserade datan gjorde det nästan omöjligt att använda det för avancerade analysuppgifter (t.ex. AI/ML-modellering och dashboarding).

Grundläggande statistik vid jämförelse av syntetisk data med originaldata

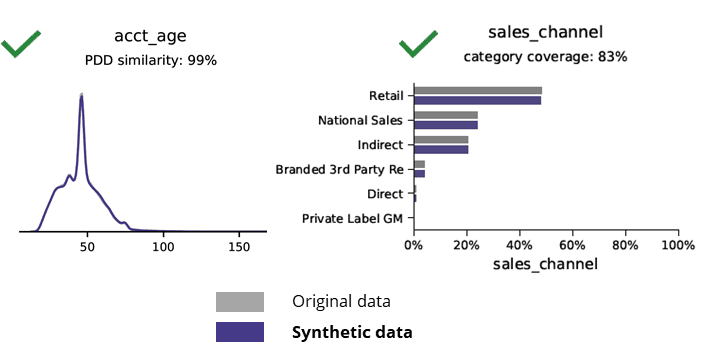

Syntetisk datagenerering med AI bevarar grundläggande mönster, affärslogik, relationer och statistik (som i exemplet nedan). Att använda syntetiska data för grundläggande analyser ger alltså tillförlitliga resultat. Nyckelfråga, håller syntetisk data för avancerade analysuppgifter (t.ex. AI/ML-modellering och dashboarding)?

AI-genererad syntetisk data och avancerad analys

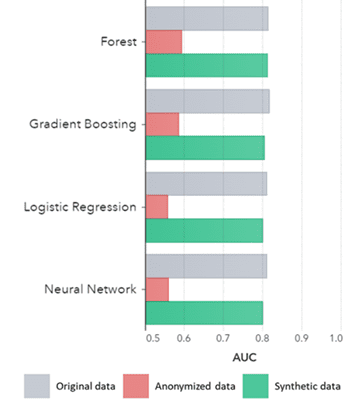

Syntetisk data gäller inte bara för grundläggande mönster (som visas i de tidigare diagrammen), den fångar också djupt "dolda" statistiska mönster som krävs för avancerade analysuppgifter. Det senare visas i stapeldiagrammet nedan, vilket indikerar att noggrannheten hos modeller tränade på syntetiska data jämfört med modeller tränade på originaldata är liknande. Dessutom, med en area under the curve (AUC*) nära 0.5 presterar de modeller som tränats på anonymiserad data överlägset sämst. Den fullständiga rapporten med alla avancerade analysbedömningar av syntetisk data i jämförelse med originaldata finns tillgänglig på begäran.

*AUC: arean under kurvan är ett mått på noggrannheten hos avancerade analysmodeller, med hänsyn till sanna positiva, falska positiva, falska negativa och sanna negativa. 0,5 betyder att en modell förutsäger slumpmässigt och inte har någon prediktiv kraft och 1 betyder att modellen alltid är korrekt och har full prediktiv kraft.

Dessutom kan dessa syntetiska data användas för att förstå dataegenskaper och huvudvariabler som behövs för faktisk träning av modellerna. Ingångarna som valdes av algoritmerna på syntetisk data jämfört med originaldata var mycket lika. Därför kan modelleringsprocessen göras på denna syntetiska version, vilket minskar risken för dataintrång. Men när man drar slutsatser om enskilda poster (t.ex. telco-kund) rekommenderas omskolning av originaldata för förklaring, ökad acceptans eller bara på grund av reglering.

AUC enligt algoritm grupperad efter metod

Slutsatser:

- Modeller som tränats på syntetisk data jämfört med modellerna som tränats på originaldata visar mycket liknande prestanda

- Modeller tränade på anonymiserad data med "klassiska anonymiseringstekniker" visar sämre prestanda jämfört med modeller tränade på originaldata eller syntetiska data

- Syntetisk datagenerering är enkel och snabb eftersom tekniken fungerar exakt lika per datamängd och per datatyp.

Värdeskapande användningsfall för syntetisk data

Användningsfall 1: Syntetisk data för modellutveckling och avancerad analys

Att ha en stark databas med enkel och snabb tillgång till användbar data av hög kvalitet är avgörande för att utveckla modeller (t.ex. instrumentpaneler [BI] och avancerad analys [AI & ML]). Men många organisationer lider av en suboptimal databas, vilket resulterar i tre viktiga utmaningar:

- Att få tillgång till data tar åldrar på grund av (sekretess) regler, interna processer eller datasilos

- Klassiska anonymiseringstekniker förstör data, vilket gör att data inte längre lämpar sig för analys och avancerad analys (skräp in = skräp ut)

- Befintliga lösningar är inte skalbara eftersom de fungerar olika per datamängd och per datatyp och inte kan hantera stora flerbordsdatabaser

Syntetisk datametod: utveckla modeller med lika bra som verklig syntetisk data för att:

- Minimera användningen av originaldata utan att hindra dina utvecklare

- Lås upp personuppgifter och få tillgång till mer data som tidigare var begränsad (t.ex. på grund av integritet)

- Enkel och snabb dataåtkomst till relevant data

- Skalbar lösning som fungerar likadant för varje dataset, datatyp och för massiva databaser

Detta gör att organisationen kan bygga en stark databas med enkel och snabb tillgång till användbar data av hög kvalitet för att låsa upp data och utnyttja datamöjligheter.

Användningsfall 2: smart syntetisk testdata för mjukvarutestning, utveckling och leverans

Testning och utveckling med högkvalitativa testdata är avgörande för att leverera toppmoderna mjukvarulösningar. Att använda originalproduktionsdata verkar självklart, men är inte tillåtet på grund av (integritets)bestämmelser. Alternativ Test Data Management (TDM)-verktyg introducerar "legacy-by-design” för att få testdata rätt:

- Reflektera inte produktionsdata och affärslogik och referensintegritet bevaras inte

- Arbeta långsamt och tidskrävande

- Manuellt arbete krävs

Syntetisk datametod: Testa och utveckla med AI-genererad syntetisk testdata för att leverera toppmoderna mjukvarulösningar smarta med:

- Produktionsliknande data med bevarad affärslogik och referensintegritet

- Enkel och snabb datagenerering med toppmodern AI

- Integritetsdesign

- Enkelt, snabbt och agile

Detta gör att organisationen kan testa och utveckla med nästa nivå testdata för att leverera toppmoderna mjukvarulösningar!

Mer information

Intresserad? För mer information om syntetisk data, besök Synthos hemsida eller kontakta Wim Kees Janssen. För mer information om SAS, besök www.sas.com eller kontakta kees@syntho.ai.

I detta användningsfall arbetar Syntho, SAS och NL AIC tillsammans för att uppnå de avsedda resultaten. Syntho är expert på AI-genererad syntetisk data och SAS är marknadsledande inom analys och erbjuder mjukvara för att utforska, analysera och visualisera data.

* Förutsäger 2021 – Data and Analytics Strategies to Govern, Scale and Transform Digital Business, Gartner, 2020.

Spara din syntetiska dataguide nu!

- Vad är syntetiska data?

- Varför använder organisationer det?

- Värdeskapande syntetdataklientfall

- Hur man börjar