Adivinha quem? 5 exemplos de por que remover nomes não é uma opção

Uma introdução a Guess Who

Adivinha quem? Embora eu tenha certeza de que muitos de vocês conhecem este jogo de antigamente, aqui vai uma breve recapitulação. O objetivo do jogo: descobrir o nome do personagem de desenho animado selecionado pelo seu oponente fazendo perguntas 'sim' e 'não', como 'a pessoa usa chapéu?' ou 'a pessoa usa óculos'? Os jogadores eliminam candidatos com base na resposta do oponente e aprendem atributos relacionados ao personagem misterioso de seu oponente. O primeiro jogador que descobrir o personagem misterioso do outro jogador vence o jogo.

Você entendeu. Deve-se identificar o indivíduo fora de um conjunto de dados tendo apenas acesso aos atributos correspondentes. Na verdade, vemos regularmente esse conceito de Guess Who aplicado na prática, mas depois empregado em conjuntos de dados formatados com linhas e colunas contendo atributos de pessoas reais. A principal diferença ao trabalhar com dados é que as pessoas tendem a subestimar a facilidade com que indivíduos reais podem ser desmascarados por terem acesso a apenas alguns atributos.

Como o jogo Guess Who ilustra, alguém pode identificar indivíduos tendo acesso a apenas alguns atributos. Ele serve como um exemplo simples de por que a remoção apenas de 'nomes' (ou outros identificadores diretos) de seu conjunto de dados falha como uma técnica de anonimato. Neste blog, fornecemos quatro casos práticos para informá-lo sobre os riscos de privacidade associados à remoção de colunas como meio de anonimato de dados.

2) Ataques de ligação: seu conjunto de dados vinculado a outras fontes de dados (públicas)

O risco de ataques de ligação é a razão mais importante pela qual apenas remover nomes não funciona (mais) como método de anonimato. Com um ataque de ligação, o invasor combina os dados originais com outras fontes de dados acessíveis para identificar exclusivamente um indivíduo e obter informações (muitas vezes confidenciais) sobre essa pessoa.

A chave aqui é a disponibilidade de outros recursos de dados que estão presentes agora ou podem se tornar presentes no futuro. Pense em você. Quanto de seus próprios dados pessoais pode ser encontrado no Facebook, Instagram ou LinkedIn que podem ser usados para um ataque de linkage?

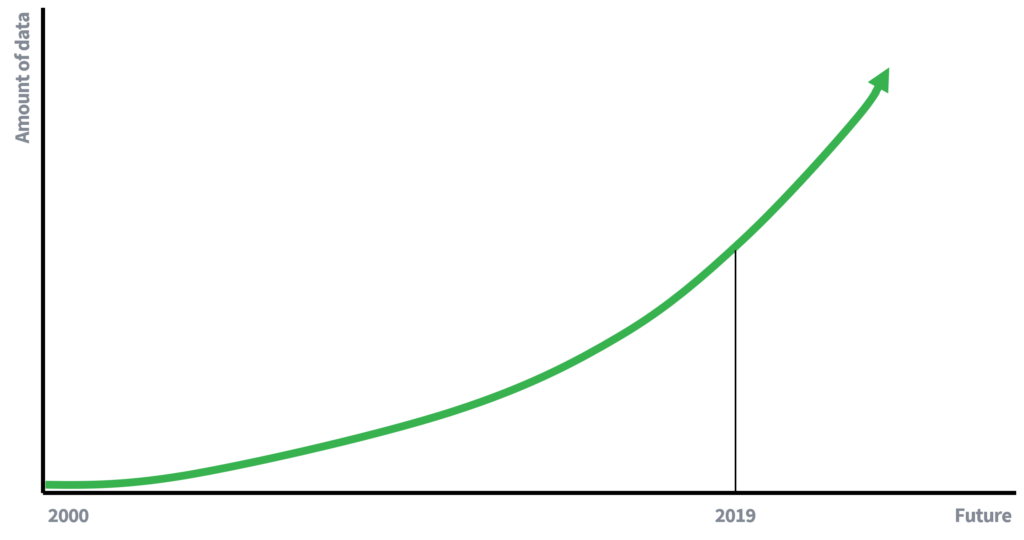

Antigamente, a disponibilidade de dados era muito mais limitada, o que explica em parte por que a remoção de nomes era suficiente para preservar a privacidade dos indivíduos. Menos dados disponíveis significa menos oportunidades para vincular dados. No entanto, agora somos participantes (ativos) em uma economia baseada em dados, onde a quantidade de dados está crescendo a uma taxa exponencial. Mais dados e o aprimoramento da tecnologia para coleta de dados levarão a um maior potencial para ataques de ligação. O que se escreveria em 10 anos sobre o risco de um ataque de ligação?

Ilustração 1

Dados em crescimento exponencial são um fato

Estudo de caso

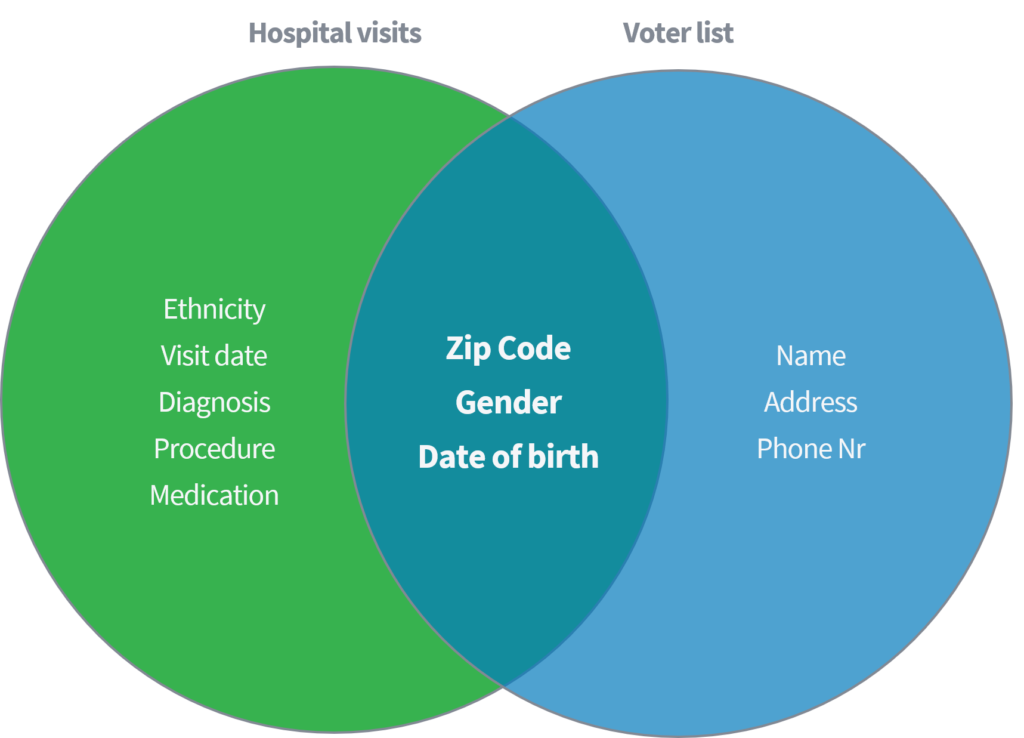

Sweeney (2002) demonstrou em um artigo acadêmico como ela foi capaz de identificar e recuperar dados médicos confidenciais de indivíduos com base na vinculação de um conjunto de dados disponíveis ao público de 'visitas a hospitais' ao registrador de votação disponível publicamente nos Estados Unidos. Ambos os conjuntos de dados foram considerados devidamente anônimos por meio da exclusão de nomes e outros identificadores diretos.

Ilustração 2

Ataque de ligação na prática

Com base apenas nos três parâmetros (1) Código Postal, (2) Sexo e (3) Data de Nascimento, ela mostrou que 87% de toda a população dos EUA poderia ser reidentificada combinando os atributos mencionados acima de ambos os conjuntos de dados. Sweeney então repetiu seu trabalho com 'país' como uma alternativa para 'CEP'. Além disso, ela demonstrou que 18% de toda a população dos Estados Unidos poderia ser identificada apenas por meio do acesso a um conjunto de dados contendo informações sobre (1) país de origem, (2) sexo e (3) data de nascimento. Pense nas fontes públicas mencionadas, como Facebook, LinkedIn ou Instagram. Seu país, sexo e data de nascimento estão visíveis ou outros usuários podem deduzi-los?

Ilustração 3

Resultados de Sweeney

| Quase identificadores | % identificado exclusivamente da população dos EUA (248 milhões) |

| ZIP de 5 dígitos, sexo, data de nascimento | 87% |

| lugar, sexo, data de nascimento | 53% |

| país, sexo, data de nascimento | 18% |

Este exemplo demonstra que pode ser extremamente fácil desanimar indivíduos em dados aparentemente anônimos. Em primeiro lugar, este estudo indica uma enorme magnitude de risco, como 87% da população dos EUA pode ser facilmente identificada usando poucas características. Em segundo lugar, os dados médicos expostos neste estudo eram altamente sensíveis. Exemplos de dados de indivíduos expostos do conjunto de dados de visitas a hospitais incluem etnia, diagnóstico e medicação. Atributos que preferimos manter em segredo, por exemplo, das seguradoras.

3) Indivíduos informados

Outro risco de remover apenas identificadores diretos, como nomes, surge quando indivíduos informados têm conhecimento ou informações superiores sobre características ou comportamento de indivíduos específicos no conjunto de dados. Com base em seu conhecimento, o invasor pode então vincular registros de dados específicos a pessoas reais.

Estudo de caso

Um exemplo de ataque a um conjunto de dados usando conhecimento superior é o caso do táxi de Nova York, onde Atockar (2014) conseguiu desmascarar indivíduos específicos. O conjunto de dados empregado continha todas as viagens de táxi em Nova York, enriquecido com atributos básicos como coordenadas iniciais, coordenadas finais, preço e ponta da viagem.

Um indivíduo informado que conhece Nova York foi capaz de derivar viagens de táxi para o clube adulto 'Hustler'. Ao filtrar a 'localização final', ele deduziu os endereços de partida exatos e, assim, identificou vários visitantes frequentes. Da mesma forma, pode-se deduzir viagens de táxi quando o endereço residencial do indivíduo era conhecido. A hora e a localização de várias estrelas de cinema de celebridades foram descobertas em sites de fofoca. Depois de vincular essas informações aos dados dos táxis de Nova York, foi fácil deduzir as viagens de táxi, o valor que pagaram e se deram gorjeta.

Ilustração 4

Um indivíduo informado

coordenadas de desembarque Hustler

Bradley Cooper

Jessica Alba

4) Dados como impressão digital

Uma linha comum de argumentação é 'esses dados não valem nada' ou 'ninguém pode fazer nada com esses dados'. Isso geralmente é um equívoco. Mesmo os dados mais inocentes podem formar uma 'impressão digital' única e ser usados para reidentificar indivíduos. É o risco derivado da crença de que os dados em si são inúteis, enquanto na verdade não são.

O risco de identificação aumentará com o aumento de dados, IA e outras ferramentas e algoritmos que permitem a descoberta de relacionamentos complexos nos dados. Conseqüentemente, mesmo que seu conjunto de dados não possa ser descoberto agora e seja provavelmente inútil para pessoas não autorizadas hoje, pode não ser amanhã.

Estudo de caso

Um ótimo exemplo é o caso em que a Netflix pretendia crowdsource seu departamento de P&D introduzindo uma competição aberta da Netflix para melhorar seu sistema de recomendação de filmes. 'Aquele que melhora o algoritmo de filtragem colaborativa para prever as avaliações dos usuários para filmes ganha um prêmio de US $ 1,000,000'. Para apoiar a multidão, a Netflix publicou um conjunto de dados contendo apenas os seguintes atributos básicos: ID do usuário, filme, data da nota e nota (portanto, nenhuma informação adicional sobre o usuário ou o próprio filme).

Ilustração 5

Preço da Netflix da estrutura do conjunto de dados

| ID do usuário | Filme | Data da nota | Grau |

| 123456789 | Missão impossível | 10-12-2008 | 4 |

Isolados, os dados pareciam fúteis. Ao fazer a pergunta "Há alguma informação do cliente no conjunto de dados que deve ser mantida privada?", A resposta foi:

'Não, todas as informações de identificação do cliente foram removidas; tudo o que resta são classificações e datas. Isso segue nossa política de privacidade ... '

No entanto, Narayanan (2008) da Universidade do Texas em Austin provou o contrário. A combinação de notas, data da série e filme de um indivíduo forma uma impressão digital de filme única. Pense em seu próprio comportamento no Netflix. Quantas pessoas você acha que assistiram ao mesmo conjunto de filmes? Quantos assistiram ao mesmo conjunto de filmes ao mesmo tempo?

Questão principal, como combinar essa impressão digital? Era bastante simples. Com base nas informações do conhecido site de classificação de filmes IMDb (Internet Movie Database), uma impressão digital semelhante pode ser formada. Consequentemente, os indivíduos podem ser reidentificados.

Embora o comportamento de assistir filmes não seja considerado uma informação sensível, pense em seu próprio comportamento - você se importaria se isso fosse público? Os exemplos que Narayanan forneceu em seu artigo são preferências políticas (avaliações sobre 'Jesus de Nazaré' e 'O Evangelho de João') e preferências sexuais (avaliações sobre 'Curvado' e 'Queer as folk') que poderiam ser facilmente destiladas.

5) Regulamento Geral de Proteção de Dados (GDPR)

O GDPR pode não ser muito empolgante, nem a bala de prata entre os tópicos de blogs. No entanto, é útil obter as definições corretas ao processar dados pessoais. Como este blog é sobre o equívoco comum de remover colunas como uma forma de tornar os dados anônimos e para educá-lo como processador de dados, vamos começar explorando a definição de anonimato de acordo com o GDPR.

De acordo com o considerando 26 do GDPR, informações anônimas são definidas como:

'informações que não dizem respeito a uma pessoa singular identificada ou identificável ou dados pessoais tornados anônimos de tal forma que o titular dos dados não é ou deixa de ser identificável.'

Uma vez que se processa dados pessoais relacionados a uma pessoa física, apenas a parte 2 da definição é relevante. Para cumprir a definição, é necessário garantir que o titular dos dados (indivíduo) não seja ou não seja mais identificável. Conforme indicado neste blog, no entanto, é extremamente simples identificar indivíduos com base em alguns atributos. Portanto, remover nomes de um conjunto de dados não está de acordo com a definição de anonimato do GDPR.

Em conclusão

Desafiamos uma abordagem comumente considerada e, infelizmente, ainda aplicada de anonimato de dados: remover nomes. No jogo Guess Who e quatro outros exemplos sobre:

- Ataques de ligação

- Indivíduos informados

- Dados como impressão digital

- Regulamento geral de proteção de dados (GDPR)

foi mostrado que a remoção de nomes falha como anonimato. Embora os exemplos sejam casos marcantes, cada um mostra a simplicidade da re-identificação e o potencial impacto negativo na privacidade dos indivíduos.

Em conclusão, a remoção de nomes de seu conjunto de dados não resulta em dados anônimos. Portanto, é melhor evitar o uso de ambos os termos alternadamente. Sinceramente, espero que você não aplique essa abordagem para o anonimato. E, se ainda o fizer, certifique-se de que você e sua equipe entendem totalmente os riscos de privacidade e têm permissão para aceitar esses riscos em nome dos indivíduos afetados.

Os dados são sintéticos, mas nossa equipe é real!

Contactar a Syntho e um de nossos especialistas entrará em contato com você na velocidade da luz para explorar o valor dos dados sintéticos!

- D. Reinsel, J. Gantz, John Rydning. A digitalização do mundo da borda ao núcleo, Data Age 2025, 2018

- L. Sweeney. k-anonimato: um modelo para proteger a privacidade. International Journal on Uncertainty, Fuzziness and Knowledge-Based Systems, 10 (5), 2002: 557-570

- L. Sweeney. Os dados demográficos simples costumam identificar as pessoas de maneira única. Carnegie Mellon University, Data Privacy Working Paper 3. Pittsburgh 2000

- P. Samarati. Protegendo as identidades dos entrevistados na liberação de microdados. IEEE Transactions on Knowledge and Data Engineering, 13 (6), 2001: 1010-1027

- Atocar. Riding with the Stars: Passenger Privacy in the NYC Taxicab Dataset, 2014

- Narayanan, A., & Shmatikov, V. (2008). Desanonimização robusta de grandes conjuntos de dados esparsos. In Proceedings - 2008 IEEE Symposium on Security and Privacy, SP (pp. 111-125)

- Regulamento geral de proteção de dados (GDPR), considerando 26, não aplicável a dados anônimos