AI-genererte syntetiske data, enkel og rask tilgang til data av høy kvalitet?

AI genererte syntetiske data i praksis

Syntho, en ekspert på AI-genererte syntetiske data, har som mål å snu privacy by design til et konkurransefortrinn med AI-genererte syntetiske data. De hjelper organisasjoner med å bygge et sterkt datagrunnlag med enkel og rask tilgang til data av høy kvalitet og vant nylig Philips Innovation Award.

Syntetisk datagenerering med AI er imidlertid en relativt ny løsning som vanligvis introduserer vanlige spørsmål. For å svare på disse startet Syntho en case-studie sammen med SAS, markedsleder innen Advanced Analytics og AI-programvare.

I samarbeid med Dutch AI Coalition (NL AIC) undersøkte de verdien av syntetiske data ved å sammenligne AI-genererte syntetiske data generert av Syntho Engine med originaldata via ulike vurderinger av datakvalitet, juridisk gyldighet og brukervennlighet.

Er ikke dataanonymisering en løsning?

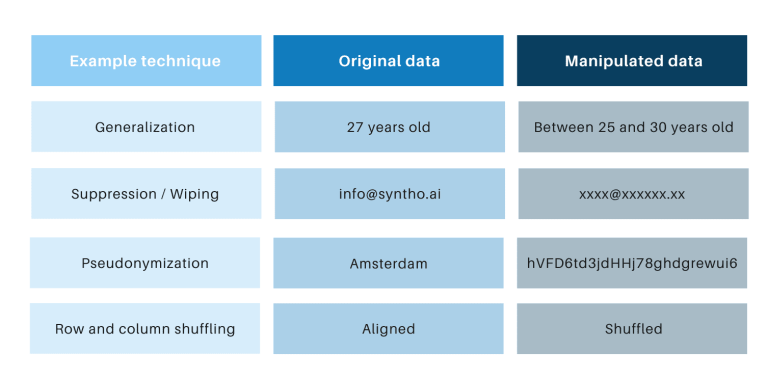

Klassiske anonymiseringsteknikker har det til felles at de manipulerer originaldata for å hindre tilbakesporing av individer. Eksempler er generalisering, undertrykkelse, sletting, pseudonymisering, datamaskering og stokking av rader og kolonner. Du finner eksempler i tabellen nedenfor.

Disse teknikkene introduserer tre hovedutfordringer:

- De fungerer forskjellig per datatype og per datasett, noe som gjør dem vanskelige å skalere. Siden de fungerer forskjellig, vil det dessuten alltid være debatt om hvilke metoder som skal brukes og hvilken kombinasjon av teknikker som trengs.

- Det er alltid et en-til-en forhold til de opprinnelige dataene. Dette betyr at det alltid vil være en personvernrisiko, spesielt på grunn av alle åpne datasett og tilgjengelige teknikker for å koble disse datasettene.

- De manipulerer data og ødelegger dermed data i prosessen. Dette er spesielt ødeleggende for AI-oppgaver der "prediktiv kraft" er avgjørende, fordi data av dårlig kvalitet vil resultere i dårlig innsikt fra AI-modellen (Garbage-in vil resultere i søppel-out).

Disse punktene vurderes også via denne casestudien.

En introduksjon til casestudiet

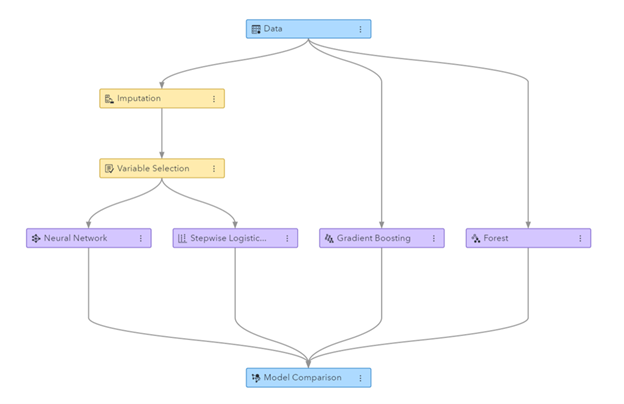

For casestudien var måldatasettet et telekomdatasett levert av SAS som inneholder dataene til 56.600 128 kunder. Datasettet inneholder XNUMX kolonner, inkludert en kolonne som angir om en kunde har forlatt selskapet (dvs. "churned") eller ikke. Målet med casestudien var å bruke de syntetiske dataene til å trene noen modeller for å forutsi kundefragang og for å evaluere ytelsen til de trente modellene. Siden churn-prediksjon er en klassifiseringsoppgave, valgte SAS fire populære klassifiseringsmodeller for å lage spådommene, inkludert:

- Tilfeldig skog

- Gradientforsterkning

- Logistisk regresjon

- Nevrale nettverket

Før de genererer de syntetiske dataene, delte SAS tilfeldig opp telekom-datasettet i et togsett (for å trene modellene) og et holdout-sett (for å score modellene). Å ha et separat holdout-sett for scoring gir mulighet for en objektiv vurdering av hvor godt klassifiseringsmodellen kan fungere når den brukes på nye data.

Ved å bruke togsettet som input, brukte Syntho sin Syntho Engine for å generere et syntetisk datasett. For benchmarking laget SAS også en manipulert versjon av togsettet etter å ha brukt ulike anonymiseringsteknikker for å nå en viss terskel (av k-anonimitet). De tidligere trinnene resulterte i fire datasett:

- Et togdatasett (dvs. det originale datasettet minus holdout-datasettet)

- Et holdout-datasett (dvs. et undersett av det opprinnelige datasettet)

- Et anonymisert datasett (basert på togdatasettet)

- Et syntetisk datasett (basert på togdatasettet)

Datasett 1, 3 og 4 ble brukt til å trene hver klassifiseringsmodell, noe som resulterte i 12 (3 x 4) trente modeller. SAS brukte deretter holdout-datasettet til å måle nøyaktigheten som hver modell forutsier kundefragang. Resultatene presenteres nedenfor, og starter med noen grunnleggende statistikker.

Figur: Machine Learning pipeline generert i SAS Visual Data Mining og Machine Learning

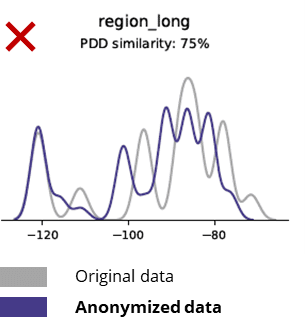

Grunnleggende statistikk ved sammenligning av anonymiserte data med originaldata

Anonymiseringsteknikker ødelegger selv grunnleggende mønstre, forretningslogikk, relasjoner og statistikk (som i eksemplet nedenfor). Å bruke anonymiserte data for grunnleggende analyser gir dermed upålitelige resultater. Faktisk gjorde den dårlige kvaliteten på de anonymiserte dataene det nesten umulig å bruke dem til avanserte analyseoppgaver (f.eks. AI/ML-modellering og dashboarding).

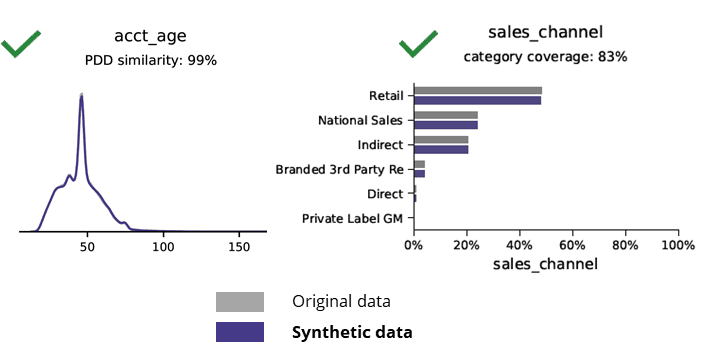

Grunnleggende statistikk ved sammenligning av syntetiske data med originaldata

Syntetisk datagenerering med AI bevarer grunnleggende mønstre, forretningslogikk, relasjoner og statistikk (som i eksemplet nedenfor). Å bruke syntetiske data for grunnleggende analyser gir dermed pålitelige resultater. Nøkkelspørsmål, holder syntetiske data for avanserte analyseoppgaver (f.eks. AI/ML-modellering og dashboarding)?

AI-genererte syntetiske data og avanserte analyser

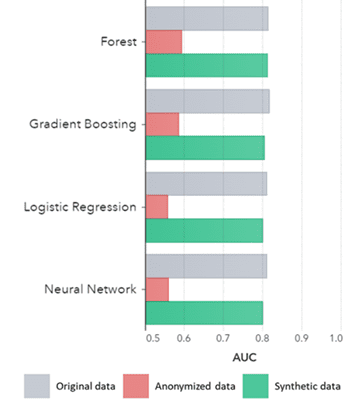

Syntetiske data gjelder ikke bare for grunnleggende mønstre (som vist i de tidligere plottene), de fanger også dype "skjulte" statistiske mønstre som kreves for avanserte analyseoppgaver. Sistnevnte er demonstrert i søylediagrammet nedenfor, noe som indikerer at nøyaktigheten til modeller trent på syntetiske data versus modeller trent på originaldata er like. Videre, med et område under kurven (AUC*) nær 0.5, presterer modellene trent på anonymiserte data desidert dårligst. Den fullstendige rapporten med alle avanserte analysevurderinger av syntetiske data sammenlignet med de originale dataene er tilgjengelig på forespørsel.

*AUC: området under kurven er et mål for nøyaktigheten til avanserte analysemodeller, og tar hensyn til sanne positive, falske positive, falske negative og sanne negative. 0,5 betyr at en modell predikerer tilfeldig og ikke har noen prediktiv kraft og 1 betyr at modellen alltid er korrekt og har full prediktiv kraft.

I tillegg kan disse syntetiske dataene brukes til å forstå datakarakteristikker og hovedvariabler som trengs for faktisk trening av modellene. Inndataene valgt av algoritmene på syntetiske data sammenlignet med originaldata var svært like. Derfor kan modelleringsprosessen gjøres på denne syntetiske versjonen, noe som reduserer risikoen for datainnbrudd. Men når man trekker slutninger om individuelle poster (f.eks. telefonkunder) anbefales det å omskolere originaldata for forklaring, økt aksept eller bare på grunn av regulering.

AUC etter algoritme gruppert etter metode

Konklusjoner:

- Modeller trent på syntetiske data sammenlignet med modellene trent på originaldata viser svært lik ytelse

- Modeller trent på anonymiserte data med "klassiske anonymiseringsteknikker" viser dårligere ytelse sammenlignet med modeller trent på originaldata eller syntetiske data

- Syntetisk datagenerering er enkel og rask fordi teknikken fungerer nøyaktig likt per datasett og per datatype.

Verdiskapende brukstilfeller for syntetiske data

Use case 1: Syntetiske data for modellutvikling og avanserte analyser

Å ha et sterkt datagrunnlag med enkel og rask tilgang til brukbare data av høy kvalitet er avgjørende for å utvikle modeller (f.eks. dashboards [BI] og avanserte analyser [AI & ML]). Imidlertid lider mange organisasjoner av et suboptimalt datagrunnlag som resulterer i tre hovedutfordringer:

- Å få tilgang til data tar aldre på grunn av (personvern) forskrifter, interne prosesser eller datasiloer

- Klassiske anonymiseringsteknikker ødelegger data, noe som gjør dataene ikke lenger egnet for analyse og avansert analyse (søppel inn = søppel ut)

- Eksisterende løsninger er ikke skalerbare fordi de fungerer forskjellig per datasett og per datatype og ikke kan håndtere store multi-tabell databaser

Syntetisk datatilnærming: utvikle modeller med like gode som ekte syntetiske data for å:

- Minimer bruken av originaldata, uten å hindre utviklerne

- Lås opp personlige data og få tilgang til flere data som tidligere var begrenset (f.eks. På grunn av personvern)

- Enkel og rask datatilgang til relevante data

- Skalerbar løsning som fungerer likt for hvert datasett, datatype og for massive databaser

Dette lar organisasjonen bygge et sterkt datagrunnlag med enkel og rask tilgang til brukbare data av høy kvalitet for å låse opp data og utnytte datamuligheter.

Use case 2: smarte syntetiske testdata for programvaretesting, utvikling og levering

Testing og utvikling med testdata av høy kvalitet er avgjørende for å levere toppmoderne programvareløsninger. Å bruke originale produksjonsdata virker åpenbart, men er ikke tillatt på grunn av (personvern)forskrifter. Alternativ Test Data Management (TDM)-verktøy introduserer "legacy-by-design" for å få testdataene riktig:

- Ikke reflekter produksjonsdata og forretningslogikk og referanseintegritet er ikke bevart

- Arbeid sakte og tidkrevende

- Manuelt arbeid er nødvendig

Syntetisk datatilnærming: Test og utvik med AI-genererte syntetiske testdata for å levere toppmoderne programvareløsninger smart med:

- Produksjonslignende data med bevart forretningslogikk og referanseintegritet

- Enkel og rask datagenerering med topp moderne AI

- Personvern-by-design

- Enkelt, raskt og agile

Dette gjør at organisasjonen kan teste og utvikle seg med testdata på neste nivå for å levere toppmoderne programvareløsninger!

Mer informasjon

Interessert? For mer informasjon om syntetiske data, besøk Syntho-nettsiden eller kontakt Wim Kees Janssen. For mer informasjon om SAS, besøk www.sas.com eller kontakt kees@syntho.ai.

I dette tilfellet jobber Syntho, SAS og NL AIC sammen for å oppnå de tiltenkte resultatene. Syntho er ekspert på AI-generert syntetisk data og SAS er markedsleder innen analyse og tilbyr programvare for å utforske, analysere og visualisere data.

* Forutsier 2021 – Data and Analytics Strategies to Govern, Scale and Transform Digital Business, Gartner, 2020.

Lagre din syntetiske dataguide nå!

- Hva er syntetiske data?

- Hvorfor bruker organisasjoner det?

- Verdiskapende syntetiske dataklientsaker

- Hvordan starte