Avaliación da utilidade e a semellanza nos xeradores de datos sintéticos: unha investigación profunda técnica e análise comparativa

introdución

Na era dixital actual, a conciencia sobre a privacidade dos datos aumentou significativamente. Os usuarios recoñecen cada vez máis os seus datos como unha pegada dixital única, que supón un risco para a súa privacidade en caso de violación de datos. Esta preocupación vese aínda máis amplificada por normativas como o GDPR, que facultan aos usuarios para solicitar a eliminación dos seus datos. Aínda que é moi necesaria, esta lexislación pode resultar moi custosa para as empresas xa que se minimiza o acceso aos datos; restricións que moitas veces son lentos e lentos de recursos para superar.

Índice analítico

Que son os xeradores de datos sintéticos?

Introduza datos sintéticos, unha solución a este enigma. Os xeradores de datos sintéticos crean conxuntos de datos que imitan os datos reais dos usuarios preservando o anonimato e a confidencialidade. Este enfoque está gañando forza en todas as industrias, desde a sanidade ata as finanzas, onde a privacidade é primordial.

Como elixir o método correcto de xeración de datos sintéticos?

No panorama diverso da xeración de datos sintéticos, hai unha abundancia de métodos dispoñibles, cada un deles que loita pola atención coas súas capacidades únicas. Elixir o método máis axeitado para unha aplicación particular require unha comprensión completa das características de rendemento de cada opción. Isto require unha avaliación completa de varios xeradores de datos sintéticos baseados nun conxunto de métricas ben definidas para tomar unha decisión informada.

O que segue é unha análise comparativa rigorosa do motor Syntho xunto a un marco de código aberto coñecido, o Synthetic Data Vault (SDV). Nesta análise, utilizamos moitas métricas de uso común, como a fidelidade estatística, a precisión preditiva e a relación entre variables.

Métricas de avaliación de datos sintéticos

Antes de introducir calquera métrica específica, debemos recoñecer que existen numerosas ideoloxías sobre a avaliación dos datos sintéticos, cada unha das cales dá unha visión dun determinado aspecto dos datos. Tendo isto en conta, as seguintes tres categorías destacan como importantes e completas. Estas métricas proporcionan información sobre varios aspectos da calidade dos datos. Estas categorías son:

- Métricas de fidelidade estatística: Examinar as características estatísticas básicas dos datos, como medias e varianzas, para garantir que os datos sintéticos se aliñan co perfil estatístico do conxunto de datos orixinal.

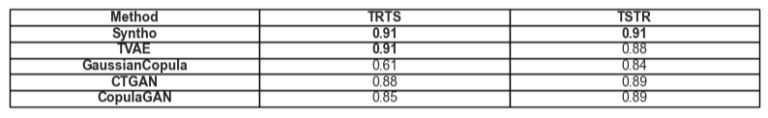

- Precisión preditiva: Examinando o rendemento do modelo de xeración de datos sintéticos, adestrado con datos orixinais e avaliado en datos sintéticos (Train Real – Test Synthetic, TRTS) e viceversa (Train Synthetic – Test Real, TSTR)

- Relacións entre variables: Esta categoría combinada inclúe:

- Correlación de características: Valoramos o ben que os datos sintéticos manteñen as relacións entre as variables utilizando coeficientes de correlación. Unha métrica coñecida como a Propensity Mean Squared Error (PMSE) sería deste tipo.

- Información mutua: Medimos as dependencias mutuas entre variables para comprender a profundidade destas relacións máis aló das só correlacións.

Análise comparativa: Syntho Engine vs Alternativas de código aberto

A análise comparativa realizouse mediante un marco de avaliación estandarizado e técnicas de proba idénticas en todos os modelos, incluídos os modelos Syntho Engine e SDV. Ao sintetizar conxuntos de datos de fontes idénticas e sometelos ás mesmas probas estatísticas e avaliacións de modelos de aprendizaxe automática, garantimos unha comparación xusta e imparcial. A sección que segue detalla o rendemento de cada xerador de datos sintéticos na gama de métricas presentadas anteriormente.

En canto ao conxunto de datos utilizado para a avaliación, utilizamos o Conjunto de datos do censo de adultos da UCI que é un conxunto de datos coñecido na comunidade de aprendizaxe automática. Limpamos os datos antes de todos os adestramentos e despois dividimos o conxunto de datos en dous conxuntos (un conxunto de adestramento e un conxunto de retención para probas). Usamos o conxunto de adestramento para xerar 1 millón de novos puntos de datos con cada un dos modelos e avaliamos varias métricas sobre estes conxuntos de datos xerados. Para máis avaliacións de aprendizaxe automática, usamos o conxunto de retencións para avaliar métricas como as relacionadas con TSTR e TRTS.

Cada xerador foi executado con parámetros predeterminados. Como algúns dos modelos, como Syntho, poden funcionar de forma predeterminada en calquera dato tabular, non se fixo ningún axuste fino. A procura dos hiperparámetros axeitados para cada modelo levaría unha cantidade significativa de tempo, e a Táboa 2 xa mostra unha gran diferenza de tempo entre o modelo de Syntho e os que se probaron.

Cabe destacar que a diferenza do resto dos modelos en SDV, o sintetizador de cópula gaussiana baséase en métodos estatísticos. Pola contra, o resto baséase en redes neuronais como os modelos de Redes Adversariais Xerais (GAN) e os codificadores automáticos variacionais. É por iso que a cópula gaussiana pode verse como unha liña de base para todos os modelos discutidos.

Resultados

Calidade dos datos

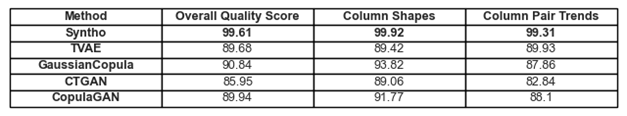

Figura 1. Visualización dos resultados básicos de calidade para todos os modelos

As adhesións ás tendencias e representacións dos datos comentadas anteriormente pódense atopar na Figura 1 e na Táboa 1. Aquí, cada unha das métricas en uso pódese interpretar do seguinte xeito:

- Puntuación de calidade global: avaliación global da calidade dos datos sintéticos, combinando varios aspectos como a semellanza estatística e as características dos datos.

- Formas de columna: avalía se os datos sintéticos manteñen a mesma forma de distribución que os datos reais para cada columna.

- Tendencias de pares de columnas: avalía a relación ou correlacións entre pares de columnas en datos sintéticos en comparación cos datos reais.

En xeral, pódese notar que Syntho logra puntuacións moi altas en todos os ámbitos. Para comezar, ao analizar a calidade global dos datos (avaliada coa biblioteca de métricas SDV), Syntho pode acadar un resultado superior ao 99 % (cunha adherencia á forma de columna do 99.92 % e unha adhesión á forma do par de columnas do 99.31 %). Isto é mentres o SDV obtén un resultado máximo do 90.84% (con cópula gaussiana, cunha adherencia á forma de columna do 93.82% e unha adherencia á forma do par de columnas do 87.86%).

Táboa 1. Unha representación tabular das puntuacións de calidade de cada conxunto de datos xerado por modelo

Cobertura de datos

O módulo Informe de diagnóstico de SDV chama a nosa atención sobre que os datos xerados por SDV (en todos os casos) faltan máis do 10% dos intervalos numéricos; No caso do autocodificador variacional baseado en tripletas (TVAE), tamén falta a mesma cantidade de datos categóricos en comparación co conxunto de datos orixinal. Non se xeraron tales avisos cos resultados acadados co uso de Syntho.

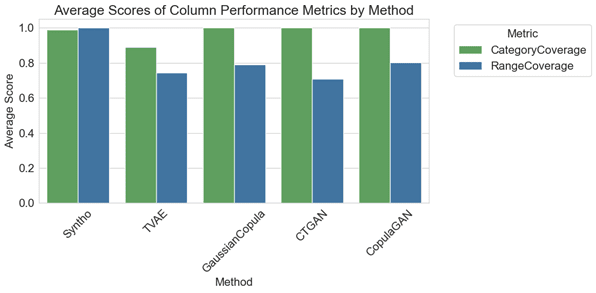

Figura 2. visualización das métricas de rendemento medio por columnas para todos os modelos

Na análise comparativa, o gráfico da Figura 2 ilustra que os arquivos SDV obtén resultados marxinalmente mellores na cobertura de categorías con algúns dos seus modelos (nomeadamente con GaussianCopula, CopulaGAN e GAN tabular condicional - CTGAN). Non obstante, é importante destacar que a fiabilidade dos datos de Syntho supera a dos modelos SDV, xa que a discrepancia na cobertura entre categorías e rangos é mínima, mostrando unha variación de apenas 1.1%. Pola contra, os modelos SDV presentan unha variación considerable, que vai do 14.6% ao 29.2%.

As métricas representadas aquí pódense interpretar do seguinte xeito:

- Cobertura de categorías: mide a presenza de todas as categorías en datos sintéticos en comparación cos datos reais.

- Cobertura do intervalo: avalía o ben que o intervalo de valores dos datos sintéticos coincide co dos datos reais.

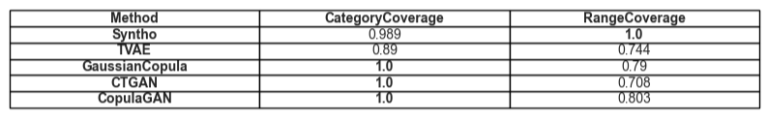

Táboa 2. Unha representación tabular da cobertura media dun determinado tipo de atributo por modelo

Utilidade

Pasando ao tema da utilidade dos datos sintéticos, cobra relevancia a cuestión dos modelos de adestramento sobre os datos. Para ter unha comparación equilibrada e xusta entre todos os frameworks escollimos o Gradient Boosting Classifier predeterminado da biblioteca SciKit Learn, xa que está bastante aceptado como un modelo de bo rendemento con configuracións listas para usar.

Adestraranse dous modelos diferentes, un sobre os datos sintéticos (para TSTR) e outro sobre os datos orixinais (para TRTS). O modelo adestrado cos datos sintéticos avalíase mediante un conxunto de probas de retención (que non se utilizou durante a xeración de datos sintéticos) e o modelo adestrado con datos orixinais probáse no conxunto de datos sintéticos.

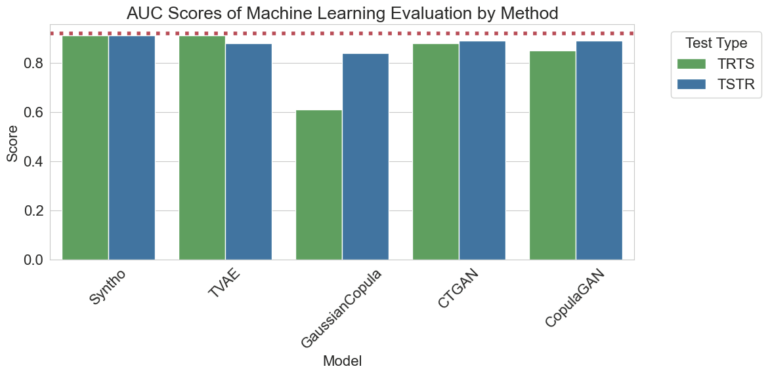

Figura 3. Visualización das puntuacións da área baixo a curva (AUC) por método e modelo

Os resultados visualizados anteriormente demostran a superioridade da xeración de datos sintéticos polo motor Syntho en comparación con outros métodos, xa que non hai diferenzas entre os resultados obtidos polos diferentes métodos (apuntando a unha gran semellanza entre os datos sintéticos e reais). Ademais, a liña de puntos vermellas presente no gráfico é o resultado obtido ao avaliar o rendemento base dunha proba Train Real, Test Real (TRTR) para proporcionar unha liña base para as métricas observadas. Esta liña representa o valor 0.92, que é a puntuación da área baixo a curva (puntuación AUC) acadada polo modelo adestrado en datos reais e probado en datos reais.

Táboa 3. Unha representación tabular das puntuacións AUC acadadas por TRTS e TSTR respectivamente por modelo.

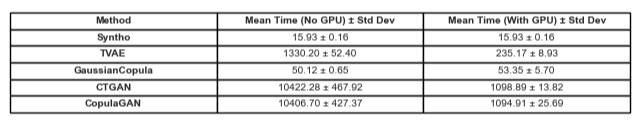

Comparación no tempo

Por suposto, é fundamental ter en conta o tempo investido na xeración destes resultados. A seguinte visualización ilustra só isto.

Figura 5. Visualización do tempo necesario para adestrar e realizar xeración de datos sintéticos dun millón de puntos de datos cun modelo con e sen GPU.

A figura 5 ilustra o tempo necesario para xerar datos sintéticos en dúas configuracións diferentes. O primeiro dos cales (aquí denominado sen GPU), foron probas executadas nun sistema cunha CPU Intel Xeon con 16 núcleos a 2.20 GHz. As probas marcadas como "correu cunha GPU" foron nun sistema cunha CPU AMD Ryzen 9 7945HX con 16 núcleos a 2.5 GHz e unha GPU para portátil NVIDIA GeForce RTX 4070. Como se observa na Figura 2 e na Táboa 2 a continuación, pódese observar que Syntho é significativamente máis rápido á hora de xerar datos sintéticos (en ambos os escenarios), o que é fundamental nun fluxo de traballo dinámico.

Táboa 5. Unha representación tabular do tempo necesario xeración de datos sintéticos dun millón de puntos de datos con cada modelo con e sen GPU

Os resultados subliñan a importancia dunha avaliación exhaustiva da calidade na elección do método correcto de xeración de datos sintéticos. O motor de Syntho, co seu enfoque impulsado pola intelixencia artificial, demostra fortalezas notables en certas métricas, mentres que as ferramentas de código aberto como SDV brillan pola súa versatilidade e melloras impulsadas pola comunidade.

A medida que o campo dos datos sintéticos segue evolucionando, animámosche a aplicar estas métricas nos teus proxectos, explorar as súas complexidades e compartir as túas experiencias. Estade atentos ás futuras publicacións nas que afondaremos noutras métricas e destacaremos exemplos reais da súa aplicación.

Ao final, para aqueles que buscan probar as augas con datos sintéticos, a alternativa de código aberto presentada pode ser unha opción xustificada dada a accesibilidade; non obstante, para os profesionais que incorporan esta tecnoloxía moderna ao seu proceso de desenvolvemento, hai que aproveitar calquera oportunidade de mellora e evitar todos os obstáculos. Polo tanto, é importante escoller a mellor opción dispoñible. Coas análises proporcionadas anteriormente, faise bastante evidente que Syntho e con iso o Syntho Engine é unha ferramenta moi capaz para os profesionais.

Acerca de Syntho

Sinto ofrece unha plataforma intelixente de xeración de datos sintéticos, que aproveita múltiples formas de datos sintéticos e métodos de xeración, e permite ás organizacións transformar de forma intelixente os datos nunha vantaxe competitiva. Os nosos datos sintéticos xerados pola intelixencia artificial imitan os patróns estatísticos dos datos orixinais, o que garante a precisión, a privacidade e a velocidade, segundo a avaliación de expertos externos como SAS. Con funcións intelixentes de desidentificación e cartografía consistente, a información sensible está protexida ao tempo que se preserva a integridade referencial. A nosa plataforma permite a creación, xestión e control de datos de proba para ambientes que non sexan de produción, utilizando métodos de xeración de datos sintéticos baseados en regras para escenarios específicos. Ademais, os usuarios poden xerar datos sintéticos mediante programación e obter datos de proba realistas para desenvolver escenarios completos de probas e desenvolvemento con facilidade.

Queres aprender máis aplicacións prácticas dos datos sintéticos? Non dubides en programa demo!

Sobre os autores

Practicante de Enxeñaría de Software

Roam é estudante de licenciatura na Universidade Tecnolóxica de Delft e está en prácticas en Enxeñaría de Software Sinto.

Enxeñeiro de aprendizaxe automática

Mihai logrou o seu doutoramento na Universidade de Bristol sobre o tema da aprendizaxe por reforzo xerárquico aplicado á robótica e é un Enxeñeiro de Machine Learning at Sinto.

Garda a túa guía de datos sintéticos agora!

- Que son os datos sintéticos?

- Por que o utilizan as organizacións?

- Casos de clientes de datos sintéticos de valor engadido

- Como comezar