Hyödyllisyyden ja samankaltaisuuden arviointi synteettisissä datageneraattoreissa: tekninen syväsukellus ja vertaileva analyysi

esittely

Nykypäivän digitaalisella aikakaudella tietoisuus tietosuojasta on lisääntynyt merkittävästi. Käyttäjät tunnustavat tietonsa yhä useammin ainutlaatuiseksi digitaaliseksi sormenjäljeksi, mikä vaarantaa heidän yksityisyytensä tietoturvaloukkausten sattuessa. Tätä huolta lisäävät edelleen säädökset, kuten GDPR, jotka antavat käyttäjille mahdollisuuden pyytää tietojensa poistamista. Vaikka lainsäädäntöä tarvitaankin, se voi olla yrityksille erittäin kallista, koska tietojen saatavuus on minimoitu. rajoituksia, joiden poistaminen vie usein aikaa ja resursseja.

Sisällysluettelo

Mitä synteettiset datageneraattorit ovat?

Syötä synteettiset tiedot, ratkaisu tähän ongelmaan. Synteettiset datageneraattorit luovat tietojoukkoja, jotka jäljittelevät todellista käyttäjädataa säilyttäen samalla nimettömyyden ja luottamuksellisuuden. Tämä lähestymistapa on saamassa vetovoimaa kaikilla aloilla terveydenhoidosta rahoitukseen, missä yksityisyys on ensiarvoisen tärkeää.

Kuinka valita oikea synteettisen tiedon tuottomenetelmä?

Synteettisen datan luomisen monipuolisessa ympäristössä on tarjolla runsaasti menetelmiä, joista jokainen kilpailee huomiosta ainutlaatuisilla ominaisuuksillaan. Sopivimman menetelmän valitseminen tiettyyn sovellukseen edellyttää perusteellista ymmärrystä kunkin vaihtoehdon suorituskykyominaisuuksista. Tämä edellyttää erilaisten synteettisten datageneraattoreiden kattavaa arviointia, joka perustuu hyvin määriteltyihin mittareihin, jotta tietoon perustuva päätös voidaan tehdä.

Seuraavassa on tiukka vertaileva analyysi Syntho Enginestä yhdessä tunnetun avoimen lähdekoodin kehyksen, Synthetic Data Vaultin (SDV) kanssa. Tässä analyysissä käytimme monia yleisesti käytettyjä mittareita, kuten tilastotarkkuutta, ennustetarkkuutta ja muuttujien välistä suhdetta.

Synteettisten tietojen arviointimetrit

Ennen kuin otamme käyttöön mitään tiettyä mittaria, meidän on tunnustettava, että synteettisten tietojen arviointiin liittyy lukuisia ideologioita, joista jokainen antaa käsityksen tietystä datan osa-alueesta. Tätä silmällä pitäen seuraavat kolme luokkaa erottuvat tärkeistä ja kattavista. Nämä mittarit tarjoavat näkemyksiä tietojen laadun eri näkökohdista. Nämä luokat ovat:

- Tilastolliset tarkkuusmittarit: Tietojen tilastollisten perusominaisuuksien, kuten keskiarvojen ja varianssien, tutkiminen varmistaakseen, että synteettiset tiedot ovat linjassa alkuperäisen tietojoukon tilastollisen profiilin kanssa.

- Ennustava tarkkuus: Synteettisen datan luontimallin suorituskyvyn tutkiminen, alkuperäisellä tiedolla opetettu ja synteettisellä datalla arvioitu (Train Real – Test Synthetic, TRTS) ja päinvastoin (Train Synthetic – Test Real, TSTR)

- Muuttujien väliset suhteet: Tämä yhdistetty luokka sisältää:

- Ominaisuuden korrelaatio: Arvioimme korrelaatiokertoimien avulla, kuinka hyvin synteettinen data ylläpitää muuttujien välisiä suhteita. Tunnettu mittari, kuten Propensity Mean Squared Error (PMSE), olisi tätä tyyppiä.

- Keskinäiset tiedot: Mittaamme muuttujien keskinäisiä riippuvuuksia ymmärtääksemme näiden suhteiden syvyyden pelkkien korrelaatioiden lisäksi.

Vertaileva analyysi: Syntho Engine vs. avoimen lähdekoodin vaihtoehdot

Vertaileva analyysi suoritettiin käyttämällä standardoitua arviointikehystä ja identtisiä testaustekniikoita kaikissa malleissa, mukaan lukien Syntho Engine- ja SDV-mallit. Syntetisoimalla tietojoukkoja identtisistä lähteistä ja suorittamalla ne samoilla tilastollisilla testeillä ja koneoppimismallin arvioinneilla varmistamme oikeudenmukaisen ja puolueettoman vertailun. Seuraavassa osiossa kerrotaan kunkin synteettisen tiedon generaattorin suorituskyvystä yllä esitetyillä mittareilla.

Mitä tulee arvioinnissa käytettyyn tietoaineistoon, käytimme UCI Adult's Census Dataset joka on koneoppimisyhteisössä hyvin tunnettu tietojoukko. Puhdistimme tiedot ennen kaikkea harjoittelua ja jaoimme sitten tietojoukon kahteen ryhmään (harjoitus- ja pitosarja testausta varten). Käytimme koulutusjoukkoa luodaksemme miljoona uutta datapistettä kunkin mallin kanssa ja arvioimme erilaisia mittareita näissä luoduissa tietojoukkoissa. Muissa koneoppimisen arvioinneissa käytimme holdout-joukkoa arvioimaan mittareita, kuten TSTR- ja TRTS-mittareita.

Jokainen generaattori ajettiin oletusparametreilla. Koska jotkin mallit, kuten Syntho, voivat työskennellä suoraan minkä tahansa taulukkotiedon kanssa, hienosäätöä ei tehty. Oikeiden hyperparametrien etsiminen kullekin mallille veisi huomattavasti aikaa, ja taulukosta 2 näkyy jo suuri aikaero Synthon mallin ja testattujen mallien välillä.

On huomionarvoista, että toisin kuin muut SDV:n mallit, Gaussian Copula Synthesizer perustuu tilastollisiin menetelmiin. Sitä vastoin loput perustuvat hermoverkkoihin, kuten Generative Adversarial Networks (GAN) -malleihin ja variaatioisiin automaattisiin koodereihin. Tästä syystä Gaussian Copulaa voidaan pitää lähtökohtana kaikille käsitellyille malleille.

tulokset

Tietojen laatu

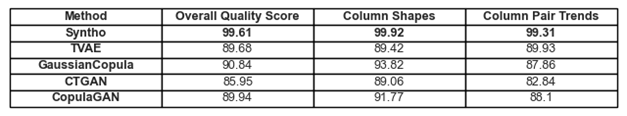

Kuva 1. Kaikkien mallien laadun perustulosten visualisointi

Aiemmin käsitellyt trendien noudattaminen ja tiedon esitykset löytyvät kuvasta 1 ja taulukosta 1. Tässä jokainen käytössä oleva mittari voidaan tulkita seuraavasti:

- Yleiset laatupisteet: Synteettisten tietojen laadun kokonaisarvio, jossa yhdistyvät eri näkökohdat, kuten tilastollinen samankaltaisuus ja tietojen ominaisuudet.

- Sarakemuodot: Arvioi, säilyvätkö synteettiset tiedot saman jakautumismuodon kuin kunkin sarakkeen todelliset tiedot.

- Sarakeparien trendit: Arvioi synteettisten tietojen sarakeparien välisiä suhteita tai korrelaatioita todellisiin tietoihin verrattuna.

Kaiken kaikkiaan voidaan havaita, että Syntho saavuttaa erittäin korkeat pisteet kautta linjan. Ensinnäkin, kun tarkastellaan tietojen yleistä laatua (arvioitu SDV-metriikkakirjastolla), Syntho voi saavuttaa yli 99 % tuloksen (sarakkeen muodon tarttuvuuden ollessa 99.92 % ja sarakeparin muodon tarttuvuuden ollessa 99.31 %). Tämä on, kun taas SDV saa maksimituloksen 90.84 % (Gaussian Copulalla, jonka pylvään muodon tarttuvuus on 93.82 % ja pylväsparin muodon tarttuvuus 87.86 %).

Taulukko 1. Taulukkoesitys kunkin luodun tietojoukon laatupisteistä mallikohtaisesti

Tietojen kattavuus

SDV:n diagnoosiraporttimoduuli kiinnittää huomiomme siihen, että SDV:n luomista tiedoista (kaikissa tapauksissa) puuttuu yli 10 % numeroalueista; Triplet-Based Variational Autoencoderin (TVAE) tapauksessa sama määrä kategorista tietoa puuttuu myös alkuperäiseen tietojoukkoon verrattuna. Tällaisia varoituksia ei luotu Synthon avulla saavutetuilla tuloksilla.

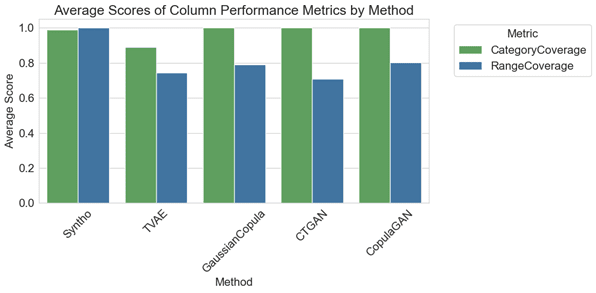

Kuva 2. Kaikkien mallien keskimääräisten sarakekohtaisten suorituskykymittojen visualisointi

Vertailevassa analyysissä kuvan 2 kaavio havainnollistaa, että SDV-arkistointi tuottaa marginaalisesti parempia tuloksia luokkakattavuudessa joillain malleillaan (eli GaussianCopula-, CopulaGAN- ja Conditional Tabular GAN -CTGAN-malleilla). Siitä huolimatta on tärkeää korostaa, että Synthon tietojen luotettavuus ylittää SDV-mallien luotettavuuden, koska eroavaisuus kattavuudessa luokkien ja alueiden välillä on minimaalinen, ja varianssi on vain 1.1 %. Sitä vastoin SDV-malleissa on huomattava vaihtelu, joka vaihtelee 14.6 prosentista 29.2 prosenttiin.

Tässä esitetyt mittarit voidaan tulkita seuraavasti:

- Kategorian kattavuus: Mittaa kaikkien luokkien läsnäoloa synteettisissä tiedoissa todellisiin tietoihin verrattuna.

- Alueen kattavuus: Arvioi, kuinka hyvin synteettisten tietojen arvoalue vastaa todellisen datan arvoja.

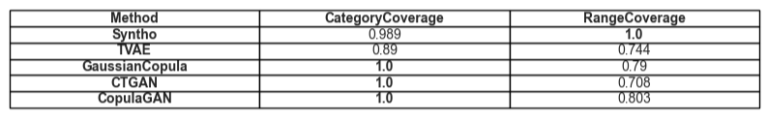

Taulukko 2. Taulukkoesitys tietyn attribuuttityypin keskimääräisestä kattavuudesta mallia kohden

Hyödyllisyys

Siirryttäessä aiheeseen synteettisen datan käyttökelpoisuus, datan koulutusmallien sisällöstä tulee ajankohtainen. Tasapainoisen ja oikeudenmukaisen vertailun saavuttamiseksi kaikkien kehysten välillä olemme valinneet oletusarvoisen Gradient Boosting Classifier -luokituksen SciKit Learn -kirjastosta, koska se on melko hyväksytty hyvin toimivaksi malliksi, jossa on valmiit asetukset.

Koulutetaan kahta eri mallia, toinen synteettisistä tiedoista (TSTR:lle) ja toinen alkuperäisille tiedoille (TRTS:lle). Synteettiselle datalle opetettu malli arvioidaan käyttämällä holdout-testisarjaa (jota ei käytetty synteettisen datan luomisen aikana) ja alkuperäiseen dataan opetettu malli testataan synteettisellä tietojoukolla.

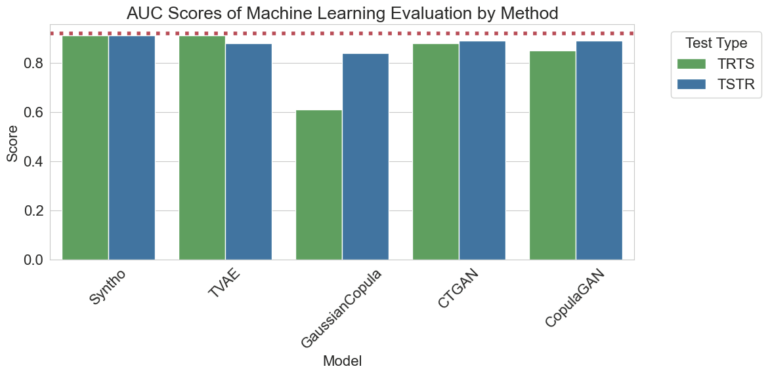

Kuva 3. Käyrän alaisen alueen (AUC) tulosten visualisointi menetelmää ja mallia kohti

Yllä visualisoidut tulokset osoittavat Syntho-moottorin synteettisen datan generoinnin ylivertaisuuden muihin menetelmiin verrattuna, koska eri menetelmillä saatujen tulosten välillä ei ole eroa (osoittaa suurta samankaltaisuutta synteettisen ja todellisen datan välillä). Myös kaaviossa oleva punainen katkoviiva on tulos, joka on saatu arvioimalla Train Real, Test Real (TRTR) -testin perussuorituskyky, jotta saadaan perusviiva havaittuille mittareille. Tämä viiva edustaa arvoa 0.92, joka on käyrän alla oleva pinta-ala (AUC-pisteet), joka on saavutettu todellisella tiedolla opetetulla ja todellisella tiedolla testatulla mallilla.

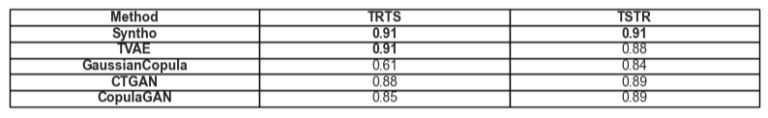

Taulukko 3. Taulukkoesitys TRTS:n ja TSTR:n saavuttamista AUC-pisteistä mallikohtaisesti.

Ajankohtainen vertailu

Luonnollisesti on tärkeää ottaa huomioon näiden tulosten tuottamiseen käytetty aika. Alla oleva visualisointi havainnollistaa juuri tätä.

Kuva 5. Visualisointi harjoitteluun ja suoritukseen käytetystä ajasta synteettinen tiedontuotanto miljoonan tietopisteen mallilla grafiikkasuorittimella tai ilman.

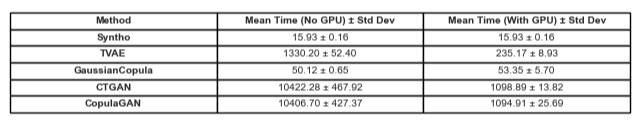

Kuva 5 havainnollistaa aikaa, joka kuluu synteettisen datan luomiseen kahdessa eri asetuksessa. Ensimmäiset (jota kutsutaan tässä ilman GPU:ta) olivat testiajoja, jotka suoritettiin Intel Xeon -suorittimella, jossa on 16 ydintä 2.20 GHz:n taajuudella. Testit, joissa oli merkintä "ajoi GPU:lla", tehtiin järjestelmässä, jossa oli AMD Ryzen 9 7945HX -suoritin, jossa oli 16 ydintä 2.5 GHz:n taajuudella ja NVIDIA GeForce RTX 4070 kannettavan tietokoneen GPU. Kuten alla olevassa kuvassa 2 ja taulukossa 2 havaitaan, voidaan havaita, että Syntho on huomattavasti nopeampi synteettisen datan luomisessa (molemmissa skenaarioissa), mikä on kriittistä dynaamisessa työnkulussa.

Taulukko 5. Taulukkoesitys kuluneesta ajasta synteettinen tiedontuotanto miljoona datapistettä jokaisella mallilla grafiikkasuorittimella ja ilman

Havainnot korostavat perusteellisen laadunarvioinnin merkitystä oikean synteettisen tiedon tuottomenetelmän valinnassa. Syntho's Engine, jolla on tekoälyyn perustuva lähestymistapa, osoittaa merkittäviä vahvuuksia tietyissä mittareissa, kun taas avoimen lähdekoodin työkalut, kuten SDV, loistavat monipuolisuudessaan ja yhteisölähtöisissä parannuksissa.

Synteettisen datan alan kehittyessä edelleen, kehotamme sinua käyttämään näitä mittareita projekteissasi, tutkimaan niiden monimutkaisuutta ja jakamaan kokemuksiasi. Pysy kuulolla tulevissa postauksissa, joissa sukeltamme syvemmälle muihin mittareihin ja korostamme todellisia esimerkkejä niiden soveltamisesta.

Loppujen lopuksi niille, jotka haluavat testata vesiä synteettisellä datalla, esitetty avoimen lähdekoodin vaihtoehto voi olla oikeutettu valinta saavutettavuuden vuoksi; Kuitenkin ammattilaisten, jotka sisällyttävät tämän modernin teknologian kehitysprosessiinsa, on käytettävä kaikki mahdolliset parannukset ja vältettävä kaikkia esteitä. Siksi on tärkeää valita paras saatavilla oleva vaihtoehto. Yllä olevien analyysien perusteella käy melko selväksi, että Syntho ja sen myötä Syntho Engine ovat erittäin pätevä työkalu harjoittajille.

Tietoja Synthosta

Syntho tarjoaa älykkään synteettisen tiedontuotantoalustan, joka hyödyntää useita synteettisiä tietomuotoja ja -menetelmiä ja antaa organisaatioille mahdollisuuden muuttaa dataa älykkäästi kilpailueduksi. Tekoälyn luoma synteettinen tietomme jäljittelee alkuperäisen datan tilastollisia malleja ja varmistaa tarkkuuden, yksityisyyden ja nopeuden ulkopuolisten asiantuntijoiden, kuten SAS:n, arvioiden mukaan. Älykkäillä tunnistusominaisuuksilla ja johdonmukaisella kartoituksella arkaluontoiset tiedot suojataan samalla, kun viitteellinen eheys säilyy. Alustamme mahdollistaa testidatan luomisen, hallinnan ja hallinnan ei-tuotantoympäristöihin käyttämällä sääntöpohjaisia synteettisiä tiedon luontimenetelmiä kohdistetuissa skenaarioissa. Lisäksi käyttäjät voivat luoda synteettistä dataa ohjelmallisesti ja hankkia realistisia testitietoja kattavien testaus- ja kehitysskenaarioiden kehittämiseksi helposti.

Haluatko oppia lisää käytännön sovellutuksia synteettiselle datalle? Voit vapaasti aikataulu demo!

Tietoja kirjoittajista

Ohjelmistotekniikan harjoittelija

raakaam on kandidaatin opiskelija Delftin teknillisessä yliopistossa ja on ohjelmistotekniikan harjoittelija Syntho.

Koneoppiminen

Mihai saavutti tohtorin tutkinnon Bristolin yliopisto käsittelee robotiikkaan sovellettua hierarkkista vahvistusoppimista ja on a Koneoppimisinsinööri at Syntho.

Tallenna synteettisten tietojen opas nyt!

- Mikä on synteettinen data?

- Miksi organisaatiot käyttävät sitä?

- Arvoa lisäävät synteettiset dataasiakastapaukset

- Kuinka aloittaa