Tekoälyn luoma synteettinen data, helppo ja nopea pääsy korkealaatuiseen dataan?

AI tuotti käytännössä synteettistä dataa

Syntho, tekoälyn tuottaman synteettisen datan asiantuntija, pyrkii kääntymään privacy by design kilpailuetuksi tekoälyn luoman synteettisen tiedon avulla. Ne auttavat organisaatioita rakentamaan vahvan tietopohjan helpon ja nopean pääsyn korkealaatuisiin tietoihin ja voittivat äskettäin Philips Innovation Award -palkinnon.

Synteettinen tiedon tuottaminen tekoälyllä on kuitenkin suhteellisen uusi ratkaisu, joka tyypillisesti esittelee usein kysyttyjä kysymyksiä. Vastatakseen näihin kysymyksiin Syntho aloitti tapaustutkimuksen yhdessä Advanced Analytics- ja AI-ohjelmistojen markkinajohtajan SAS:n kanssa.

Yhteistyössä Dutch AI Coalitionin (NL AIC) kanssa he tutkivat synteettisen datan arvoa vertaamalla Syntho Enginen luomaa tekoälyn luomaa synteettistä dataa alkuperäiseen dataan erilaisten tietojen laatua, oikeudellista pätevyyttä ja käytettävyyttä koskevien arvioiden avulla.

Eikö tietojen anonymisointi ole ratkaisu?

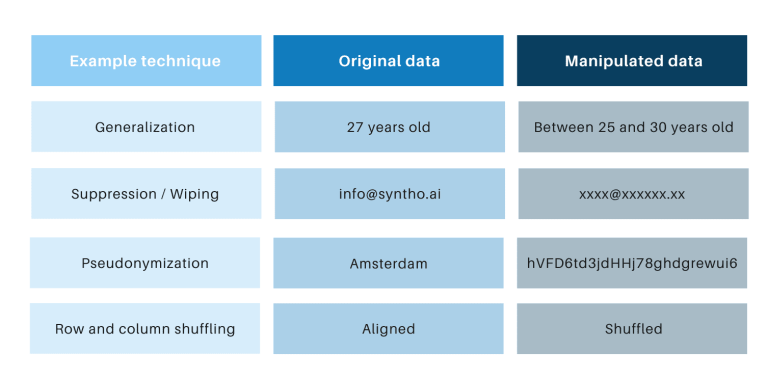

Klassisille anonymisointitekniikoille on yhteistä, että ne käsittelevät alkuperäisiä tietoja henkilöiden jäljittämisen estämiseksi. Esimerkkejä ovat yleistäminen, tukahduttaminen, pyyhkiminen, pseudonymisointi, tietojen peittäminen ja rivien ja sarakkeiden sekoittaminen. Löydät esimerkkejä alla olevasta taulukosta.

Nämä tekniikat tuovat esiin kolme keskeistä haastetta:

- Ne toimivat eri tavalla tietotyypin ja tietojoukon mukaan, mikä tekee niistä vaikeasti skaalaavia. Lisäksi, koska ne toimivat eri tavalla, keskustelua käydään aina siitä, mitä menetelmiä sovelletaan ja mitä tekniikoiden yhdistelmää tarvitaan.

- Alkuperäisten tietojen kanssa on aina yksi-yhteen suhde. Tämä tarkoittaa, että tietosuojariski on aina olemassa, erityisesti kaikkien avoimien tietojoukkojen ja käytettävissä olevien tekniikoiden vuoksi näiden tietojoukkojen linkittämiseksi.

- He käsittelevät tietoja ja tuhoavat dataa prosessin aikana. Tämä on erityisen tuhoisaa tekoälytehtävissä, joissa "ennustevoima" on välttämätöntä, koska huonolaatuiset tiedot johtavat huonoihin näkemyksiin tekoälymallista (Roskat sisään johtaa roskat pois).

Näitä seikkoja arvioidaan myös tämän tapaustutkimuksen avulla.

Johdatus tapaustutkimukseen

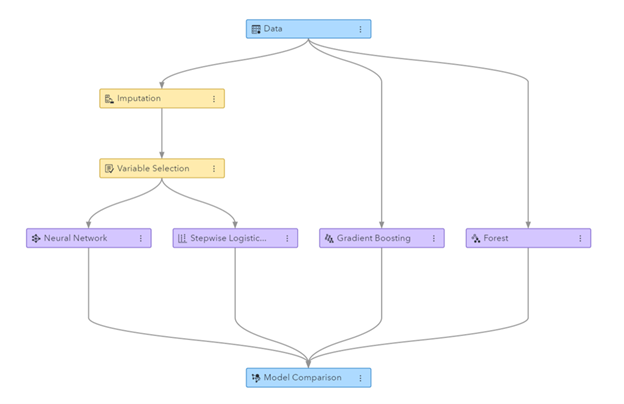

Tapaustutkimuksessa kohteena oli SAS:n toimittama tietoliikennetietojoukko, joka sisälsi 56.600 128 asiakkaan tiedot. Aineisto sisältää XNUMX saraketta, joista yksi kertoo, onko asiakas lähtenyt yrityksestä (eli 'churned') vai ei. Tapaustutkimuksen tavoitteena oli käyttää synteettistä dataa joidenkin mallien kouluttamiseen ennustamaan asiakkaiden vaihtuvuutta ja arvioimaan näiden koulutettujen mallien suorituskykyä. Koska vaihtuvuusennuste on luokitustehtävä, SAS valitsi neljä suosittua luokitusmallia ennusteiden tekemiseen, mukaan lukien:

- Satunnainen metsä

- Gradientin tehostaminen

- Logistinen regressio

- Neuraaliverkko

Ennen synteettisen datan luomista SAS jakoi televiestintätietojoukon satunnaisesti junasarjaksi (mallien kouluttamista varten) ja holdout-joukoksi (mallien pisteytystä varten). Erillinen pidätysjoukko pisteytystä varten mahdollistaa puolueettoman arvion siitä, kuinka hyvin luokitusmalli voi toimia, kun sitä sovelletaan uusiin tietoihin.

Käyttämällä junajoukkoa syötteenä Syntho käytti Syntho Engineään synteettisen tietojoukon luomiseen. Vertailuanalyysiä varten SAS loi myös manipuloidun version junasarjasta soveltamalla erilaisia anonymisointitekniikoita tietyn kynnyksen (k-anonimiteetti) saavuttamiseksi. Edelliset vaiheet johtivat neljään tietojoukkoon:

- Junatietojoukko (eli alkuperäinen tietojoukko miinus holdout-tietojoukko)

- Holdout-tietojoukko (eli alkuperäisen tietojoukon osajoukko)

- Anonymisoitu tietojoukko (perustuu junan tietojoukkoon)

- Synteettinen tietojoukko (perustuu junatietojoukkoon)

Tietojoukkoja 1, 3 ja 4 käytettiin kunkin luokitusmallin kouluttamiseen, jolloin saatiin 12 (3 x 4) koulutettua mallia. Myöhemmin SAS käytti holdout-tietojoukon mittaamaan tarkkuutta, jolla kukin malli ennustaa asiakkaiden vaihtuvuuden. Tulokset on esitetty alla aloittaen muutamista perustilastoista.

Kuva: SAS Visual Data Miningissa ja koneoppimisessa luotu koneoppimisputki

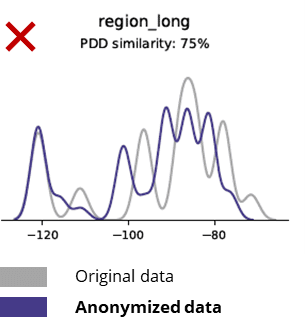

Perustilastot verrattaessa anonymisoituja tietoja alkuperäisiin tietoihin

Anonymisointitekniikat tuhoavat jopa perusmallit, liiketoimintalogiikan, suhteet ja tilastot (kuten alla olevassa esimerkissä). Anonymisoitujen tietojen käyttäminen perusanalytiikkaan tuottaa siten epäluotettavia tuloksia. Itse asiassa anonymisoidun tiedon huono laatu teki lähes mahdottomaksi käyttää sitä edistyneisiin analytiikkatehtäviin (esim. AI/ML-mallinnus ja dashboarding).

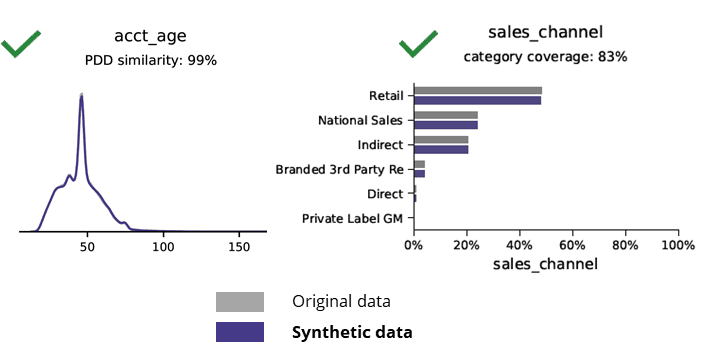

Perustilastot verrattaessa synteettisiä tietoja alkuperäisiin tietoihin

Synteettinen datan luominen tekoälyllä säilyttää perusmallit, liiketoimintalogiikan, suhteet ja tilastot (kuten alla olevassa esimerkissä). Synteettisten tietojen käyttö perusanalytiikkaan tuottaa siis luotettavia tuloksia. Keskeinen kysymys, säilyykö synteettinen data edistyneitä analytiikkatehtäviä varten (esim. AI/ML-mallinnus ja kojelautailu)?

Tekoälyn luoma synteettinen data ja edistynyt analytiikka

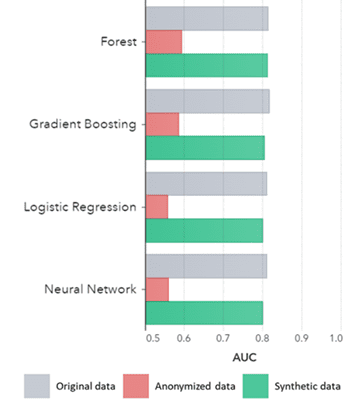

Synteettiset tiedot eivät pidä paikkaansa vain peruskuvioista (kuten edellisissä kaavioissa on esitetty), se kaappaa myös syviä "piilotettuja" tilastollisia kuvioita, joita tarvitaan edistyneisiin analytiikkatehtäviin. Jälkimmäinen on havainnollistettu alla olevassa pylväskaaviossa, mikä osoittaa, että synteettiselle datalle opetettujen mallien tarkkuus verrattuna alkuperäisiin tietoihin on samanlainen. Lisäksi, kun käyrän alla oleva pinta-ala (AUC*) on lähellä 0.5, anonymisoidulle datalle opetetut mallit toimivat selvästi huonoimmin. Täydellinen raportti, jossa on kaikki synteettisten tietojen kehittyneet analyyttiset arvioinnit verrattuna alkuperäisiin tietoihin, on saatavilla pyynnöstä.

*AUC: käyrän alla oleva pinta-ala on edistyneiden analytiikkamallien tarkkuuden mitta, jossa otetaan huomioon todelliset positiiviset, väärät positiiviset, väärät negatiiviset ja todelliset negatiiviset. 0,5 tarkoittaa, että malli ennustaa satunnaisesti eikä sillä ole ennustevoimaa ja 1 tarkoittaa, että malli on aina oikea ja sillä on täysi ennustevoima.

Lisäksi tätä synteettistä dataa voidaan käyttää mallien varsinaiseen harjoitteluun tarvittavien tietojen ominaisuuksien ja päämuuttujien ymmärtämiseen. Algoritmien valitsemat syötteet synteettiselle datalle verrattuna alkuperäiseen dataan olivat hyvin samanlaisia. Näin ollen mallinnusprosessi voidaan tehdä tälle synteettiselle versiolle, mikä vähentää tietomurtojen riskiä. Yksittäisiä tietueita pääteltäessä (esim. puhelinasiakas) kuitenkin suositellaan alkuperäisten tietojen uudelleenkoulutusta selitettävyyden, paremman hyväksynnän tai vain sääntelyn vuoksi.

AUC algoritmin mukaan ryhmitelty menetelmän mukaan

Johtopäätökset:

- Synteettisellä datalla opetetut mallit verrattuna alkuperäisiin tietoihin opetetut mallit osoittavat hyvin samanlaista suorituskykyä

- Mallit, jotka on koulutettu anonymisoidulle datalle "klassisilla anonymisointitekniikoilla" osoittavat huonompaa suorituskykyä verrattuna mallit, jotka on koulutettu alkuperäisellä tiedolla tai synteettisellä tiedolla

- Synteettinen tiedon luominen on helppoa ja nopeaa, koska tekniikka toimii täsmälleen samalla tavalla tietojoukon ja tietotyypin mukaan.

Arvoa lisäävän synteettisen tiedon käyttötapaukset

Käyttötapaus 1: Synteettinen data mallin kehittämiseen ja edistyneeseen analytiikkaan

Mallien (esim. dashboards [BI] ja kehittynyt analytiikka [AI & ML]) kehittämiseen tarvitaan vahva tietopohja sekä helppo ja nopea pääsy käyttökelpoiseen, korkealaatuiseen dataan. Monet organisaatiot kärsivät kuitenkin epäoptimaalisesta tietopohjasta, mikä johtaa kolmeen keskeiseen haasteeseen:

- Tietojen saanti kestää (yksityisyyden) määräysten, sisäisten prosessien tai tietosiilojen vuoksi

- Klassiset anonymisointitekniikat tuhoavat tiedot, jolloin tiedot eivät enää sovellu analysointiin ja edistyneeseen analytiikkaan (roskat sisään = roskat ulos)

- Nykyiset ratkaisut eivät ole skaalautuvia, koska ne toimivat eri tavalla tietojoukon ja tietotyypin mukaan eivätkä pysty käsittelemään suuria usean taulukon tietokantoja

Synteettisen datan lähestymistapa: kehitä malleja, joissa on yhtä hyvää kuin todellista synteettistä dataa:

- Minimoi alkuperäisen datan käyttö estämättä kehittäjiäsi

- Avaa henkilökohtaisten tietojen lukitus ja saat käyttöösi muita aiemmin rajoitettuja tietoja (esim. Yksityisyyden vuoksi)

- Helppo ja nopea pääsy olennaisiin tietoihin

- Skaalautuva ratkaisu, joka toimii samalla tavalla jokaiselle tietojoukolle, tietotyypille ja massiivisille tietokannoille

Tämän ansiosta organisaatio voi rakentaa vahvan tietopohjan, jolla on helppo ja nopea pääsy käyttökelpoiseen, korkealaatuiseen dataan tietojen lukituksen avaamiseksi ja datamahdollisuuksien hyödyntämiseksi.

Käyttötapaus 2: älykäs synteettinen testidata ohjelmistojen testaukseen, kehittämiseen ja toimitukseen

Laadukkaiden testitietojen testaus ja kehittäminen on välttämätöntä huippuluokan ohjelmistoratkaisujen toimittamiseksi. Alkuperäisten tuotantotietojen käyttäminen näyttää itsestään selvältä, mutta se ei ole sallittua (yksityisyyden) säännösten vuoksi. Vaihtoehtoinen Test Data Management (TDM) työkalut esittelevät "legacy-by-design” saadaksesi testitiedot oikein:

- Ei heijasta tuotantotietoja ja liiketoimintalogiikkaa ja viittauksen eheyttä ei säilytetä

- Työskentely hidasta ja aikaa vievää

- Käsityötä tarvitaan

Synteettinen datalähestymistapa: Testaa ja kehitä tekoälyn luoman synteettisen testidatan avulla tuottaaksesi huippuluokan ohjelmistoratkaisuja, jotka sisältävät:

- Tuotannon kaltaiset tiedot, joissa on säilynyt liiketoimintalogiikka ja viitteellinen eheys

- Helppo ja nopea tiedon luominen huipputeknologian avulla

- Yksityisyys suunnittelun mukaan

- Helppoa, nopeaa ja agile

Tämä antaa organisaatiolle mahdollisuuden testata ja kehittää seuraavan tason testidatan avulla huippuluokan ohjelmistoratkaisuja!

Lisätietoja

Kiinnostunut? Lisätietoja synteettisistä tiedoista saat Synthon verkkosivustolta tai ottamalla yhteyttä Wim Kees Jansseniin. Lisätietoja SAS:sta on osoitteessa www.sas.com tai ota yhteyttä kees@syntho.ai.

Tässä käyttötapauksessa Syntho, SAS ja NL AIC työskentelevät yhdessä saavuttaakseen halutut tulokset. Syntho on tekoälyn luoman synteettisen datan asiantuntija ja SAS on markkinajohtaja analytiikan alalla ja tarjoaa ohjelmistoja tietojen tutkimiseen, analysointiin ja visualisointiin.

* Ennusteet 2021 – Data- ja analytiikkastrategiat digitaalisen liiketoiminnan hallintaan, mittaamiseen ja muuttamiseen, Gartner, 2020.

Tallenna synteettisten tietojen opas nyt!

- Mikä on synteettinen data?

- Miksi organisaatiot käyttävät sitä?

- Arvoa lisäävät synteettiset dataasiakastapaukset

- Kuinka aloittaa