ارزیابی کاربرد و شباهت در مولدهای داده مصنوعی: یک فرو رفتن عمیق فنی و تجزیه و تحلیل مقایسه ای

معرفی

در عصر دیجیتال امروز، آگاهی از حریم خصوصی داده ها به طور قابل توجهی افزایش یافته است. کاربران به طور فزاینده ای داده های خود را به عنوان یک اثر انگشت دیجیتال منحصر به فرد می شناسند که در صورت نقض داده ها، حریم خصوصی آنها را به خطر می اندازد. این نگرانی با مقرراتی مانند GDPR تشدید میشود که به کاربران اجازه میدهد درخواست حذف دادههای خود را داشته باشند. در حالی که بسیار مورد نیاز است، این قانون می تواند برای شرکت ها بسیار پرهزینه باشد زیرا دسترسی به داده ها به حداقل می رسد. محدودیتهایی که غالباً غلبه بر آنها زمانبر و زمانبر است.

فهرست مندرجات

مولدهای داده مصنوعی چیست؟

داده های مصنوعی را وارد کنید، راه حلی برای این معماست. مولدهای داده مصنوعی مجموعه داده هایی را ایجاد می کنند که از داده های واقعی کاربر تقلید می کنند و در عین حال ناشناس بودن و محرمانه بودن را حفظ می کنند. این رویکرد در سراسر صنایع، از مراقبت های بهداشتی گرفته تا امور مالی، که در آن حریم خصوصی در اولویت است، در حال افزایش است.

چگونه روش تولید داده مصنوعی مناسب را انتخاب کنیم؟

در چشمانداز متنوع تولید دادههای مصنوعی، روشهای فراوانی وجود دارد که هر کدام با قابلیتهای منحصربهفرد خود برای جلب توجه رقابت میکنند. انتخاب مناسب ترین روش برای یک کاربرد خاص مستلزم درک کامل ویژگی های عملکرد هر گزینه است. این امر مستلزم ارزیابی جامع مولدهای مختلف داده مصنوعی بر اساس مجموعه ای از معیارهای به خوبی تعریف شده برای تصمیم گیری آگاهانه است.

آنچه در ادامه میآید، یک تحلیل مقایسهای دقیق از موتور Syntho در کنار یک چارچوب منبع باز شناخته شده، مخزن داده مصنوعی (SDV) است. در این تحلیل، ما از بسیاری از معیارهای رایج مانند وفاداری آماری، دقت پیشبینی و رابطه بین متغیری استفاده کردیم.

معیارهای ارزیابی داده های مصنوعی

قبل از معرفی هر معیار خاصی، باید اذعان کنیم که ایدئولوژیهای متعددی در مورد ارزیابی دادههای ترکیبی وجود دارد که هر یک بینشی نسبت به جنبه خاصی از دادهها میدهد. با در نظر گرفتن این موضوع، سه دسته زیر به عنوان مهم و جامع برجسته می شوند. این معیارها بینش هایی را در مورد جنبه های مختلف کیفیت داده ها ارائه می دهند. این دسته بندی ها عبارتند از:

- معیارهای وفاداری آماری: بررسی ویژگی های آماری اولیه داده ها، مانند میانگین ها و واریانس ها، برای اطمینان از همسویی داده های مصنوعی با مشخصات آماری مجموعه داده اصلی.

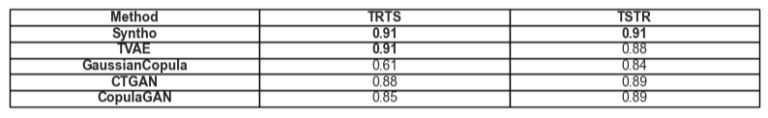

- دقت پیش بینی: بررسی عملکرد مدل تولید داده های مصنوعی، آموزش داده شده با داده های اصلی، و ارزیابی بر روی داده های مصنوعی (Train Real – Test Synthetic، TRTS) و بالعکس (Train Synthetic – Test Real، TSTR)

- روابط بین متغیری: این دسته ترکیبی شامل:

- همبستگی ویژگی: ما ارزیابی می کنیم که چگونه داده های مصنوعی روابط بین متغیرها را با استفاده از ضرایب همبستگی حفظ می کنند. یک معیار شناخته شده مانند خطای میانگین مربعات تمایل (PMSE) از این نوع خواهد بود.

- اطلاعات متقابل: ما وابستگی های متقابل بین متغیرها را اندازه گیری می کنیم تا عمق این روابط را فراتر از همبستگی ها درک کنیم.

تجزیه و تحلیل مقایسه ای: Syntho Engine در مقابل جایگزین های منبع باز

تجزیه و تحلیل مقایسهای با استفاده از یک چارچوب ارزیابی استاندارد و تکنیکهای تست یکسان در همه مدلها، از جمله موتورهای Syntho و مدلهای SDV انجام شد. با ترکیب مجموعههای داده از منابع یکسان و قرار دادن آنها در آزمایشهای آماری مشابه و ارزیابیهای مدل یادگیری ماشین، از مقایسه منصفانه و بیطرفانه اطمینان حاصل میکنیم. بخش زیر به جزئیات عملکرد هر تولید کننده داده مصنوعی در محدوده معیارهای ارائه شده در بالا میپردازد.

در مورد مجموعه داده مورد استفاده برای ارزیابی، ما از آن استفاده کردیم مجموعه داده های سرشماری بزرگسالان UCI که یک مجموعه داده شناخته شده در جامعه یادگیری ماشینی است. ما داده ها را قبل از تمام آموزش ها تمیز کردیم و سپس مجموعه داده را به دو مجموعه (یک مجموعه آموزشی و یک مجموعه نگهدارنده برای آزمایش) تقسیم کردیم. ما از مجموعه آموزشی برای تولید 1 میلیون نقطه داده جدید با هر یک از مدلها استفاده کردیم و معیارهای مختلفی را روی این مجموعه دادههای تولید شده ارزیابی کردیم. برای ارزیابیهای بیشتر یادگیری ماشین، از مجموعه نگهداری برای ارزیابی معیارهایی مانند موارد مربوط به TSTR و TRTS استفاده کردیم.

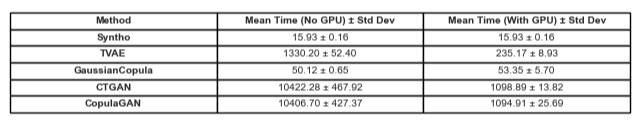

هر ژنراتور با پارامترهای پیش فرض اجرا شد. از آنجایی که برخی از مدلها، مانند Syntho، میتوانند خارج از جعبه روی هر داده جدولی کار کنند، هیچ تنظیم دقیقی انجام نشد. جستجوی فراپارامترهای مناسب برای هر مدل زمان قابل توجهی را می طلبد و جدول 2 قبلاً تفاوت زمانی زیادی را بین مدل Syntho و مدل های آزمایش شده نشان می دهد.

قابل ذکر است که برخلاف بقیه مدلها در SDV، سینتیسایزر کوپولای گاوسی بر اساس روشهای آماری است. در مقابل، بقیه مبتنی بر شبکههای عصبی مانند مدلهای شبکههای متخاصم مولد (GAN) و رمزگذارهای خودکار متغیر هستند. به همین دلیل است که کوپولای گاوسی را می توان به عنوان یک خط پایه برای همه مدل های مورد بحث در نظر گرفت.

نتایج

کیفیت داده

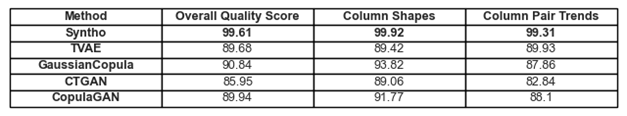

شکل 1. تجسم نتایج کیفیت پایه برای همه مدل ها

پایبندی هایی که قبلاً به روندها و بازنمایی در داده ها پرداخته شد را می توان در شکل 1 و جدول 1 یافت. در اینجا، هر یک از معیارهای مورد استفاده را می توان به صورت زیر تفسیر کرد:

- امتیاز کیفیت کلی: ارزیابی کلی کیفیت داده های مصنوعی، ترکیبی از جنبه های مختلف مانند شباهت آماری و ویژگی های داده ها.

- شکلهای ستونی: ارزیابی میکند که آیا دادههای مصنوعی همان شکل توزیع را با دادههای واقعی برای هر ستون حفظ میکنند.

- گرایش های جفت ستونی: رابطه یا همبستگی بین جفت ستون ها را در داده های مصنوعی در مقایسه با داده های واقعی ارزیابی می کند.

به طور کلی، می توان متوجه شد که Syntho به نمرات بسیار بالایی در سراسر صفحه دست می یابد. برای شروع، وقتی به کیفیت کلی داده ها نگاه می کنیم (ارزیابی شده با کتابخانه معیارهای SDV)، Syntho می تواند به نتیجه ای بالاتر از 99٪ (با پایبندی شکل ستون 99.92٪ و پایبندی به شکل جفت ستون 99.31٪) دست یابد. این در حالی است که SDV حداکثر 90.84% را به دست میآورد (با Gaussian Copula که دارای پایبندی شکل ستونی 93.82% و پایبندی به شکل جفت ستون 87.86%) است.

جدول 1. نمایش جدولی از نمرات کیفیت هر مجموعه داده تولید شده در هر مدل

پوشش داده ها

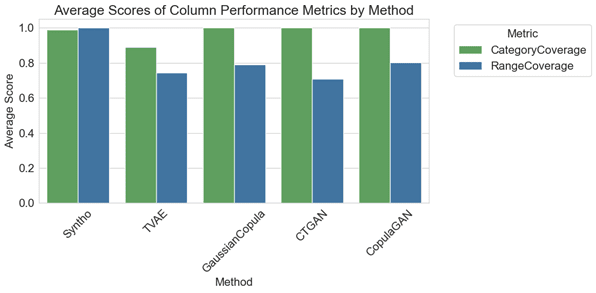

ماژول گزارش تشخیص SDV توجه ما را جلب می کند که داده های تولید شده توسط SDV (در همه موارد) بیش از 10٪ از محدوده های عددی را از دست داده اند. در مورد رمزگذار خودکار متغیر مبتنی بر سهگانه (TVAE)، همان مقدار دادههای طبقهبندی نیز در مقایسه با مجموعه داده اصلی وجود ندارد. هیچ هشداری با نتایج به دست آمده با استفاده از Syntho ایجاد نشد.

شکل 2. تجسم معیارهای میانگین عملکرد ستونی برای همه مدل ها

در تجزیه و تحلیل مقایسه ای، نمودار شکل 2 نشان می دهد که آرشیوهای SDV در پوشش مقوله با برخی از مدل هایشان (به عنوان مثال با GaussianCopula، CopulaGAN و Conditional Tabular GAN - CTGAN) نتایج اندکی بهتر نشان می دهند. با این وجود، مهم است که تأکید کنیم که قابلیت اطمینان دادههای Syntho از مدلهای SDV پیشی میگیرد، زیرا اختلاف در پوشش در بین دستهها و محدودهها حداقل است و تنها 1.1 درصد واریانس را نشان میدهد. در مقابل، مدلهای SDV تنوع قابلتوجهی را نشان میدهند که از 14.6٪ تا 29.2٪ متغیر است.

معیارهای ارائه شده در اینجا را می توان به صورت زیر تفسیر کرد:

- پوشش دسته: حضور همه دسته ها را در داده های مصنوعی در مقایسه با داده های واقعی اندازه گیری می کند.

- پوشش محدوده: ارزیابی می کند که محدوده مقادیر در داده های مصنوعی چقدر با داده های واقعی مطابقت دارد.

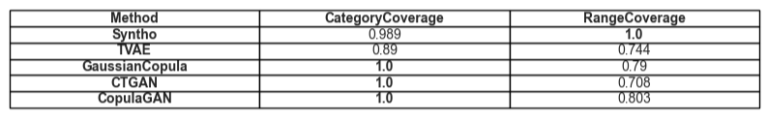

جدول 2. نمایش جدولی از میانگین پوشش یک نوع مشخصه معین در هر مدل

سودمندی

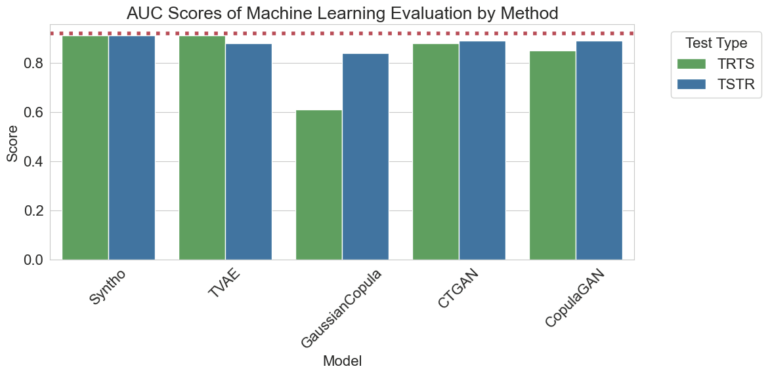

با رفتن به مبحث سودمندی داده های مصنوعی، موضوع مدل های آموزشی بر روی داده ها مرتبط می شود. برای داشتن یک مقایسه متعادل و منصفانه بین همه فریم ورکها، طبقهبندیکننده تقویت گرادیان پیشفرض را از کتابخانه SciKit Learn انتخاب کردهایم، زیرا بهعنوان مدلی با عملکرد خوب با تنظیمات خارج از جعبه پذیرفته شده است.

دو مدل مختلف آموزش داده شده اند، یکی بر روی داده های مصنوعی (برای TSTR) و دیگری بر روی داده های اصلی (برای TRTS). مدل آموزشدیده بر روی دادههای مصنوعی با استفاده از مجموعه آزمون نگهدارنده (که در طول تولید دادههای مصنوعی استفاده نشد) ارزیابی میشود و مدل آموزشدیده بر روی دادههای اصلی بر روی مجموعه داده مصنوعی آزمایش میشود.

شکل 3. تجسم امتیازات ناحیه زیر منحنی (AUC) در هر روش در هر مدل

نتایج نشاندهنده برتری تولید دادههای مصنوعی توسط موتور Syntho در مقایسه با روشهای دیگر است، زیرا تفاوتی بین نتایج بهدستآمده از روشهای مختلف وجود ندارد (اشاره به شباهت زیاد بین دادههای مصنوعی و واقعی). همچنین، خط نقطه قرمز موجود در نمودار، نتیجهای است که با ارزیابی عملکرد پایه یک آزمون Train Real, Test Real (TRTR) بهدست میآید تا یک خط پایه برای معیارهای مشاهدهشده ارائه شود. این خط مقدار 0.92 را نشان میدهد، که امتیاز ناحیه زیر منحنی (AUC امتیاز) است که توسط مدل آموزش داده شده بر روی دادههای واقعی و آزمایش شده بر روی دادههای واقعی به دست میآید.

جدول 3. نمایش جدولی از نمرات AUC به دست آمده توسط TRTS و TSTR به ترتیب در هر مدل.

مقایسه زمانی عاقلانه

به طور طبیعی، در نظر گرفتن زمان صرف شده برای تولید این نتایج بسیار مهم است. تجسم زیر دقیقاً این را نشان می دهد.

شکل 5. تجسم زمان صرف شده برای تمرین و اجرا تولید داده های مصنوعی یک میلیون نقطه داده با یک مدل با و بدون GPU.

شکل 5 زمان صرف شده برای تولید داده های مصنوعی را در دو تنظیمات مختلف نشان می دهد. اولین مورد (که در اینجا بدون GPU نامیده میشود)، آزمایشهایی بود که روی سیستمی با پردازنده Intel Xeon با 16 هسته با فرکانس 2.20 گیگاهرتز اجرا میشد. آزمایشهایی که با عنوان «اجرا شده با GPU» مشخص شدهاند، روی سیستمی با پردازنده AMD Ryzen 9 7945HX با 16 هسته با فرکانس 2.5 گیگاهرتز و پردازنده گرافیکی لپتاپ NVIDIA GeForce RTX 4070 انجام شد. همانطور که در شکل 2 و جدول 2 زیر قابل توجه است، می توان مشاهده کرد که Syntho به طور قابل توجهی در تولید داده های مصنوعی (در هر دو سناریو) سریعتر است که در یک گردش کار پویا بسیار مهم است.

جدول 5. نمایش جدولی از زمان صرف شده به تولید داده های مصنوعی یک میلیون نقطه داده با هر مدل با و بدون GPU

یافتهها بر اهمیت ارزیابی کیفیت کامل در انتخاب روش تولید دادههای مصنوعی مناسب تأکید میکنند. Syntho's Engine، با رویکرد مبتنی بر هوش مصنوعی، نقاط قوت قابل توجهی را در معیارهای خاص نشان میدهد، در حالی که ابزارهای منبع باز مانند SDV در تطبیقپذیری و پیشرفتهای مبتنی بر جامعه میدرخشند.

همانطور که حوزه داده های مصنوعی همچنان در حال تکامل است، ما شما را تشویق می کنیم که این معیارها را در پروژه های خود اعمال کنید، پیچیدگی های آنها را بررسی کنید و تجربیات خود را به اشتراک بگذارید. منتظر پست های بعدی باشید که در آن به سایر معیارها عمیق تر خواهیم پرداخت و نمونه های واقعی کاربرد آنها را برجسته خواهیم کرد.

در پایان روز، برای کسانی که به دنبال آزمایش آب بر روی داده های مصنوعی هستند، جایگزین منبع باز ارائه شده می تواند با توجه به قابلیت دسترسی، یک انتخاب قابل توجیه باشد. با این حال، برای متخصصانی که این فناوری مدرن را در فرآیند توسعه خود وارد میکنند، باید از هر فرصتی برای بهبود استفاده کرد و از همه موانع اجتناب کرد. بنابراین مهم است که بهترین گزینه موجود را انتخاب کنید. با تجزیه و تحلیل های ارائه شده در بالا کاملاً آشکار می شود که Syntho و با آن Syntho Engine ابزار بسیار توانمندی برای پزشکان است.

درباره سینتو

سینتو یک پلت فرم تولید داده مصنوعی هوشمند را فراهم می کند، از چندین فرم داده مصنوعی و روش های تولید استفاده می کند، و سازمان ها را قادر می سازد تا داده ها را هوشمندانه به یک مزیت رقابتی تبدیل کنند. دادههای مصنوعی تولید شده توسط هوش مصنوعی ما الگوهای آماری دادههای اصلی را تقلید میکند و از دقت، حریم خصوصی و سرعت اطمینان میدهد، همانطور که توسط کارشناسان خارجی مانند SAS ارزیابی میشود. با ویژگیهای شناسایی هوشمند و نقشهبرداری مداوم، اطلاعات حساس با حفظ یکپارچگی ارجاعی محافظت میشوند. پلتفرم ما ایجاد، مدیریت و کنترل دادههای آزمایشی را برای محیطهای غیرتولیدی، با استفاده از روشهای تولید داده مصنوعی مبتنی بر قوانین برای سناریوهای هدفمند، امکانپذیر میسازد. علاوه بر این، کاربران میتوانند دادههای مصنوعی را به صورت برنامهنویسی تولید کنند و دادههای آزمایشی واقعی را به دست آورند تا به راحتی سناریوهای آزمایش و توسعه جامع را توسعه دهند.

آیا می خواهید کاربردهای عملی بیشتری از داده های مصنوعی بیاموزید؟ در صورت تمایل به برنامه نمایشی برنامه ریزی!

درباره نویسندگان

کارآموز مهندسی نرم افزار

روهam دانشجوی لیسانس در دانشگاه صنعتی دلفت و کارآموز مهندسی نرم افزار در سینتو.

مهندس مکانیک

میهای دکترای خود را از دانشگاه دریافت کرد دانشگاه بریستول با موضوع یادگیری تقویتی سلسله مراتبی کاربردی در رباتیک و یک مهندس یادگیری ماشین الفt سینتو.

اکنون راهنمای داده های مصنوعی خود را ذخیره کنید!

- داده های مصنوعی چیست؟

- چرا سازمان ها از آن استفاده می کنند؟

- موارد ارزش افزوده مشتری داده مصنوعی

- چگونه شروع کنیم