Đánh giá tiện ích và sự giống nhau trong các trình tạo dữ liệu tổng hợp: Phân tích so sánh và phân tích chuyên sâu về kỹ thuật

Giới thiệu

Trong thời đại kỹ thuật số ngày nay, nhận thức về quyền riêng tư dữ liệu đã được nâng cao đáng kể. Người dùng ngày càng nhận ra dữ liệu của họ dưới dạng dấu vân tay kỹ thuật số duy nhất, gây rủi ro cho quyền riêng tư của họ trong trường hợp dữ liệu bị vi phạm. Mối lo ngại này càng tăng thêm bởi các quy định như GDPR, cho phép người dùng yêu cầu xóa dữ liệu của họ. Mặc dù rất cần thiết nhưng luật này có thể rất tốn kém đối với các công ty vì quyền truy cập vào dữ liệu bị hạn chế; những hạn chế thường tốn thời gian và nguồn lực để khắc phục.

Mục lục

Trình tạo dữ liệu tổng hợp là gì?

Nhập dữ liệu tổng hợp, một giải pháp cho câu hỏi hóc búa này. Trình tạo dữ liệu tổng hợp tạo ra các tập dữ liệu bắt chước dữ liệu người dùng thực trong khi vẫn đảm bảo tính ẩn danh và bảo mật. Cách tiếp cận này đang thu hút được sự chú ý trong các ngành, từ chăm sóc sức khỏe đến tài chính, nơi quyền riêng tư được đặt lên hàng đầu.

Làm thế nào để chọn phương pháp tạo dữ liệu tổng hợp phù hợp?

Trong bối cảnh đa dạng của việc tạo dữ liệu tổng hợp, có rất nhiều phương pháp sẵn có, mỗi phương pháp đều tranh giành sự chú ý bằng những khả năng riêng biệt của mình. Việc chọn phương pháp phù hợp nhất cho một ứng dụng cụ thể đòi hỏi sự hiểu biết thấu đáo về đặc tính hiệu suất của từng tùy chọn. Điều này đòi hỏi phải đánh giá toàn diện các trình tạo dữ liệu tổng hợp khác nhau dựa trên một tập hợp các số liệu được xác định rõ ràng để đưa ra quyết định sáng suốt.

Phần tiếp theo là phân tích so sánh nghiêm ngặt của Syntho Engine cùng với khung nguồn mở nổi tiếng, Kho dữ liệu tổng hợp (SDV). Trong phân tích này, chúng tôi đã sử dụng nhiều số liệu thường được sử dụng như độ chính xác thống kê, độ chính xác dự đoán và mối quan hệ giữa các biến.

Số liệu đánh giá dữ liệu tổng hợp

Trước khi giới thiệu bất kỳ số liệu cụ thể nào, chúng tôi phải thừa nhận rằng có rất nhiều hệ tư tưởng về việc đánh giá Dữ liệu tổng hợp, mỗi hệ tư tưởng trong số đó cung cấp cái nhìn sâu sắc về một khía cạnh nhất định của dữ liệu. Với suy nghĩ này, ba loại sau đây nổi bật là quan trọng và toàn diện. Các số liệu này cung cấp cái nhìn sâu sắc về các khía cạnh khác nhau của chất lượng dữ liệu. Những loại này là:

- Số liệu về độ trung thực thống kê: Kiểm tra các tính năng thống kê cơ bản của dữ liệu, như phương tiện và phương sai, để đảm bảo dữ liệu tổng hợp phù hợp với hồ sơ thống kê của tập dữ liệu gốc.

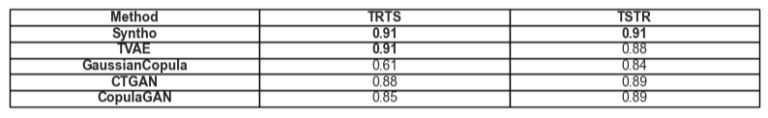

- Độ chính xác dự đoán: Kiểm tra hiệu suất của mô hình tạo dữ liệu tổng hợp, được huấn luyện bằng dữ liệu gốc và đánh giá trên dữ liệu tổng hợp (Train Real – Test Synthetic, TRTS) và ngược lại (Train Synthetic – Test Real, TSTR)

- Mối quan hệ giữa các biến: Danh mục kết hợp này bao gồm:

- Tương quan tính năng: Chúng tôi đánh giá dữ liệu tổng hợp duy trì mối quan hệ giữa các biến tốt như thế nào bằng cách sử dụng các hệ số tương quan. Một số liệu nổi tiếng như Lỗi bình phương trung bình xu hướng (PMSE) sẽ thuộc loại này.

- Thông tin lẫn nhau: Chúng tôi đo lường sự phụ thuộc lẫn nhau giữa các biến số để hiểu được chiều sâu của các mối quan hệ này ngoài mối tương quan đơn thuần.

Phân tích so sánh: Syntho Engine và các lựa chọn thay thế nguồn mở

Phân tích so sánh được thực hiện bằng cách sử dụng khung đánh giá được tiêu chuẩn hóa và các kỹ thuật kiểm tra giống hệt nhau trên tất cả các mô hình, bao gồm các mô hình Syntho Engine và SDV. Bằng cách tổng hợp các tập dữ liệu từ các nguồn giống hệt nhau và đưa chúng vào cùng các bài kiểm tra thống kê cũng như đánh giá mô hình học máy, chúng tôi đảm bảo sự so sánh công bằng và không thiên vị. Phần sau đây trình bày chi tiết về hiệu suất của từng trình tạo dữ liệu tổng hợp trên phạm vi số liệu được trình bày ở trên.

Đối với tập dữ liệu dùng để đánh giá, chúng tôi sử dụng Bộ dữ liệu điều tra dân số người lớn UCI là một bộ dữ liệu nổi tiếng trong cộng đồng học máy. Chúng tôi đã làm sạch dữ liệu trước tất cả quá trình đào tạo và sau đó chia tập dữ liệu thành hai tập (một tập huấn luyện và một tập giữ lại để thử nghiệm). Chúng tôi đã sử dụng tập huấn luyện để tạo ra 1 triệu điểm dữ liệu mới với mỗi mô hình và đánh giá các số liệu khác nhau trên các tập dữ liệu được tạo này. Để đánh giá thêm về máy học, chúng tôi đã sử dụng tập hợp giữ lại để đánh giá các số liệu chẳng hạn như các số liệu liên quan đến TSTR và TRTS.

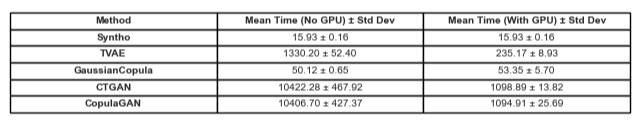

Mỗi máy phát điện được chạy với các thông số mặc định. Vì một số mô hình, như Syntho, có thể hoạt động ngay lập tức trên bất kỳ dữ liệu dạng bảng nào nên không cần tinh chỉnh. Việc tìm kiếm các siêu tham số phù hợp cho từng mô hình sẽ mất một lượng thời gian đáng kể và Bảng 2 đã cho thấy sự khác biệt lớn về thời gian giữa mô hình của Syntho và các mô hình được thử nghiệm.

Đáng chú ý là trái ngược với các mô hình còn lại trong SDV, Bộ tổng hợp Gaussian Copula dựa trên các phương pháp thống kê. Ngược lại, phần còn lại dựa trên các mạng thần kinh như mô hình Mạng đối thủ sáng tạo (GAN) và bộ mã hóa tự động biến thiên. Đây là lý do tại sao Gaussian Copula có thể được coi là cơ sở cho tất cả các mô hình được thảo luận.

Kết quả

Chất lượng dữ liệu

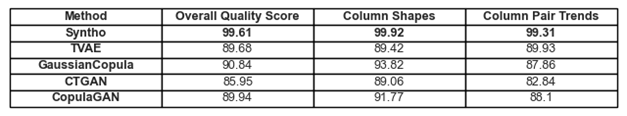

Hình 1. Trực quan hóa kết quả chất lượng cơ bản cho tất cả các mô hình

Bạn có thể tìm thấy sự tuân thủ đã thảo luận trước đây đối với các xu hướng và cách trình bày trong dữ liệu trong Hình 1 và Bảng 1. Ở đây, mỗi số liệu được sử dụng có thể được hiểu như sau:

- Điểm chất lượng tổng thể: Đánh giá tổng thể về chất lượng của dữ liệu tổng hợp, kết hợp nhiều khía cạnh khác nhau như độ tương tự về mặt thống kê và đặc điểm dữ liệu.

- Hình dạng Cột: Đánh giá xem dữ liệu tổng hợp có duy trì hình dạng phân phối giống như dữ liệu thực cho mỗi cột hay không.

- Xu hướng cặp cột: Đánh giá mối quan hệ hoặc mối tương quan giữa các cặp cột trong dữ liệu tổng hợp so với dữ liệu thực.

Nhìn chung, có thể nhận thấy rằng Syntho đạt được điểm số rất cao trên mọi phương diện. Đầu tiên, khi xem xét chất lượng dữ liệu tổng thể (được đánh giá bằng thư viện số liệu SDV), Syntho có thể đạt được kết quả lên tới 99% (với tỷ lệ tuân thủ hình dạng cột là 99.92% và tỷ lệ tuân thủ hình dạng cặp cột là 99.31%). Điều này trong khi SDV đạt được kết quả tối đa là 90.84% (với Gaussian Copula, có độ bám dính hình dạng cột là 93.82% và độ bám dính hình dạng cặp cột là 87.86%).

Bảng 1. Trình bày dưới dạng bảng về điểm chất lượng của từng tập dữ liệu được tạo trên mỗi mô hình

Bảo hiểm dữ liệu

Mô-đun Báo cáo Chẩn đoán của SDV khiến chúng tôi chú ý rằng dữ liệu do SDV tạo ra (trong mọi trường hợp) bị thiếu hơn 10% phạm vi số; Trong trường hợp Bộ mã hóa tự động biến đổi dựa trên bộ ba (TVAE), cùng một lượng dữ liệu phân loại cũng bị thiếu khi so sánh với tập dữ liệu gốc. Không có cảnh báo nào như vậy được tạo ra với kết quả đạt được khi sử dụng Syntho.

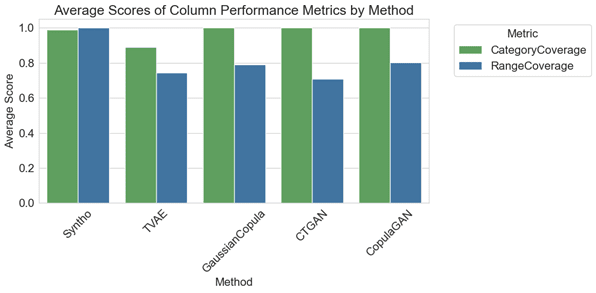

Hình 2. trực quan hóa các số liệu hiệu suất trung bình theo cột cho tất cả các mô hình

Trong phân tích so sánh, sơ đồ của Hình 2 minh họa rằng các kho lưu trữ SDV mang lại kết quả tốt hơn một chút trong phạm vi danh mục với một số mô hình của chúng (cụ thể là với GaussianCopula, CopulaGAN và GAN dạng bảng có điều kiện – CTGAN). Tuy nhiên, điều quan trọng cần nhấn mạnh là độ tin cậy của dữ liệu Syntho vượt trội so với các mẫu SDV, vì sự khác biệt về phạm vi bao phủ giữa các danh mục và phạm vi là rất nhỏ, chỉ chênh lệch 1.1%. Ngược lại, các mô hình SDV thể hiện sự thay đổi đáng kể, dao động từ 14.6% đến 29.2%.

Các số liệu được trình bày ở đây có thể được hiểu như sau:

- Phạm vi danh mục: Đo lường sự hiện diện của tất cả các danh mục trong dữ liệu tổng hợp so với dữ liệu thực.

- Phạm vi bao phủ: Đánh giá mức độ phù hợp của phạm vi giá trị trong dữ liệu tổng hợp với dữ liệu thực.

Bảng 2. Biểu diễn dưới dạng bảng về mức độ bao phủ trung bình của một loại thuộc tính nhất định trên mỗi mô hình

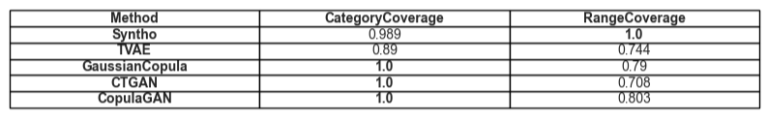

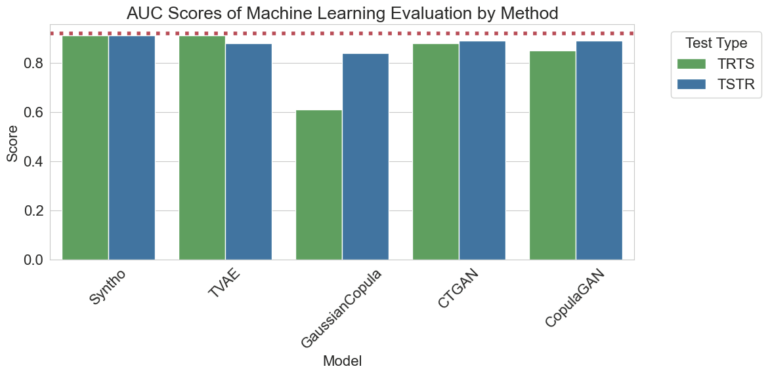

Tiện ích

Chuyển sang chủ đề về tiện ích của dữ liệu tổng hợp, vấn đề đào tạo các mô hình trên dữ liệu trở nên phù hợp. Để có sự so sánh cân bằng và công bằng giữa tất cả các khung, chúng tôi đã chọn Trình phân loại tăng cường độ dốc mặc định từ thư viện SciKit Learn, vì nó được chấp nhận khá nhiều như một mô hình hoạt động tốt với các cài đặt sẵn dùng.

Hai mô hình khác nhau được huấn luyện, một trên dữ liệu tổng hợp (đối với TSTR) và một trên dữ liệu gốc (đối với TRTS). Mô hình được đào tạo trên dữ liệu tổng hợp được đánh giá bằng cách sử dụng bộ kiểm tra loại trừ (không được sử dụng trong quá trình tạo dữ liệu tổng hợp) và mô hình được đào tạo trên dữ liệu gốc được kiểm tra trên tập dữ liệu tổng hợp.

Hình 3. Trực quan hóa điểm số Khu vực dưới đường cong (AUC) theo phương pháp trên mỗi mô hình

Các kết quả được hiển thị ở trên chứng minh tính ưu việt của việc tạo dữ liệu Tổng hợp bằng công cụ Syntho so với các phương pháp khác, thấy rằng không có sự khác biệt giữa các kết quả thu được bằng các phương pháp khác nhau (chỉ ra độ tương đồng cao giữa dữ liệu tổng hợp và dữ liệu thực). Ngoài ra, đường chấm màu đỏ hiện diện trong biểu đồ là kết quả thu được bằng cách đánh giá hiệu suất cơ bản của bài kiểm tra Train Real, Test Real (TRTR) để cung cấp đường cơ sở cho các số liệu được quan sát. Dòng này biểu thị giá trị 0.92, là điểm Khu vực dưới đường cong (điểm AUC) đạt được nhờ mô hình được huấn luyện trên dữ liệu thực và được kiểm tra trên dữ liệu thực.

Bảng 3. Biểu diễn dưới dạng bảng về điểm AUC mà TRTS và TSTR đạt được tương ứng trên mỗi mô hình.

So sánh theo thời gian

Đương nhiên, điều quan trọng là phải xem xét thời gian đầu tư để tạo ra những kết quả này. Hình ảnh trực quan dưới đây chỉ minh họa điều này.

Hình 5. Trực quan hóa thời gian đào tạo và biểu diễn tạo dữ liệu tổng hợp trong số một triệu điểm dữ liệu với mô hình có và không có GPU.

Hình 5 minh họa thời gian cần thiết để tạo dữ liệu tổng hợp ở hai cài đặt khác nhau. Đầu tiên trong số đó (ở đây được gọi là Không có GPU), là các lần chạy thử nghiệm chạy trên hệ thống có CPU Intel Xeon với 16 lõi chạy ở tốc độ 2.20 GHz. Các thử nghiệm được đánh dấu là “chạy bằng GPU” được thực hiện trên hệ thống có CPU AMD Ryze 9 7945HX với 16 lõi chạy ở tốc độ 2.5 GHz và GPU máy tính xách tay NVIDIA GeForce RTX 4070. Như đáng chú ý trong Hình 2 và Bảng 2 bên dưới, có thể thấy rằng Syntho nhanh hơn đáng kể trong việc tạo dữ liệu tổng hợp (trong cả hai trường hợp), điều này rất quan trọng trong quy trình làm việc động.

Bảng 5. Bảng biểu diễn thời gian thực hiện tạo dữ liệu tổng hợp trong số một triệu điểm dữ liệu với mỗi mô hình có và không có GPU

Những phát hiện này nhấn mạnh tầm quan trọng của việc đánh giá chất lượng kỹ lưỡng trong việc lựa chọn phương pháp tạo dữ liệu tổng hợp phù hợp. Syntho's Engine, với cách tiếp cận dựa trên AI, thể hiện những điểm mạnh đáng chú ý ở một số số liệu nhất định, trong khi các công cụ nguồn mở như SDV tỏa sáng ở tính linh hoạt và những cải tiến hướng đến cộng đồng.

Khi lĩnh vực dữ liệu tổng hợp tiếp tục phát triển, chúng tôi khuyến khích bạn áp dụng các số liệu này trong dự án của mình, khám phá những điểm phức tạp của chúng và chia sẻ kinh nghiệm của bạn. Hãy theo dõi các bài đăng trong tương lai, nơi chúng tôi sẽ đi sâu hơn vào các số liệu khác và nêu bật các ví dụ thực tế về ứng dụng của chúng.

Cuối cùng, đối với những người muốn thử nghiệm dữ liệu tổng hợp, giải pháp thay thế nguồn mở được trình bày có thể là một lựa chọn chính đáng với khả năng tiếp cận; tuy nhiên, đối với các chuyên gia kết hợp công nghệ hiện đại này vào quá trình phát triển của họ, mọi cơ hội cải tiến đều phải được tận dụng và tránh mọi trở ngại. Do đó, điều quan trọng là chọn tùy chọn tốt nhất hiện có. Với những phân tích được cung cấp ở trên, có thể thấy khá rõ ràng rằng Syntho và Syntho Engine là một công cụ rất hữu ích dành cho những người thực hành.

Về Syntho

tổng hợp cung cấp nền tảng tạo dữ liệu tổng hợp thông minh, tận dụng nhiều dạng dữ liệu tổng hợp và phương pháp tạo, trao quyền cho các tổ chức chuyển đổi dữ liệu một cách thông minh thành lợi thế cạnh tranh. Dữ liệu tổng hợp do AI tạo ra của chúng tôi mô phỏng các mẫu thống kê của dữ liệu gốc, đảm bảo độ chính xác, quyền riêng tư và tốc độ, theo đánh giá của các chuyên gia bên ngoài như SAS. Với các tính năng khử nhận dạng thông minh và ánh xạ nhất quán, thông tin nhạy cảm được bảo vệ trong khi vẫn duy trì tính toàn vẹn tham chiếu. Nền tảng của chúng tôi cho phép tạo, quản lý và kiểm soát dữ liệu thử nghiệm cho các môi trường phi sản xuất, sử dụng các phương pháp tạo dữ liệu tổng hợp dựa trên quy tắc cho các kịch bản được nhắm mục tiêu. Ngoài ra, người dùng có thể tạo dữ liệu tổng hợp theo chương trình và lấy dữ liệu thử nghiệm thực tế để phát triển các kịch bản phát triển và thử nghiệm toàn diện một cách dễ dàng.

Bạn có muốn tìm hiểu thêm các ứng dụng thực tế của dữ liệu tổng hợp không? Thoải mái để lên lịch demo!

Giới thiệu về tác giả

Thực tập sinh Kỹ thuật phần mềm

Nguyênam là sinh viên cử nhân tại Đại học Công nghệ Delft và là Thực tập sinh Kỹ thuật Phần mềm tại tổng hợp.

Kỹ sư học máy

Mihai đạt được bằng Tiến sĩ từ Đại học Bristol về chủ đề Học tăng cường theo cấp bậc áp dụng cho Robotics và là một Kỹ sư học máy at tổng hợp.

Lưu hướng dẫn dữ liệu tổng hợp của bạn ngay bây giờ!

- Dữ liệu tổng hợp là gì?

- Tại sao các tổ chức sử dụng nó?

- Giá trị thêm các trường hợp khách hàng dữ liệu tổng hợp

- Bắt đầu như thế nào