Gabay sa Pagbuo ng Synthetic na Data: Kahulugan, Mga Uri, at Aplikasyon

Hindi lihim na nahaharap ang mga negosyo sa mga hamon sa pagkuha at pagbabahagi ng mataas na kalidad na data. Sintetikong pagbuo ng data ay isang praktikal na solusyon na tumutulong sa paggawa ng malalaking artipisyal na dataset at mataas na kalidad na data ng pagsubok nang walang mga panganib sa privacy o red tape.

Maaaring malikha ang mga sintetikong dataset gamit ang iba't ibang pamamaraan, na nag-aalok ng magkakaibang mga aplikasyon. Kapag nasuri nang maayos, ang mga synthetic na dataset na nabuo gamit ang mga advanced na algorithm ay nakakatulong sa mga organisasyon na pabilisin ang kanilang analytics, pananaliksik, at pagsubok. Kaya't tingnan natin nang maigi.

Ipinapakilala sa iyo ng artikulong ito ang synthetic na data, kabilang ang mga pangunahing uri, mga pagkakaiba sa mga hindi kilalang dataset, at mga pagbabago sa regulasyon. Matututuhan mo kung paano nalulutas ng artipisyal na nabuong data ang mga kritikal na problema sa data at pinapaliit ang ilang partikular na panganib. Tatalakayin din namin ang mga aplikasyon nito sa mga industriya, na sinamahan ng mga halimbawa mula sa aming mga case study.

Talaan ng nilalaman

Sintetikong data: kahulugan at istatistika ng merkado

Data ng sintetiko ay artipisyal na nabuong impormasyon na walang kumpidensyal na nilalaman, at nagsisilbi itong alternatibo sa mga totoong dataset. Madalas tumatawag ang mga data scientist synthetic na data na binuo ng AI isang synthetic data twin dahil sa mataas na katumpakan ng istatistika sa paggaya ng totoong data.

Ginagawa ang mga artipisyal na dataset gamit ang mga algorithm at simulation ng artificial intelligence (AI) na nagpapanatili ng mga pattern at ugnayan ng orihinal na data. Maaaring kabilang sa data na ito ang teksto, mga talahanayan, at mga larawan. Pinapalitan ng mga algorithm ang personally identifiable information (PII) ng kunwaring datos.

Mga pagtataya sa Grand View Research na ang merkado para sa synthetic data generation na may Generative AI lalago mula $1.63 bilyon sa 2022 hanggang sa humigit-kumulang $13.5 bilyon sa 2030 sa isang CAGR na 35%. Ayon kay Gartner, 60% ng data na ginamit para sa AI noong 2024 ay magiging synthetic — iyon ay 60 beses na mas mataas kaysa noong 2021.

Ang mga sintetikong platform ng data ay tumataas din. Inaasahan ng Market Statesville ang pandaigdigang synthetic data platform market na lalago mula $218 milyon noong 2022 hanggang $3.7 bilyon sa 2033.

Bakit tumataas ang artipisyal na data? Ang isang kadahilanan sa pagmamaneho ay ang kalayaan mula sa pangangasiwa ng regulasyon.

Kinokontrol ba ng mga batas sa privacy ang synthetic data na binuo ng AI?

Maraming US at EU seguridad at privacy ng data naaangkop ang mga regulasyon sa makikilalang personal na data.

Ngunit ang mga regulasyong iyon ay hindi nalalapat sa sintetikong data — Ang sintetikong data ay tinatrato nang katulad ng anonymized na data. Binubuo nila ang tinatawag na "core" ng iba pang mga legal na tuntunin.

Halimbawa, recital 26 ng GDPR nagsasabing nalalapat lang ang mga panuntunan sa proteksyon sa privacy sa data na nauugnay sa isang taong makikilala. Kung nabuo ang iyong sintetikong data upang hindi ito ma-trace pabalik sa mga makikilalang indibidwal, ito ay hindi kasama sa pangangasiwa ng regulasyon. Bukod sa pangangasiwa sa regulasyon, may iba pang mga hadlang sa paggamit ng totoong data na nagtutulak sa mga negosyo na bumuo ng sintetikong data.

Mga pangunahing hamon sa paggamit ng totoong data

Maraming kumpanya ang nahihirapang maghanap at gumamit ng may-katuturang, mataas na kalidad na data, lalo na sa sapat na halaga para sa pagsasanay ng algorithm ng AI. Kahit na nahanap nila ito, ang pagbabahagi o paggamit ng mga dataset ay maaaring maging mahirap dahil sa mga panganib sa privacy at mga isyu sa compatibility. Binabalangkas ng seksyong ito ang susi hinahamon ang sintetikong data maaaring malutas.

Ang mga panganib sa privacy ay humahadlang sa paggamit at pagbabahagi ng data

Ang mga regulasyon sa seguridad at privacy ng data, gaya ng GDPR at HIPAA, ay nagpapakilala ng mga burukratikong hadlang sa pagbabahagi at paggamit ng data. Sa mga industriya tulad ng pangangalagang pangkalusugan, kahit na ang pagbabahagi ng PII sa pagitan ng mga departamento sa loob ng iisang organisasyon ay maaaring magtagal dahil sa mga pagsusuri sa pamamahala. Ang pagbabahagi ng data sa mga panlabas na entity ay mas mahirap at nagdadala ng higit pang mga panganib sa seguridad.

Pananaliksik mula sa Mga Pananaw sa Negosyo ng Fortune kinikilala ang tumataas na mga panganib sa privacy bilang isang pangunahing katalista para sa pagpapatibay ng mga kasanayan sa synthetic na data. Kung mas maraming data ang iniimbak mo, mas nanganganib kang makompromiso ang privacy. Ayon kay ang 2023 IBM Security Cost ng isang Data Breach Report, ang average na halaga ng paglabag sa data sa US ay $9.48 milyon. Sa buong mundo, ang karaniwang gastos ay $4.45 milyon; ang mga kumpanyang may mas mababa sa 500 manggagawa ay nawawalan ng $3.31 milyon kada paglabag. At hindi iyon isinasaalang-alang ang pinsala sa reputasyon.

Mga kahirapan sa paghahanap ng mataas na kalidad na data

Isang survey na 2022 sa 500 mga propesyonal sa data ay nagsiwalat na 77% ng mga inhinyero, analyst, at data scientist ay nahaharap sa mga isyu sa kalidad ng data. Ayon sa ulat, ang kalidad ng data ay humahadlang sa pagganap sa pananalapi at pagiging produktibo ng isang kumpanya at ginagawang halos hindi makakamit ang isang holistic na pagtingin sa mga serbisyo nito.

Maaaring kulang ang mga kumpanya ng sapat na data mula sa mga partikular na demograpiko upang sanayin nang maayos ang kanilang mga machine learning (ML) na modelo. At ang mga dataset ay kadalasang naglalaman ng mga hindi pagkakapare-pareho, mga kamalian, at mga nawawalang halaga. Kung sanayin mo ang iyong mga platform ng AI gamit ang mga modelo ng pag-aaral ng makina sa mababang kalidad na data na kulang sa demograpikong pagkakaiba-iba, gagawa ito ng hindi tumpak, may kinikilingan na mga hula. Katulad nito, tulad ng anonymized na pagbuo ng data, ang mga hindi nilinis na algorithm ay maaaring makagawa ng hindi maaasahang mga artipisyal na dataset na makakaapekto sa resulta ng pagsusuri ng data.

Ang upsampling gamit ang synthetic na data ay maaaring mapahusay ang kalidad ng data sa pamamagitan ng pagtugon sa mga imbalances sa mga dataset. Tinitiyak nito na ang mga klase na kulang sa representasyon ay makakatanggap ng mas proporsyonal na representasyon at binabawasan ang bias. Ang isang mas matatag at kinatawang dataset ay nagbubunga ng pinahusay na mga resulta ng pagsusuri at pagsasanay sa modelo.

Mga hindi pagkakatugma ng dataset

Ang mga dataset na nagmula sa iba't ibang pinagmulan o sa loob ng mga multi-table database ay maaaring magpakilala ng mga hindi pagkakatugma, na lumilikha ng mga kumplikado sa pagproseso at pagsusuri ng data at humahadlang sa pagbabago.

Halimbawa, ang pagsasama-sama ng data sa pangangalagang pangkalusugan ay nagsasangkot ng mga electronic health record (EHRs), mga naisusuot, proprietary software, at mga third-party na tool. Ang bawat pinagmulan ay maaaring gumamit ng natatanging mga format ng data at mga sistema ng impormasyon, na humahantong sa mga pagkakaiba sa mga format ng data, istruktura, o mga yunit sa panahon ng pagsasama. Maaaring tugunan ng paggamit ng sintetikong data ang hamon na ito, na tinitiyak ang pagiging tugma at nagbibigay-daan bumuo ng data sa nais na format.

Hindi sapat ang anonymization

Hindi sapat ang mga diskarte sa pag-anonymize para malampasan ang mga panganib sa privacy o mga problema sa kalidad ng data. Bukod dito, ang pag-mask o pag-alis ng mga identifier ay maaaring magtanggal ng mga detalyeng kailangan para sa malalim na pagsusuri sa malalaking dataset.

Bukod dito, ang hindi nakikilalang data ay maaaring muling tukuyin at masubaybayan pabalik sa mga indibidwal. Ang mga nakakahamak na aktor ay maaaring gumamit ng advanced na analytics upang tumuklas ng mga pattern na nakabatay sa oras na nakompromiso ang hindi pagkakakilanlan ng tila hindi natukoy na data. Ang sintetikong data ay mas mataas kaysa sa hindi nakikilalang data sa bagay na iyon.

Hindi magkatulad anonymization, sintetikong data ay hindi nagbabago sa mga kasalukuyang dataset ngunit bumubuo ng bagong data na kahawig ng mga katangian at istraktura ng raw data, pinapanatili ang utility nito. Isa itong ganap na bagong dataset na walang personal na nakakapagpakilalang impormasyon.

Ngunit ito ay mas nuanced kaysa doon. Mayroong ilang mga uri ng sintetikong paraan ng pagbuo ng data.

Mga uri ng synthetic data generation

Paglikha ng sintetikong data nag-iiba-iba ang mga proseso batay sa uri ng data na kinakailangan. Kasama sa mga synthetic na uri ng data ang ganap na AI-generated, rule-based, at mock data — bawat isa ay nakakatugon sa ibang pangangailangan.

Ganap na AI-generated synthetic data

Ang uri ng sintetikong data ay binuo mula sa simula gamit ang mga ML algorithm. Ang modelo ng pag-aaral ng makina nakasakay sa tren aktwal na datos upang matutunan ang tungkol sa istruktura, pattern, at relasyon ng data. Pagkatapos, ginagamit ng Generative AI ang kaalamang ito upang makabuo ng bagong data na halos kapareho ng mga istatistikal na katangian ng orihinal (muli, habang ginagawa itong hindi matukoy).

Ang uri ng ganap na sintetikong data ay kapaki-pakinabang para sa pagsasanay ng modelo ng AI at sapat na mabuti upang magamit na parang ito ay totoong data. Ito ay lalong kapaki-pakinabang kapag hindi mo maibabahagi ang iyong mga dataset dahil sa mga kontrata sa privacy na kasunduan. Gayunpaman, upang makabuo ng synthetic na data, kailangan mo ng malaking halaga ng orihinal na data bilang panimulang punto para sa modelo ng pag-aaral ng makina pagsasanay.

Sintetikong mock data

ito sintetikong data uri ay tumutukoy sa artipisyal na nilikhang data na ginagaya ang istraktura at format ng totoong data ngunit hindi kinakailangang sumasalamin sa aktwal na impormasyon. Tinutulungan nito ang mga developer na matiyak na kakayanin ng kanilang mga application ang iba't ibang input at senaryo nang hindi gumagamit ng tunay, pribado, o sensitibong data at, higit sa lahat, nang hindi umaasa sa real-world na data. Ang kasanayang ito ay mahalaga para sa pagsubok ng functionality at pagpino ng mga software application sa isang kontrolado at secure na paraan.

Kailan ito gagamitin: Upang palitan ang mga direktang pagkakakilanlan (PII) o kapag kasalukuyan kang kulang sa data at mas gusto mong huwag mag-invest ng oras at lakas sa pagtukoy ng mga panuntunan. Karaniwang gumagamit ang mga developer ng mock data upang suriin ang functionality at hitsura ng mga application sa mga unang yugto ng pag-develop, na nagbibigay-daan sa kanila na tumukoy ng mga potensyal na isyu o mga bahid ng disenyo.

Kahit na ang mock data ay kulang sa pagiging tunay ng real-world na impormasyon, nananatili itong isang mahalagang tool para sa pagtiyak ng wastong paggana ng mga system at visual na representasyon bago ang aktwal na pagsasama ng data.

Tandaan: Ang sintetikong mocked data ay madalas na tinutukoy bilang 'pekeng data,' bagama't hindi namin inirerekumenda ang paggamit ng mga terminong ito nang palitan dahil maaaring magkaiba ang mga ito sa mga konotasyon.

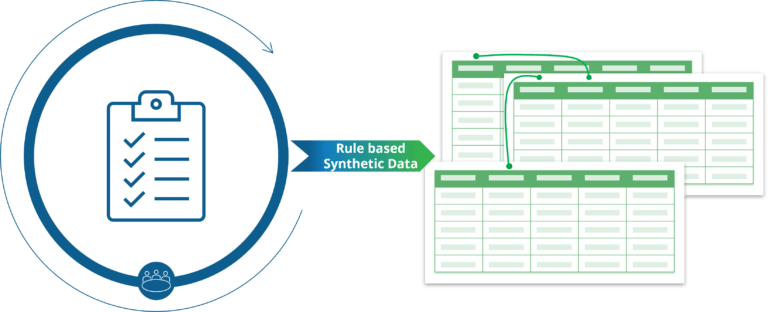

Sintetikong data na nakabatay sa panuntunan

Sintetikong data na nakabatay sa panuntunan ay isang kapaki-pakinabang na tool para sa pagbuo ng mga naka-customize na dataset batay sa mga paunang natukoy na panuntunan, mga hadlang, at lohika. Nagbibigay ang paraang ito ng flexibility sa pamamagitan ng pagpayag sa mga user na i-configure ang output ng data ayon sa mga partikular na pangangailangan ng negosyo, pagsasaayos ng mga parameter gaya ng minimum, maximum, at average na mga halaga. Kabaligtaran sa ganap na data na binuo ng AI, na walang pag-customize, nag-aalok ang synthetic data na nakabatay sa panuntunan ng isang iniangkop na solusyon para matugunan ang mga natatanging kinakailangan sa pagpapatakbo. Ito proseso ng pagbuo ng sintetikong data nagpapatunay na partikular na kapaki-pakinabang sa pagsubok, pagbuo, at analytics, kung saan ang tumpak at kontroladong pagbuo ng data ay mahalaga.

Ang bawat synthetic na paraan ng pagbuo ng data ay may iba't ibang mga aplikasyon. Ang platform ni Syntho ay namumukod-tangi sa pamamagitan ng paglikha ng synthetic data twins na may kaunti o walang pagsisikap sa iyong bahagi. Nakakakuha ka ng tumpak na istatistika, mataas na kalidad na sintetikong data para sa iyong mga pangangailangan na walang compliance overhead.

Tabular na sintetikong data

Ang terminong tabular na sintetikong data ay tumutukoy sa paglikha ng artipisyal na data mga subset na ginagaya ang istruktura at istatistikal na katangian ng totoong mundo hangganan ng data, gaya ng data na nakaimbak sa mga talahanayan o spreadsheet. Ito sintetikong data ay nilikha gamit ang sintetikong mga algorithm ng pagbuo ng data at mga pamamaraan na idinisenyo upang gayahin ang mga katangian ng pinagmumulan ng datos habang tinitiyak na kumpidensyal o sensitibong data ay hindi isiwalat.

Mga diskarte sa pagbuo tabular sintetikong data karaniwang may kinalaman sa statistical modelling, mga modelo ng pag-aaral ng makina, o mga generative na modelo tulad ng mga generative adversarial network (GAN) at variational autoencoders (VAEs). Ang mga ito mga tool sa pagbuo ng sintetikong data suriin ang mga pattern, distribusyon, at ugnayang naroroon sa totoong dataset at pagkatapos ay bumuo ng bago puntos ng data na malapit na kahawig ng totoong data ngunit hindi naglalaman ng anumang tunay na impormasyon.

Karaniwang tabular mga kaso ng paggamit ng sintetikong data isama ang pagtugon sa mga alalahanin sa privacy, pagtaas ng availability ng data, at pagpapadali sa pananaliksik at pagbabago sa mga application na batay sa data. Gayunpaman, ito ay mahalaga upang matiyak na ang sintetikong data tumpak na nakukuha ang pinagbabatayan na mga pattern at distribusyon ng orihinal na data upang mapanatili utility ng data at bisa para sa mga gawain sa ibaba ng agos.

Pinakatanyag na synthetic data application

Ang artipisyal na nabuong data ay nagbubukas ng mga posibilidad ng pagbabago para sa pangangalagang pangkalusugan, retail, pagmamanupaktura, pananalapi, at iba pang mga industriya. Ang pangunahin gamitin ang mga kaso isama ang data upsampling, analytics, pagsubok, at pagbabahagi.

Upsampling para mapahusay ang mga dataset

Ang ibig sabihin ng upsampling ay pagbuo ng mas malalaking dataset mula sa mas maliliit para sa scaling at diversification. Ang pamamaraang ito ay inilalapat kapag ang totoong data ay kakaunti, hindi balanse, o hindi kumpleto.

Isaalang-alang ang ilang halimbawa. Para sa mga institusyong pinansyal, mapapabuti ng mga developer ang katumpakan ng mga modelo ng pagtuklas ng panloloko sa pamamagitan ng pag-upsamp ng mga bihirang obserbasyon at mga pattern ng aktibidad sa datos na pinansyal. Sa katulad na paraan, maaaring mag-upsample ang isang ahensya sa marketing para dagdagan ang data na nauugnay sa mga grupong hindi gaanong kinakatawan, na magpapahusay sa katumpakan ng pagse-segment.

Advanced na analytics na may data na binuo ng AI

Maaaring gamitin ng mga kumpanya ang mataas na kalidad na synthetic data na binuo ng AI para sa pagmomodelo ng data, analytics ng negosyo, at klinikal na pananaliksik. Pag-synthesize ng data nagpapatunay na isang praktikal na alternatibo kapag ang pagkuha ng mga totoong dataset ay masyadong mahal o nakakaubos ng oras.

Data ng sintetiko binibigyang kapangyarihan ang mga mananaliksik na magsagawa ng mga malalim na pagsusuri nang hindi nakompromiso ang pagiging kumpidensyal ng pasyente. Data siyentipiko at ang mga mananaliksik ay nakakakuha ng access sa data ng pasyente, impormasyon tungkol sa mga klinikal na kondisyon, at mga detalye ng paggamot, na nakakakuha ng mga insight na mas makakaubos ng oras sa totoong data. Bukod dito, malayang makakapagbahagi ng data ang mga manufacturer sa mga supplier, na isinasama ang manipuladong GPS at data ng lokasyon upang lumikha ng mga algorithm para sa pagsubok sa pagganap o mapahusay ang predictive na pagpapanatili.

Gayunpaman, pagsusuri ng sintetikong data ay kritikal. Ang output ng Syntho Engine ay napatunayan ng isang panloob na pangkat ng pagtiyak ng kalidad at mga panlabas na eksperto mula sa SAS Institute. Sa isang pag-aaral ng predictive modeling, nagsanay kami ng apat mga modelo ng pag-aaral ng makina sa tunay, hindi nagpapakilala, at sintetikong data. Ipinakita ng mga resulta na ang mga modelong sinanay sa aming mga synthetic na dataset ay may parehong antas ng katumpakan gaya ng mga sinanay sa mga totoong dataset, habang binawasan ng hindi nakikilalang data ang utility ng mga modelo.

Panlabas at panloob na pagbabahagi ng data

Pinapasimple ng synthetic data ang pagbabahagi ng data sa loob at sa mga organisasyon. Kaya mo gumamit ng sintetikong data sa makipagpalitan ng impormasyon nang hindi nanganganib sa mga paglabag sa privacy o hindi pagsunod sa regulasyon. Kasama sa mga benepisyo ng synthetic na data ang pinabilis na resulta ng pananaliksik at mas epektibong pakikipagtulungan.

Maaaring magbahagi ng mga insight ang mga retail company sa mga supplier o distributor gamit ang synthetic na data na nagpapakita ng gawi ng customer, antas ng imbentaryo, o iba pang pangunahing sukatan. Gayunpaman, upang matiyak ang pinakamataas na antas ng Pagkalihim ng datos, ang sensitibong data ng customer, at mga lihim ng kumpanya ay pinananatiling kumpidensyal.

Nanalo si Syntho sa 2023 Global SAS Hackathon para sa ating kakayahang bumuo at magbahagi atumpak na sintetikong data mabisa at walang panganib. Nag-synthesize kami ng data ng pasyente para sa maraming ospital na may iba't ibang populasyon ng pasyente upang ipakita ang bisa ng mga predictive na modelo. Ang paggamit ng pinagsamang mga sintetikong dataset ay ipinakita na kasing tumpak ng paggamit ng totoong data.

Sintetikong data ng pagsubok

Ang synthetic na data ng pagsubok ay artipisyal na nabuong data na idinisenyo upang gayahin pagsubok ng datos kapaligiran para sa pagbuo ng software. Bilang karagdagan sa pagbabawas ng mga panganib sa privacy, binibigyang-daan ng synthetic na data ng pagsubok ang mga developer na masusing masuri ang performance, seguridad, at functionality ng mga application sa isang hanay ng mga potensyal na sitwasyon nang hindi naaapektuhan ang totoong system.

Ang aming pakikipagtulungan sa isa sa pinakamalaking Dutch banks showcases mga benepisyo ng sintetikong data para sa pagsubok ng software. Subukan ang pagbuo ng data gamit ang Syntho Engine ay nagresulta sa mga dataset na tulad ng produksyon na nakatulong sa bangko na pabilisin ang pagbuo ng software at pag-detect ng bug, na humahantong sa mas mabilis at mas secure na paglabas ng software.

Mga diskarte sa pagbuo tabular sintetikong data karaniwang may kinalaman sa statistical modelling, mga modelo ng pag-aaral ng makina, o mga generative na modelo tulad ng mga generative adversarial network (GAN) at variational autoencoders (VAEs). Ang mga ito mga tool sa pagbuo ng sintetikong data suriin ang mga pattern, distribusyon, at ugnayang naroroon sa totoong dataset at pagkatapos ay bumuo ng bago puntos ng data na malapit na kahawig ng totoong data ngunit hindi naglalaman ng anumang tunay na impormasyon.

Karaniwang tabular mga kaso ng paggamit ng sintetikong data isama ang pagtugon sa mga alalahanin sa privacy, pagtaas ng availability ng data, at pagpapadali sa pananaliksik at pagbabago sa mga application na batay sa data. Gayunpaman, ito ay mahalaga upang matiyak na ang sintetikong data tumpak na nakukuha ang pinagbabatayan na mga pattern at distribusyon ng orihinal na data upang mapanatili utility ng data at bisa para sa mga gawain sa ibaba ng agos.

Syntho's synthetic data generation platform

Nagbibigay ang Syntho ng isang matalinong synthetic na platform ng pagbuo ng data, na nagbibigay ng kapangyarihan sa mga organisasyon na matalinong baguhin ang data sa isang competitive edge. Sa pamamagitan ng pagbibigay ng lahat ng synthetic na paraan ng pagbuo ng data sa isang platform, nag-aalok ang Syntho ng komprehensibong solusyon para sa mga organisasyong naglalayong gamitin ang data na sumasaklaw sa:

- synthetic na data na binuo ng AI na ginagaya ang mga istatistikal na pattern ng orihinal na data sa synthetic na data na may kapangyarihan ng artificial intelligence.

- Smart de-identification upang protektahan sensitibong data sa pamamagitan ng pag-alis o pagbabago ng personal na pagkakakilanlan ng impormasyon (PII).

- Test data management na nagbibigay-daan sa paglikha, pagpapanatili, at kontrol ng kinatawan ng data ng pagsubok para sa mga kapaligiran na hindi produksyon.

Sumasama ang aming mga platform sa anumang cloud o on-premise na kapaligiran. Bukod dito, pinangangalagaan namin ang pagpaplano at pag-deploy. Sasanayin ng aming team ang iyong mga empleyado na gumamit Syntho Engine epektibo, at magbibigay kami ng tuluy-tuloy na suporta pagkatapos ng pag-deploy.

Maaari kang magbasa nang higit pa tungkol sa mga kakayahan ng Syntho's sintetikong data platform ng henerasyon sa Seksyon ng mga solusyon sa aming website.

Ano ang hinaharap para sa synthetic na data?

Sintetikong pagbuo ng data na may generative AI tumutulong sa paglikha at pagbabahagi ng mataas na volume ng nauugnay na data, pag-bypass sa mga isyu sa compatibility ng format, mga hadlang sa regulasyon, at ang panganib ng mga paglabag sa data.

Hindi tulad ng anonymization, pagbuo ng sintetikong data nagbibigay-daan para sa pagpapanatili ng mga istrukturang relasyon sa data. Ginagawa nitong angkop ang sintetikong data para sa advanced na analytics, pananaliksik at pagpapaunlad, sari-saring uri, at pagsubok.

Ang paggamit ng mga sintetikong dataset ay lalawak lamang sa mga industriya. Nakahanda na ang mga kumpanya lumikha ng sintetikong data, pagpapalawak ng saklaw nito sa mga kumplikadong larawan, audio, at nilalamang video. Palalawakin ng mga kumpanya ang paggamit ng mga modelo ng pag-aaral ng makina sa mas advanced na mga simulation at mga application.

Gusto mo bang matuto ng higit pang praktikal na aplikasyon ng sintetikong data? Huwag mag-atubiling mag-iskedyul ng demo sa aming website.

Tungkol kay Syntho

Syntho nagbibigay ng matalino paggawa ng sintetikong data platform, paggamit maramihang synthetic data form at mga pamamaraan ng henerasyon, na nagbibigay-kapangyarihan sa mga organisasyon na matalinong ibahin ang anyo ng data sa isang competitive edge. Ginagaya ng aming synthetic na data na binuo ng AI ang mga pattern ng istatistika ng orihinal na data, na tinitiyak ang katumpakan, privacy, at bilis, ayon sa pagtatasa ng mga external na eksperto tulad ng SAS. Sa pamamagitan ng matalinong pag-de-identification na mga feature at pare-parehong pagmamapa, pinoprotektahan ang sensitibong impormasyon habang pinapanatili ang integridad ng referential. Ang aming platform ay nagbibigay-daan sa paglikha, pamamahala, at kontrol ng data ng pagsubok para sa mga kapaligiran na hindi produksyon, gamit ang nakabatay sa panuntunan sintetikong paraan ng pagbuo ng data para sa mga naka-target na senaryo. Bilang karagdagan, ang mga gumagamit ay maaaring bumuo ng sintetikong data sa pamamagitan ng program at makuha makatotohanang data ng pagsubok upang bumuo ng komprehensibong pagsubok at mga senaryo ng pag-unlad nang madali.

Tungkol sa Author

Wim Kees Janssen

CEO at tagapagtatag

Syntho, ang scale-up na nakakagambala sa industriya ng data gamit ang AI-generated synthetic data. Napatunayan ni Wim Kees kasama si Syntho na maaari niyang i-unlock ang data na sensitibo sa privacy upang gawing mas matalino at mas mabilis na magagamit ang data upang maisakatuparan ng mga organisasyon ang inobasyon na hinihimok ng data. Bilang resulta, nanalo sina Wim Kees at Syntho ng prestihiyosong Philips Innovation Award, nanalo sa SAS global hackathon sa healthcare at life science, at napili bilang nangungunang generative AI Scale-Up ng NVIDIA.