AI-generated Synthetic Data, madali at mabilis na pag-access sa mataas na kalidad na data?

Nakabuo ang AI ng sintetikong data sa pagsasanay

Nilalayon ni Syntho, isang eksperto sa synthetic data na binuo ng AI, na lumiko privacy by design sa isang mapagkumpitensyang kalamangan sa AI-generated synthetic data. Tinutulungan nila ang mga organisasyon na bumuo ng matibay na pundasyon ng data na may madali at mabilis na pag-access sa mataas na kalidad na data at kamakailan ay nanalo ng Philips Innovation Award.

Gayunpaman, ang pagbuo ng synthetic na data na may AI ay isang medyo bagong solusyon na karaniwang nagpapakilala ng mga madalas itanong. Para masagot ang mga ito, nagsimula si Syntho ng case-study kasama ang SAS, market leader sa Advanced Analytics at AI software.

Sa pakikipagtulungan sa Dutch AI Coalition (NL AIC), inimbestigahan nila ang halaga ng synthetic data sa pamamagitan ng paghahambing ng AI-generated synthetic data na nabuo ng Syntho Engine sa orihinal na data sa pamamagitan ng iba't ibang assessment sa kalidad ng data, legal na validity at usability.

Hindi ba solusyon ang data anonymization?

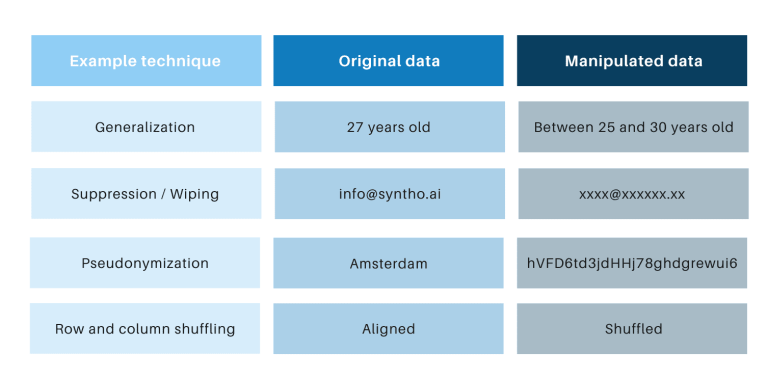

Ang mga klasikong diskarte sa pag-anonymize ay may pagkakatulad na minamanipula ng mga ito ang orihinal na data upang hadlangan ang pagsubaybay sa likod ng mga indibidwal. Ang mga halimbawa ay generalization, suppression, wiping, pseudonymization, data masking, at shuffling ng mga row at column. Makakakita ka ng mga halimbawa sa talahanayan sa ibaba.

Ang mga diskarteng iyon ay nagpapakilala ng 3 pangunahing hamon:

- Magkaiba ang mga ito sa bawat uri ng data at bawat dataset, na ginagawang mahirap sukatin ang mga ito. Higit pa rito, dahil magkaiba ang kanilang trabaho, palaging magkakaroon ng debate tungkol sa kung aling mga pamamaraan ang ilalapat at kung anong kumbinasyon ng mga diskarte ang kailangan.

- Palaging may isa-sa-isang ugnayan sa orihinal na data. Nangangahulugan ito na palaging magkakaroon ng panganib sa privacy, lalo na dahil sa lahat ng bukas na dataset at available na mga diskarte para i-link ang mga dataset na iyon.

- Minamanipula nila ang data at sa gayon ay sinisira ang data sa proseso. Lalo itong nakakasira para sa mga gawain ng AI kung saan mahalaga ang "predictive power", dahil ang hindi magandang kalidad ng data ay magreresulta sa hindi magandang insight mula sa AI model (Ang pagpasok ng basura ay magreresulta sa paglabas ng basura).

Ang mga puntong ito ay tinasa rin sa pamamagitan ng case study na ito.

Isang panimula sa case study

Para sa case study, ang target na dataset ay isang telecom dataset na ibinigay ng SAS na naglalaman ng data ng 56.600 na customer. Naglalaman ang dataset ng 128 column, kabilang ang isang column na nagsasaad kung umalis ang isang customer sa kumpanya (ibig sabihin, 'na-churn') o hindi. Ang layunin ng case study ay gamitin ang sintetikong data para sanayin ang ilang modelo para mahulaan ang customer churn at suriin ang performance ng mga sinanay na modelong iyon. Dahil ang hula sa churn ay isang gawain sa pag-uuri, pumili ang SAS ng apat na sikat na modelo ng pag-uuri upang gawin ang mga hula, kabilang ang:

- Random na kagubatan

- Pagpapalakas ng gradient

- Logistic regression

- Neural network

Bago bumuo ng sintetikong data, random na hinati ng SAS ang dataset ng telecom sa isang set ng tren (para sa pagsasanay ng mga modelo) at isang hanay ng holdout (para sa pagmamarka ng mga modelo). Ang pagkakaroon ng hiwalay na hanay ng holdout para sa pagmamarka ay nagbibigay-daan para sa isang walang pinapanigan na pagtatasa kung gaano kahusay ang maaaring gumanap ng modelo ng pag-uuri kapag inilapat sa bagong data.

Gamit ang set ng tren bilang input, ginamit ng Syntho ang Syntho Engine nito para bumuo ng synthetic na dataset. Para sa benchmarking, gumawa din ang SAS ng manipuladong bersyon ng set ng tren pagkatapos maglapat ng iba't ibang mga diskarte sa pag-anonymize upang maabot ang isang partikular na threshold (ng k-anonimity). Ang mga dating hakbang ay nagresulta sa apat na dataset:

- Isang dataset ng tren (ibig sabihin, ang orihinal na dataset na binawasan ang holdout dataset)

- Isang holdout na dataset (ibig sabihin, isang subset ng orihinal na dataset)

- Isang hindi kilalang dataset (batay sa dataset ng tren)

- Isang sintetikong dataset (batay sa dataset ng tren)

Ang mga dataset 1, 3 at 4 ay ginamit upang sanayin ang bawat modelo ng pag-uuri, na nagresulta sa 12 (3 x 4) na sinanay na mga modelo. Pagkatapos, ginamit ng SAS ang holdout dataset upang sukatin ang katumpakan kung saan hinuhulaan ng bawat modelo ang pag-churn ng customer. Ang mga resulta ay ipinakita sa ibaba, na nagsisimula sa ilang mga pangunahing istatistika.

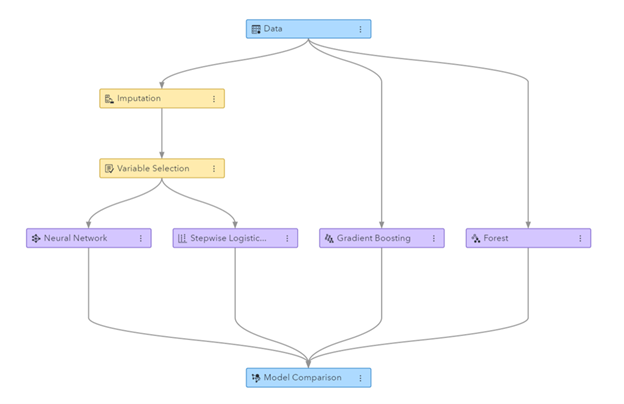

Figure: Machine Learning pipeline na nabuo sa SAS Visual Data Mining at Machine Learning

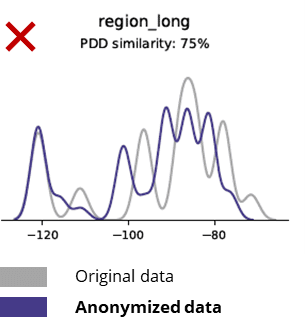

Mga pangunahing istatistika kapag inihahambing ang hindi nakikilalang data sa orihinal na data

Sinisira ng mga diskarte sa anonymization kahit ang mga pangunahing pattern, lohika ng negosyo, mga relasyon at istatistika (tulad ng sa halimbawa sa ibaba). Ang paggamit ng hindi nakikilalang data para sa pangunahing analytics ay nagbubunga ng hindi mapagkakatiwalaang mga resulta. Sa katunayan, ang mahinang kalidad ng hindi nakikilalang data ay naging halos imposibleng gamitin ito para sa mga advanced na gawain sa analytics (hal. AI/ML modelling at dashboarding).

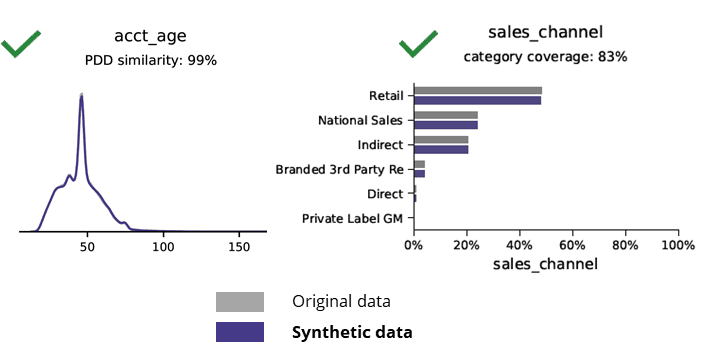

Mga pangunahing istatistika kapag inihambing ang synthetic na data sa orihinal na data

Ang pagbuo ng sintetikong data na may AI ay nagpapanatili ng mga pangunahing pattern, lohika ng negosyo, mga relasyon at istatistika (tulad ng sa halimbawa sa ibaba). Ang paggamit ng sintetikong data para sa pangunahing analytics ay nagbibigay ng maaasahang mga resulta. Pangunahing tanong, mayroon ba ang synthetic na data para sa mga advanced na gawain sa analytics (hal. AI/ML modelling at dashboarding)?

Sintetikong data na binuo ng AI at advanced na analytics

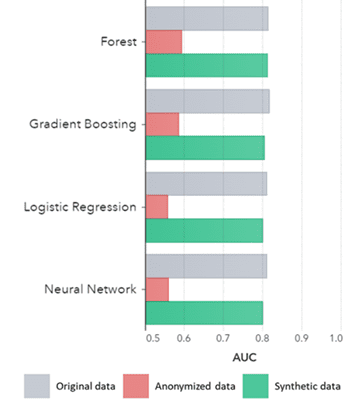

Ang sintetikong data ay nagtataglay hindi lamang para sa mga pangunahing pattern (tulad ng ipinapakita sa mga dating plot), nakukuha din nito ang malalim na 'nakatagong' mga pattern ng istatistika na kinakailangan para sa mga advanced na gawain sa analytics. Ang huli ay ipinapakita sa bar chart sa ibaba, na nagsasaad na ang katumpakan ng mga modelong sinanay sa sintetikong data kumpara sa mga modelong sinanay sa orihinal na data ay magkatulad. Higit pa rito, sa isang lugar sa ilalim ng curve (AUC*) na malapit sa 0.5, ang mga modelong sinanay sa hindi nakikilalang data ay gumaganap ng pinakamasama. Ang buong ulat kasama ang lahat ng advanced na pagsusuri sa analytics sa synthetic na data kumpara sa orihinal na data ay available kapag hiniling.

*AUC: ang lugar sa ilalim ng curve ay isang sukatan para sa katumpakan ng mga advanced na modelo ng analytics, na isinasaalang-alang ang mga true positive, false positive, false negative at true negative. Ang 0,5 ay nangangahulugan na ang isang modelo ay nanghuhula nang random at walang predictive na kapangyarihan at ang 1 ay nangangahulugan na ang modelo ay palaging tama at may ganap na predictive na kapangyarihan.

Bilang karagdagan, ang synthetic na data na ito ay maaaring gamitin upang maunawaan ang mga katangian ng data at mga pangunahing variable na kailangan para sa aktwal na pagsasanay ng mga modelo. Ang mga input na pinili ng mga algorithm sa sintetikong data kumpara sa orihinal na data ay halos magkapareho. Kaya, ang proseso ng pagmomodelo ay maaaring gawin sa sintetikong bersyong ito, na binabawasan ang panganib ng mga paglabag sa data. Gayunpaman, kapag naghihinuha ng mga indibidwal na rekord (hal. customer ng telco) ang muling pagsasanay sa orihinal na data ay inirerekomenda para sa pagpapaliwanag, pagtaas ng pagtanggap o dahil lamang sa regulasyon.

AUC ayon sa Algorithm na nakapangkat ayon sa Paraan

Konklusyon:

- Ang mga modelong sinanay sa synthetic na data kumpara sa mga modelong sinanay sa orihinal na data ay nagpapakita ng lubos na katulad na pagganap

- Ang mga modelong sinanay sa anonymized na data na may 'classic na mga diskarte sa anonymization' ay nagpapakita ng mas mababang performance kumpara sa mga modelong sinanay sa orihinal na data o synthetic na data

- Madali at mabilis ang pagbuo ng sintetikong data dahil eksaktong pareho ang pamamaraan sa bawat dataset at bawat uri ng data.

Mga kaso ng paggamit ng data ng synthetic na pagdaragdag ng halaga

Gamitin ang kaso 1: Synthetic na data para sa pagbuo ng modelo at advanced na analytics

Ang pagkakaroon ng matibay na pundasyon ng data na may madali at mabilis na pag-access sa magagamit, mataas na kalidad na data ay mahalaga upang bumuo ng mga modelo (hal. mga dashboard [BI] at advanced na analytics [AI at ML]). Gayunpaman, maraming organisasyon ang dumaranas ng suboptimal na data foundation na nagreresulta sa 3 pangunahing hamon:

- Ang pag-access sa data ay tumatagal ng edad dahil sa mga regulasyon (privacy), panloob na proseso o mga data silo

- Sinisira ng mga klasikong diskarte sa anonymization ang data, na ginagawang hindi na angkop ang data para sa pagsusuri at advanced na analytics (garbage in = garbage out)

- Ang mga kasalukuyang solusyon ay hindi nasusukat dahil naiiba ang kanilang gumagana sa bawat dataset at sa bawat uri ng data at hindi kayang humawak ng malalaking multi-table database

Sintetikong diskarte sa data: bumuo ng mga modelong may as-good-as-real synthetic data para:

- I-minimize ang paggamit ng orihinal na data, nang hindi hadlangan ang iyong mga developer

- I-unlock ang personal na data at magkaroon ng access sa mas maraming data na dating pinaghigpitan (hal. Dahil sa privacy)

- Madali at mabilis na pag-access ng data sa nauugnay na data

- Nasusukat na solusyon na gumagana nang pareho para sa bawat dataset, datatype at para sa napakalaking mga database

Nagbibigay-daan ito sa organisasyon na bumuo ng isang matibay na pundasyon ng data na may madali at mabilis na pag-access sa magagamit, mataas na kalidad ng data upang i-unlock ang data at upang magamit ang mga pagkakataon sa data.

Use case 2: smart synthetic test data para sa software testing, development at delivery

Ang pagsubok at pagpapaunlad na may mataas na kalidad na data ng pagsubok ay mahalaga upang makapaghatid ng mga makabagong solusyon sa software. Ang paggamit ng orihinal na data ng produksyon ay mukhang halata, ngunit hindi pinapayagan dahil sa (privacy) na mga regulasyon. Alternatibo Test Data Management (TDM) na mga tool ay nagpapakilala ng "legacy-by-design” sa pagkuha ng tama ng data ng pagsubok:

- Huwag ipakita ang data ng produksyon at ang lohika ng negosyo at integridad ng referential ay hindi napanatili

- Mabagal ang trabaho at nakakaubos ng oras

- Kinakailangan ang manu-manong gawain

Sintetikong diskarte sa data: Subukan at bumuo gamit ang synthetic na data ng pagsubok na binuo ng AI upang makapaghatid ng mga makabagong solusyon sa software na matalino sa:

- Data na parang produksyon na may pinapanatili na lohika ng negosyo at integridad ng referential

- Madali at mabilis na pagbuo ng data na may state-of-the art AI

- Privacy-by-design

- Madali, mabilis at agile

Nagbibigay-daan ito sa organisasyon na subukan at bumuo ng data ng pagsubok sa susunod na antas upang makapaghatid ng mga makabagong solusyon sa software!

Karagdagang impormasyon

Interesado? Para sa higit pang impormasyon tungkol sa synthetic data, bisitahin ang Syntho website o makipag-ugnayan kay Wim Kees Janssen. Para sa karagdagang impormasyon tungkol sa SAS, bisitahin ang www.sas.com o makipag-ugnayan sa kees@syntho.ai.

Sa ganitong kaso ng paggamit, nagtutulungan ang Syntho, SAS at ang NL AIC upang makamit ang mga inaasahang resulta. Si Syntho ay isang dalubhasa sa AI-generated synthetic data at ang SAS ay isang market leader sa analytics at nag-aalok ng software para sa paggalugad, pagsusuri at pag-visualize ng data.

* Mga Hula sa 2021 – Mga Istratehiya ng Data at Analytics upang Pamahalaan, Palakihin at Ibahin ang Digital na Negosyo, Gartner, 2020.

I-save ang iyong synthetic data guide ngayon!

- Ano ang synthetic data?

- Bakit ginagamit ito ng mga organisasyon?

- Pagdaragdag ng halaga ng mga kaso ng kliyente ng synthetic data

- Paano magsimula?