ხელოვნური ინტელექტის მიერ გენერირებული სინთეტიკური მონაცემები, მარტივი და სწრაფი წვდომა მაღალი ხარისხის მონაცემებზე?

ხელოვნური ინტელექტი პრაქტიკაში წარმოქმნიდა სინთეზურ მონაცემებს

Syntho, AI-ის მიერ გენერირებული სინთეზური მონაცემების ექსპერტი, მიზნად ისახავს შემობრუნებას privacy by design კონკურენტულ უპირატესობად AI-ით გენერირებული სინთეზური მონაცემებით. ისინი ეხმარებიან ორგანიზაციებს შექმნან მონაცემთა ძლიერი საფუძველი მაღალი ხარისხის მონაცემებზე მარტივი და სწრაფი წვდომით და ახლახან მოიგეს Philips Innovation Award.

თუმცა, ხელოვნური ინტელექტის გამოყენებით სინთეზური მონაცემების გენერირება შედარებით ახალი გამოსავალია, რომელიც ჩვეულებრივ აწვდის ხშირად დასმულ კითხვებს. ამაზე პასუხის გასაცემად, Syntho-მ დაიწყო საქმის შესწავლა SAS-თან ერთად, ბაზრის ლიდერი Advanced Analytics და AI პროგრამული უზრუნველყოფაში.

ჰოლანდიურ AI კოალიციასთან (NL AIC) თანამშრომლობით, მათ გამოიკვლიეს სინთეზური მონაცემების ღირებულება Syntho Engine-ის მიერ გენერირებული AI-ს მიერ გენერირებული სინთეტიკური მონაცემების შედარებით ორიგინალურ მონაცემებთან მონაცემთა ხარისხის, იურიდიული ვალიდობისა და გამოყენებადობის სხვადასხვა შეფასებების მეშვეობით.

მონაცემთა ანონიმიზაცია არ არის გამოსავალი?

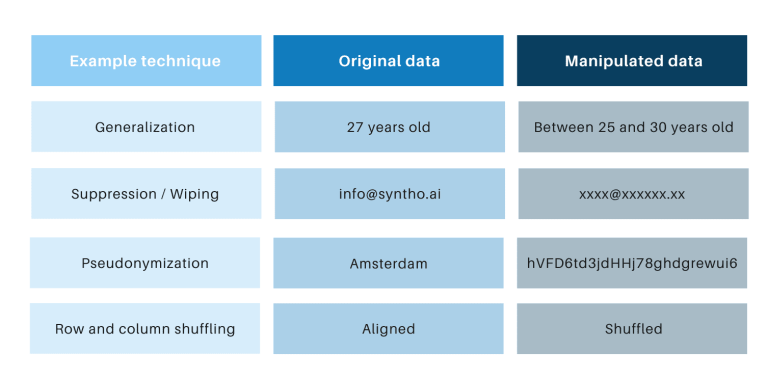

კლასიკური ანონიმიზაციის ტექნიკას აქვს საერთო ის, რომ ისინი მანიპულირებენ ორიგინალურ მონაცემებს, რათა ხელი შეუშალონ პიროვნების უკან დახევას. მაგალითებია განზოგადება, ჩახშობა, წაშლა, ფსევდონიმიზაცია, მონაცემთა შენიღბვა და რიგებისა და სვეტების არევა. მაგალითები შეგიძლიათ იხილოთ ქვემოთ მოცემულ ცხრილში.

ეს ტექნიკა წარმოგიდგენთ 3 ძირითად გამოწვევას:

- ისინი განსხვავებულად მუშაობენ მონაცემთა ტიპისა და მონაცემთა მიხედვით, რაც ართულებს მათ მასშტაბირებას. გარდა ამისა, ვინაიდან ისინი განსხვავებულად მუშაობენ, ყოველთვის იქნება დებატები იმის შესახებ, თუ რომელი მეთოდების გამოყენება და ტექნიკის რა კომბინაციაა საჭირო.

- თავდაპირველ მონაცემებთან ყოველთვის არის ერთი-ერთზე ურთიერთობა. ეს ნიშნავს, რომ ყოველთვის იქნება კონფიდენციალურობის რისკი, განსაკუთრებით ყველა ღია მონაცემთა ნაკრებისა და ამ მონაცემთა ნაკრების დასაკავშირებლად არსებული ტექნიკის გამო.

- ისინი მანიპულირებენ მონაცემებს და ამით ანადგურებენ მონაცემებს პროცესში. ეს განსაკუთრებით დამღუპველია ხელოვნური ინტელექტის მქონე ამოცანებისთვის, სადაც „პროგნოზირებადი ძალა“ აუცილებელია, რადგან ცუდი ხარისხის მონაცემები გამოიწვევს AI მოდელის ცუდ შეხედულებებს (Garbage-in გამოიწვევს ნაგვის გამოდევნას).

ეს პუნქტები ასევე შეფასებულია ამ საქმის შესწავლით.

შესავალი საქმის შესწავლაში

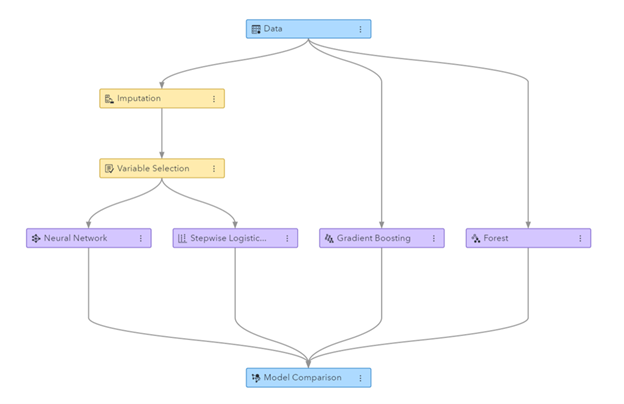

შემთხვევის შესწავლისთვის, სამიზნე მონაცემთა ბაზა იყო ტელეკომის მონაცემთა ბაზა, რომელიც მოწოდებული იყო SAS-ის მიერ, რომელიც შეიცავდა 56.600 მომხმარებლის მონაცემებს. მონაცემთა ნაკრები შეიცავს 128 სვეტს, მათ შორის ერთი სვეტი, რომელიც მიუთითებს, დატოვა თუ არა მომხმარებელმა კომპანია (ე.ი. „გადაძარცვა“) თუ არა. შემთხვევის შესწავლის მიზანი იყო სინთეზური მონაცემების გამოყენება ზოგიერთი მოდელის მოსამზადებლად მომხმარებელთა გამოწვევის პროგნოზირებისთვის და ამ მომზადებული მოდელების მუშაობის შესაფასებლად. იმის გამო, რომ გადახურების პროგნოზირება არის კლასიფიკაციის ამოცანა, SAS-მა შეარჩია ოთხი პოპულარული კლასიფიკაციის მოდელი პროგნოზების გასაკეთებლად, მათ შორის:

- შემთხვევითი ტყე

- გრადიენტის გაძლიერება

- ლოგისტიკური რეგრესია

- ნერვული ქსელი

სინთეტიკური მონაცემების გენერირებამდე, SAS შემთხვევით ყოფს ტელეკომის მონაცემთა ბაზას მატარებლის კომპლექტად (მოდელების მომზადებისთვის) და დამხმარე კომპლექტად (მოდელების ქულების შესაფასებლად). შეფასების ცალკეული კომპლექტის არსებობა საშუალებას იძლევა მიუკერძოებელი შეფასდეს იმის შესახებ, თუ რამდენად კარგად შეიძლება შეასრულოს კლასიფიკაციის მოდელი ახალ მონაცემებზე გამოყენებისას.

მატარებლის ნაკრების შეყვანის სახით, Syntho-მ გამოიყენა თავისი Syntho Engine სინთეტიკური მონაცემთა ნაკრების შესაქმნელად. ბენჩმარკინგის მიზნით, SAS-მა ასევე შექმნა მატარებლის ნაკრების მანიპულირებული ვერსია ანონიმიზაციის სხვადასხვა ტექნიკის გამოყენების შემდეგ, რათა მიაღწიოს გარკვეულ ზღურბლს (k-ანონიმურობის). წინა ნაბიჯები მოჰყვა ოთხ მონაცემთა ნაკრებს:

- მატარებლის მონაცემთა ნაკრები (ანუ თავდაპირველი მონაცემთა ნაკრები გამოკლებული შენახული მონაცემთა ნაკრები)

- შესანახი მონაცემთა ნაკრები (ანუ თავდაპირველი მონაცემთა ნაკრების ქვეჯგუფი)

- ანონიმური მონაცემთა ნაკრები (მატარებლის მონაცემთა ბაზაზე დაყრდნობით)

- სინთეზური მონაცემთა ნაკრები (მატარებლის მონაცემთა ბაზაზე დაყრდნობით)

მონაცემთა ნაკრები 1, 3 და 4 გამოიყენებოდა თითოეული კლასიფიკაციის მოდელის მოსამზადებლად, რის შედეგადაც შეიქმნა 12 (3 x 4) მომზადებული მოდელი. SAS-მა შემდგომში გამოიყენა შენახული მონაცემთა ნაკრები, რათა გაზომოს სიზუსტე, რომლითაც თითოეული მოდელი წინასწარმეტყველებს მომხმარებელთა გამორიცხვას. შედეგები წარმოდგენილია ქვემოთ, რამდენიმე ძირითადი სტატისტიკით დაწყებული.

სურათი: Machine Learning მილსადენი გენერირებული SAS Visual Data Mining-სა და Machine Learning-ში

ძირითადი სტატისტიკა ანონიმური მონაცემების ორიგინალურ მონაცემებთან შედარებისას

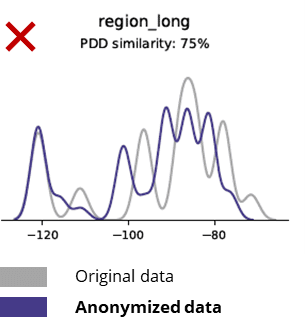

ანონიმიზაციის ტექნიკა ანადგურებს თუნდაც ძირითად შაბლონებს, ბიზნეს ლოგიკას, ურთიერთობებსა და სტატისტიკას (როგორც ქვემოთ მოცემულ მაგალითში). ამგვარად, ძირითადი ანალიტიკისთვის ანონიმური მონაცემების გამოყენება არასანდო შედეგებს იძლევა. სინამდვილეში, ანონიმური მონაცემების უხარისხობამ თითქმის შეუძლებელი გახადა მისი გამოყენება მოწინავე ანალიტიკური ამოცანებისთვის (მაგ. AI/ML მოდელირება და დაფა).

ძირითადი სტატისტიკა სინთეტიკური მონაცემების ორიგინალურ მონაცემებთან შედარებისას

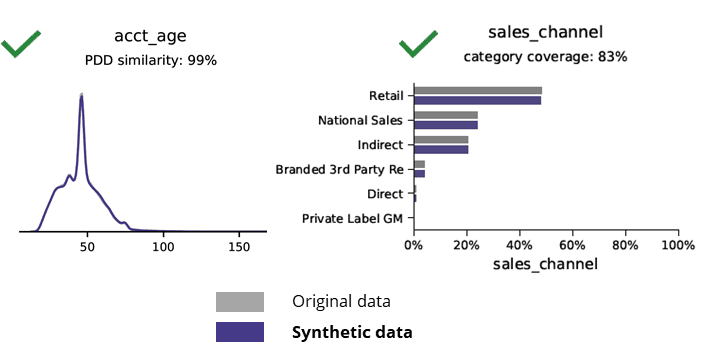

სინთეტიკური მონაცემების გენერირება ხელოვნური ინტელექტის საშუალებით ინახავს ძირითად შაბლონებს, ბიზნეს ლოგიკას, ურთიერთობებსა და სტატისტიკას (როგორც ქვემოთ მოცემულ მაგალითში). სინთეზური მონაცემების გამოყენება ძირითადი ანალიტიკისთვის იძლევა საიმედო შედეგებს. საკვანძო შეკითხვა, ინახება თუ არა სინთეზური მონაცემები მოწინავე ანალიტიკური ამოცანებისთვის (მაგ. AI/ML მოდელირება და დაფა)?

ხელოვნური ინტელექტის მიერ გენერირებული სინთეზური მონაცემები და მოწინავე ანალიტიკა

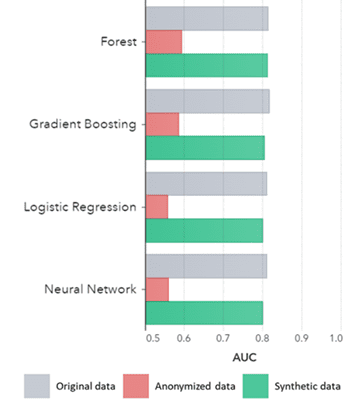

სინთეზური მონაცემები ინახება არა მხოლოდ ძირითადი შაბლონებისთვის (როგორც ნაჩვენებია ყოფილ ნახატებში), ის ასევე ასახავს ღრმა „დამალულ“ სტატისტიკურ შაბლონებს, რომლებიც საჭიროა მოწინავე ანალიტიკური ამოცანებისთვის. ეს უკანასკნელი ნაჩვენებია ქვემოთ მოცემულ სვეტოვან დიაგრამაში, რაც მიუთითებს, რომ სინთეზურ მონაცემებზე მომზადებული მოდელების სიზუსტე ორიგინალურ მონაცემებზე მომზადებული მოდელების მსგავსია. გარდა ამისა, მრუდის ქვეშ არსებული ფართობით (AUC*) 0.5-თან ახლოს, ანონიმურ მონაცემებზე გაწვრთნილი მოდელები ყველაზე უარესად მოქმედებენ. სრული ანგარიში ყველა მოწინავე ანალიტიკური შეფასებით სინთეზურ მონაცემებთან შედარებით ორიგინალურ მონაცემებთან შედარებით ხელმისაწვდომია მოთხოვნით.

*AUC: მრუდის ქვეშ არსებული ფართობი არის მოწინავე ანალიტიკური მოდელების სიზუსტის საზომი, ჭეშმარიტი დადებითი, ცრუ დადებითი, ცრუ უარყოფითი და ჭეშმარიტი ნეგატივების გათვალისწინებით. 0,5 ნიშნავს, რომ მოდელი წინასწარმეტყველებს შემთხვევით და არ აქვს პროგნოზირების ძალა, ხოლო 1 ნიშნავს, რომ მოდელი ყოველთვის სწორია და აქვს სრული პროგნოზირების ძალა.

გარდა ამისა, ეს სინთეზური მონაცემები შეიძლება გამოყენებულ იქნას მონაცემთა მახასიათებლებისა და მოდელების რეალური ტრენინგისთვის საჭირო ძირითადი ცვლადების გასაგებად. სინთეზურ მონაცემებზე ალგორითმების მიერ შერჩეული შეყვანები ორიგინალურ მონაცემებთან შედარებით ძალიან ჰგავდა. აქედან გამომდინარე, მოდელირების პროცესი შეიძლება განხორციელდეს ამ სინთეზურ ვერსიაზე, რაც ამცირებს მონაცემთა დარღვევის რისკს. თუმცა, ინდივიდუალური ჩანაწერების დასკვნისას (მაგ. ტელეკომპანიის კლიენტი) რეკომენდირებულია ორიგინალურ მონაცემებზე გადამზადება ახსნის, გაზრდილი მიღების ან მხოლოდ რეგულირების გამო.

AUC ალგორითმის მიხედვით დაჯგუფებული მეთოდით

დასკვნები:

- სინთეზურ მონაცემებზე გაწვრთნილი მოდელები ორიგინალურ მონაცემებზე გაწვრთნილ მოდელებთან შედარებით აჩვენებენ ძალიან მსგავს შესრულებას

- ანონიმიზებულ მონაცემებზე გაწვრთნილი მოდელები „კლასიკური ანონიმიზაციის ტექნიკით“ აჩვენებენ დაბალ შესრულებას ორიგინალურ ან სინთეზურ მონაცემებზე მომზადებულ მოდელებთან შედარებით.

- სინთეზური მონაცემების გენერირება მარტივი და სწრაფია, რადგან ტექნიკა ზუსტად ერთნაირად მუშაობს მონაცემთა ტიპზე და მონაცემთა ტიპზე.

ღირებულების დამამატებელი სინთეზური მონაცემების გამოყენების შემთხვევები

გამოიყენეთ შემთხვევა 1: სინთეზური მონაცემები მოდელის განვითარებისა და გაფართოებული ანალიტიკისთვის

მონაცემთა ძლიერი საფუძვლის ქონა გამოსაყენებელ, მაღალი ხარისხის მონაცემებზე მარტივი და სწრაფი წვდომით აუცილებელია მოდელების შემუშავებისთვის (მაგ. დაფები [BI] და გაფართოებული ანალიტიკა [AI & ML]). თუმცა, ბევრი ორგანიზაცია განიცდის არაოპტიმალური მონაცემთა ბაზას, რაც იწვევს 3 ძირითად გამოწვევას:

- მონაცემებზე წვდომას დრო სჭირდება (კონფიდენციალურობის) რეგულაციების, შიდა პროცესების ან მონაცემთა სილოსების გამო

- კლასიკური ანონიმიზაციის ტექნიკა ანადგურებს მონაცემებს, რის გამოც მონაცემები აღარ არის შესაფერისი ანალიზისთვის და გაფართოებული ანალიტიკისთვის (ნაგვის შეყვანა = ნაგვის გატანა)

- არსებული გადაწყვეტილებები არ არის მასშტაბირებადი, რადგან ისინი განსხვავებულად მუშაობენ მონაცემთა და მონაცემთა ტიპების მიხედვით და ვერ უმკლავდებიან მრავალ ცხრილიან მონაცემთა ბაზას

სინთეზური მონაცემთა მიდგომა: შეიმუშავეთ მოდელები ისეთივე კარგი, როგორც რეალური სინთეტიკური მონაცემებით:

- შეამცირეთ ორიგინალური მონაცემების გამოყენება თქვენი დეველოპერების შეფერხების გარეშე

- განბლოკეთ პერსონალური მონაცემები და გქონდეთ წვდომა სხვა მონაცემებზე, რომლებიც ადრე იყო შეზღუდული (მაგ. კონფიდენციალურობის გამო)

- მარტივი და სწრაფი მონაცემების წვდომა შესაბამის მონაცემებზე

- მასშტაბირებადი გადაწყვეტა, რომელიც ერთნაირად მუშაობს თითოეული მონაცემთა ტიპისთვის და მონაცემთა მასიური ბაზებისთვის

ეს საშუალებას აძლევს ორგანიზაციას შექმნას მონაცემთა ძლიერი საფუძველი მარტივი და სწრაფი წვდომით გამოსაყენებელ, მაღალი ხარისხის მონაცემებზე, რათა განბლოკოს მონაცემები და გამოიყენოს მონაცემთა შესაძლებლობები.

გამოიყენეთ შემთხვევა 2: ჭკვიანი სინთეტიკური ტესტის მონაცემები პროგრამული უზრუნველყოფის ტესტირებისთვის, განვითარებისა და მიწოდებისთვის

ტესტირება და განვითარება მაღალი ხარისხის ტესტის მონაცემებით აუცილებელია უახლესი პროგრამული გადაწყვეტილებების მიწოდებისთვის. ორიგინალური წარმოების მონაცემების გამოყენება აშკარად ჩანს, მაგრამ დაუშვებელია (კონფიდენციალურობის) რეგულაციების გამო. ალტერნატივა Test Data Management (TDM) ინსტრუმენტები წარმოგიდგენთ ”legacy-by-design” ტესტის მონაცემების სწორად მიღებისას:

- არ ასახოთ წარმოების მონაცემები და არ არის დაცული ბიზნეს ლოგიკა და რეფერენტული მთლიანობა

- იმუშავეთ ნელა და შრომატევადი

- საჭიროა ხელით მუშაობა

სინთეტიკური მონაცემთა მიდგომა: გამოცადეთ და განავითარეთ ხელოვნური ინტელექტის მიერ გენერირებული სინთეტიკური ტესტის მონაცემებით, რათა უზრუნველყოთ უახლესი პროგრამული გადაწყვეტილებები ჭკვიანი:

- წარმოების მსგავსი მონაცემები შენარჩუნებული ბიზნეს ლოგიკით და რეფერენტული მთლიანობით

- მონაცემთა მარტივი და სწრაფი წარმოება უახლესი ხელოვნური ინტელექტით

- კონფიდენციალურობა დიზაინის მიხედვით

- მარტივი, სწრაფი და agile

ეს საშუალებას აძლევს ორგანიზაციას შეამოწმოს და განავითაროს შემდეგი დონის ტესტის მონაცემებით, რათა მიაწოდოს უახლესი პროგრამული გადაწყვეტილებები!

დამატებითი ინფორმაცია

გაინტერესებთ? სინთეზური მონაცემების შესახებ დამატებითი ინფორმაციისთვის ეწვიეთ Syntho-ს ვებსაიტს ან დაუკავშირდით Wim Kees Janssen-ს. დამატებითი ინფორმაციისთვის SAS-ის შესახებ ეწვიეთ www.sas.com ან დაუკავშირდით kees@syntho.ai.

ამ გამოყენების შემთხვევაში, Syntho, SAS და NL AIC ერთად მუშაობენ დასახული შედეგების მისაღწევად. Syntho არის ექსპერტი ხელოვნური ინტელექტის მიერ გენერირებული სინთეზური მონაცემებისა და SAS არის ბაზრის ლიდერი ანალიტიკაში და გთავაზობთ პროგრამულ უზრუნველყოფას მონაცემთა შესასწავლად, ანალიზისა და ვიზუალიზაციისთვის.

* პროგნოზირებს 2021 – მონაცემთა და ანალიტიკის სტრატეგიებს ციფრული ბიზნესის მართვის, მასშტაბირებისა და ტრანსფორმაციისთვის, Gartner, 2020.

შეინახეთ თქვენი სინთეტიკური მონაცემების სახელმძღვანელო ახლავე!

- რა არის სინთეზური მონაცემები?

- რატომ იყენებენ ორგანიზაციები მას?

- ღირებულების დამამატებელი სინთეზური მონაცემების კლიენტის შემთხვევები

- როგორ დავიწყოთ