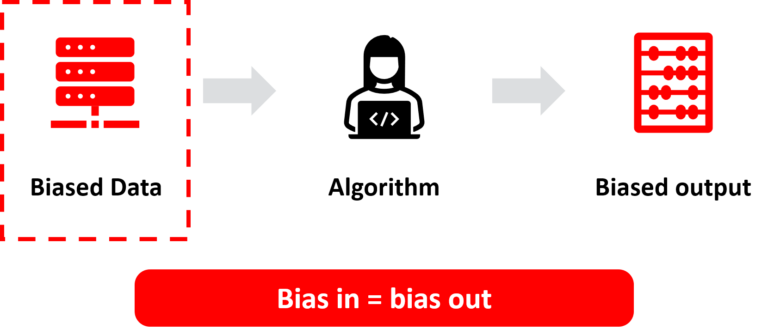

Kami gembira diumumkan sebagai pemenang di VivaTech 2021 untuk cabaran berat sebelah gender UNESCO. Syntho: “bias in = bias out” dan kami mencadangkan untuk menyelesaikan ketidakseimbangan dalam data input dengan mengimbanginya dengan data sintetik pintar. Di VivaTech, kami menunjukkan 'ciri pengimbangan data' baharu kami, salah satu daripada penambahan nilai baharu kami ciri data sintetik, yang membawa data anda ke tahap seterusnya!

VivaTech adalah acara permulaan dan teknologi terbesar di Eropah yang dihoskan pada 16-19 Jun 2021. Tahun ini, organisasi ini menganjurkan pengalaman hibrid kerana COVID, secara langsung di Paris dan dalam talian di seluruh dunia, yang menyatukan komuniti inovator yang lebih besar lagi.

UNESCO adalah Pertubuhan Pendidikan, Saintifik dan Kebudayaan Pertubuhan Bangsa-Bangsa Bersatu. UNESCO memperjuangkan kebebasan bersuara dan akses kepada maklumat, sebagai hak asasi dan syarat utama demokrasi dan pembangunan. Berkhidmat sebagai makmal idea dengan inovasi digital di tengah-tengahnya, UNESCO membantu negara-negara membangun dasar dan program yang mendorong aliran idea dan perkongsian pengetahuan secara bebas untuk menangani cabaran dunia dan memastikan pembangunan lestari untuk semua.

Cabaran bias gender bertujuan untuk mengurangkan jurang digital jantina dengan mendedahkan bias dalam AI. AI memanfaatkan kumpulan data yang berat sebelah, memperkuat bias gender yang ada dalam masyarakat kita. Bukti menunjukkan bahawa pada tahun 2022, 85% projek AI akan memberikan hasil yang salah kerana bias jika AI sebagai teknologi dan sebagai sektor tidak lebih inklusif dan beragam. Bagaimana kita dapat memastikan set data lebih pelbagai? UNESCO mencari penyelesaian inovatif yang bertujuan untuk mengurangkan jurang digital jantina dengan mendedahkan bias dalam AI.

Laporan seminal UNESCO dari 2019 menunjukkan bahawa alat pembantu suara bertenaga AI seperti Alexa dan Siri mengabadikan stereotaip berbahaya dan penderaan seksis yang ditujukan kepada teknologi 'feminized' bahkan dinantikan oleh syarikat teknologi.

Dalam contoh ini dari UNESCO, Sekiranya terdapat bias tertentu dalam data, maka akan menyebabkan bias pada output. Oleh itu, pernyataan kami: 'bias in = bias out'. Dan dalam contoh yang dikongsi, pemaju nampaknya sudah mengetahui tentang ketidakseimbangan dan bias tertentu dalam data. Jadi, bagaimana mengatasi ini?

Kita harus mengimbangi kembali dataset untuk menyelesaikan cabaran bias data yang boleh menyebabkan diskriminasi dalam algoritma. Bagaimana penyelesaian kita berfungsi. Dalam contoh ini, terdapat bias dan ketidakseimbangan data. Di mana kita menjangkakan 50% lelaki dan 50% wanita, kita hanya melihat 33% wanita dan 66% lelaki. Kami dapat menyelesaikannya dengan menghasilkan rekod data wanita atau lelaki sintetik tambahan untuk mengimbangi set data kembali kepada 50% lelaki dan 50% wanita untuk mengurangkan bias dan ketidakseimbangan data yang boleh mengakibatkan diskriminasi. Ini adalah bagaimana kita menyelesaikan bias data. Kami menyelesaikan masalah dengan akarnya. Kami menyelesaikan cabaran 'bias in = bias out'.

Hubungi Syntho dan salah seorang pakar kami akan menghubungi anda dengan kelajuan cahaya untuk meneroka nilai data sintetik!