Синтетички податоци генерирани со вештачка интелигенција, лесен и брз пристап до висококвалитетни податоци?

Вештачката интелигенција генерирала синтетички податоци во пракса

Syntho, експерт за синтетички податоци генерирани со вештачка интелигенција, има за цел да се сврти privacy by design во конкурентна предност со синтетички податоци генерирани со вештачка интелигенција. Тие им помагаат на организациите да изградат силна основа за податоци со лесен и брз пристап до висококвалитетни податоци и неодамна ја освоија наградата за иновации на Филипс.

Сепак, синтетичкото генерирање податоци со вештачка интелигенција е релативно ново решение кое обично воведува често поставувани прашања. За да одговори на овие прашања, Syntho започна студија на случај заедно со SAS, лидер на пазарот во Advanced Analytics и софтвер за вештачка интелигенција.

Во соработка со холандската коалиција за вештачка интелигенција (NL AIC), тие ја истражуваа вредноста на синтетичките податоци споредувајќи ги синтетичките податоци генерирани од вештачката интелигенција генерирани од Syntho Engine со оригиналните податоци преку различни проценки за квалитетот на податоците, правната валидност и употребливоста.

Дали анонимизацијата на податоците не е решение?

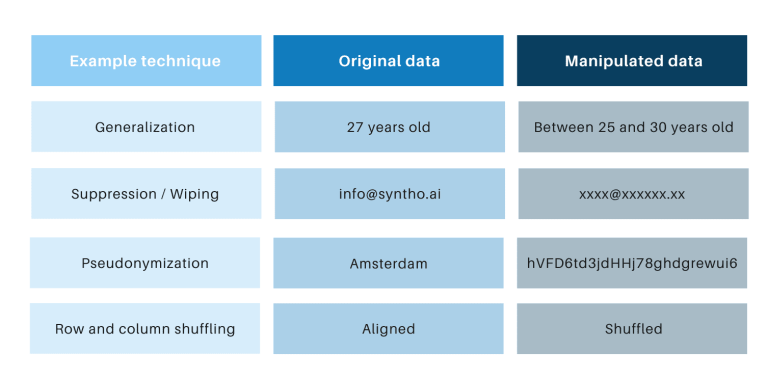

Класичните техники за анонимизација имаат заедничко тоа што манипулираат со оригинални податоци со цел да го спречат пронаоѓањето на поединци. Примерите се генерализација, потиснување, бришење, псевдонимизација, маскирање на податоци и мешање на редови и колони. Можете да најдете примери во табелата подолу.

Тие техники воведуваат 3 клучни предизвици:

- Тие работат различно по тип на податоци и по база на податоци, што ги прави тешки за скалирање. Понатаму, бидејќи тие работат поинаку, секогаш ќе има дебата за тоа кои методи да се применат и каква комбинација на техники се потребни.

- Секогаш постои врска еден-на-еден со оригиналните податоци. Ова значи дека секогаш ќе постои ризик за приватност, особено поради сите отворени збирки на податоци и достапни техники за поврзување на тие збирки на податоци.

- Тие манипулираат со податоци и со тоа ги уништуваат податоците во процесот. Ова е особено погубно за задачите со вештачка интелигенција каде што „моќта за предвидување“ е од суштинско значење, бидејќи податоците со лош квалитет ќе резултираат со лоши сознанија од моделот на вештачка интелигенција (внесувањето ѓубре ќе резултира со исфрлање на ѓубрето).

Овие точки се оценуваат и преку оваа студија на случај.

Вовед во студијата на случај

За студијата на случај, целната база на податоци беше телекомуникациска база обезбедена од SAS која содржи податоци од 56.600 клиенти. Податокот содржи 128 колони, вклучително и една колона што покажува дали клиентот ја напуштил компанијата (т.е. „избркан“) или не. Целта на студијата на случај беше да се искористат синтетичките податоци за да се обучат некои модели за да се предвиди раздвојувањето на клиентите и да се оценат перформансите на тие обучени модели. Бидејќи предвидувањето на пречки е задача за класификација, SAS избра четири популарни модели на класификација за да ги направи предвидувањата, вклучувајќи:

- Случајна шума

- Зголемување на градиентот

- Логистичка регресија

- Нервна мрежа

Пред да ги генерира синтетичките податоци, SAS по случаен избор го дели телекомуникацискиот сет на воз (за обука на моделите) и сет за задржување (за бодување на моделите). Посебниот сет за бодување овозможува непристрасна проценка за тоа колку добро моделот на класификација може да функционира кога се применува на нови податоци.

Користејќи го комплетот воз како влез, Syntho го користеше својот Syntho Engine за да генерира синтетичка база на податоци. За бенчмаркинг, SAS, исто така, создаде манипулирана верзија на комплетот воз по примена на различни техники за анонимизација за да достигне одреден праг (на k-анонимност). Поранешните чекори резултираа во четири сетови на податоци:

- Дата на податоци за воз (т.е. оригиналната база на податоци минус резервната база на податоци)

- Задржана база на податоци (т.е. подмножество од оригиналната база на податоци)

- Анонимизирана база на податоци (врз основа на базата на податоци за воз)

- Синтетичка база на податоци (врз основа на базата на податоци за воз)

Збирките на податоци 1, 3 и 4 беа користени за обука на секој модел на класификација, што резултираше со 12 (3 x 4) обучени модели. SAS последователно ја користеше базата на податоци за задржување за да ја измери точноста со која секој модел го предвидува раздвојувањето на клиентите. Резултатите се претставени подолу, почнувајќи со некои основни статистички податоци.

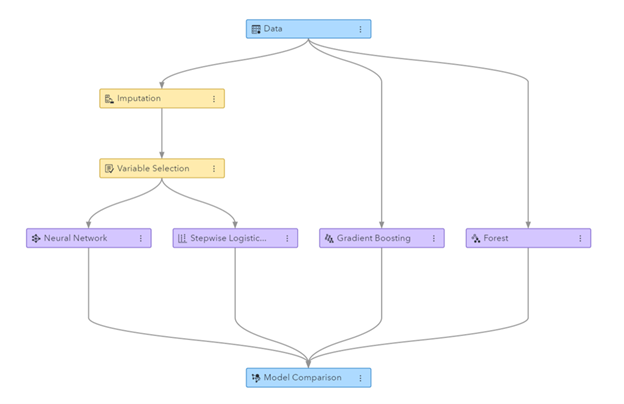

Слика: Гасовод за машинско учење генериран во SAS Visual Data Mining и Machine Learning

Основна статистика кога се споредуваат анонимизирани податоци со оригинални податоци

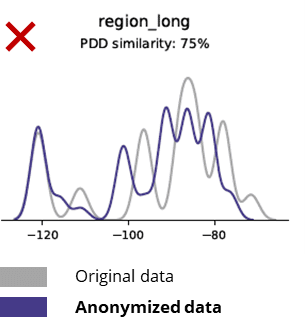

Техниките за анонимизација ги уништуваат дури и основните обрасци, деловната логика, односите и статистиката (како во примерот подолу). Користењето анонимизирани податоци за основна аналитика на тој начин дава несигурни резултати. Всушност, лошиот квалитет на анонимизираните податоци го оневозможи нивното користење за напредни аналитички задачи (на пр. AI/ML моделирање и табла).

Основна статистика при споредување на синтетички податоци со оригинални податоци

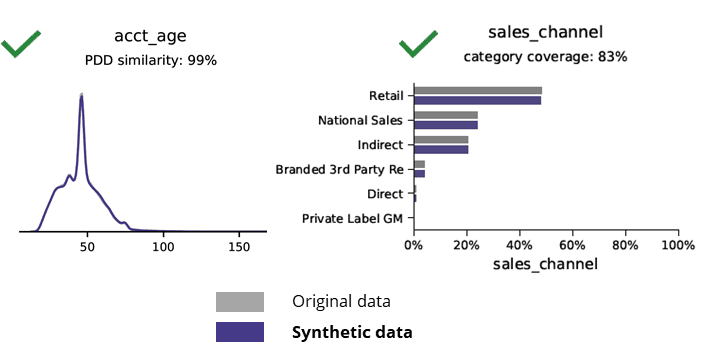

Синтетичкото генерирање податоци со вештачка интелигенција ги зачувува основните обрасци, деловната логика, односите и статистиката (како во примерот подолу). Користењето синтетички податоци за основна аналитика на тој начин дава сигурни резултати. Клучно прашање, дали чуваат синтетички податоци за напредни аналитички задачи (на пр. AI/ML моделирање и табла)?

Синтетички податоци генерирани со вештачка интелигенција и напредна аналитика

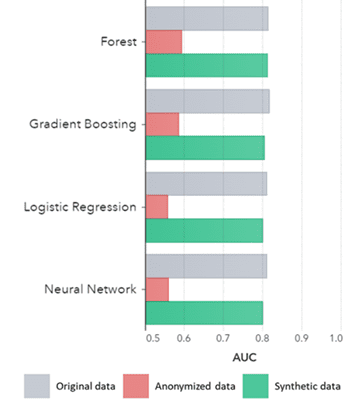

Синтетичките податоци се чуваат не само за основните обрасци (како што е прикажано на претходните графики), тие исто така доловуваат длабоки „скриени“ статистички обрасци потребни за напредни аналитички задачи. Последново е прикажано на столбестиот графикон подолу, што покажува дека точноста на моделите обучени на синтетички податоци наспроти моделите обучени на оригинални податоци се слични. Понатаму, со површина под кривата (AUC*) блиску до 0.5, моделите обучени на анонимизирани податоци имаат далеку најлошо. Целосниот извештај со сите напредни аналитички проценки за синтетички податоци во споредба со оригиналните податоци е достапен на барање.

*AUC: областа под кривата е мерка за точноста на напредните аналитички модели, земајќи ги предвид вистинските позитивни, лажно позитивни, лажни негативни и вистински негативни. 0,5 значи дека моделот предвидува случајно и нема моќ на предвидување, а 1 значи дека моделот е секогаш точен и има целосна предвидувачка моќ.

Дополнително, овие синтетички податоци може да се користат за да се разберат карактеристиките на податоците и главните променливи потребни за вистинска обука на моделите. Влезовите избрани од алгоритмите за синтетички податоци во споредба со оригиналните податоци беа многу слични. Оттука, процесот на моделирање може да се направи на оваа синтетичка верзија, што го намалува ризикот од прекршување на податоците. Меѓутоа, кога се наведуваат поединечни записи (на пр. телекомуникациски клиент) се препорачува преквалификација на оригиналните податоци заради објаснување, зголемено прифаќање или само поради регулатива.

AUC по алгоритам групирани по метод

Заклучоци:

- Моделите обучени на синтетички податоци во споредба со моделите обучени на оригинални податоци покажуваат многу слични перформанси

- Моделите обучени на анонимизирани податоци со „класични техники за анонимизација“ покажуваат инфериорни перформанси во споредба со моделите обучени на оригинални податоци или синтетички податоци

- Генерирањето синтетички податоци е лесно и брзо затоа што техниката работи сосема исто по база на податоци и по тип на податоци.

Случаи за употреба на синтетички податоци што додаваат вредност

Користете случај 1: Синтетички податоци за развој на модел и напредна аналитика

Да се има силна податочна основа со лесен и брз пристап до употребливи, висококвалитетни податоци е од суштинско значење за развој на модели (на пр. контролни табли [BI] и напредна аналитика [AI и ML]). Сепак, многу организации страдаат од неоптимална основа за податоци што резултира со 3 клучни предизвици:

- Добивањето пристап до податоците трае со години поради прописите (за приватност), внатрешните процеси или силосите за податоци

- Класичните техники за анонимизација ги уништуваат податоците, со што податоците повеќе не се погодни за анализа и напредна аналитика (влегува ѓубре = исфрлање на ѓубрето)

- Постоечките решенија не се скалабилни бидејќи тие работат различно по база на податоци и по тип на податоци и не можат да се справат со големи бази на податоци со повеќе табели

Пристап за синтетички податоци: развивајте модели со синтетички податоци како добри како реални за:

- Минимизирајте ја употребата на оригинални податоци, без да ги попречувате вашите развивачи

- Отклучете ги личните податоци и имате пристап до повеќе податоци што претходно беа ограничени (на пр. Поради приватност)

- Лесен и брз пристап до податоци до релевантни податоци

- Скалабилно решение што работи исто за секоја база на податоци, тип на дата и за масивни бази на податоци

Ова им овозможува на организацијата да изгради силна податочна основа со лесен и брз пристап до употребливи, висококвалитетни податоци за отклучување на податоците и за искористување на можностите за податоци.

Користете случај 2: паметни синтетички тест податоци за тестирање, развој и испорака на софтвер

Тестирањето и развојот со висококвалитетни тест-податоци се од суштинско значење за да се обезбедат најсовремени софтверски решенија. Користењето оригинални податоци за производство изгледа очигледно, но не е дозволено поради прописите за (приватност). Алтернатива Test Data Management (TDM) алатките воведуваат „legacy-by-design” за правилно добивање на податоците од тестот:

- Не ги одразувајте податоците за производството и деловната логика и референцискиот интегритет не се зачувани

- Работете бавно и одзема време

- Потребна е рачна работа

Пристап за синтетички податоци: тестирајте и развивајте со синтетички тест-податоци генерирани од вештачка интелигенција за да испорачате најсовремени софтверски решенија паметни со:

- Податоци слични на производството со зачувана деловна логика и референцијален интегритет

- Лесно и брзо генерирање податоци со најсовремена вештачка интелигенција

- Приватност-по-дизајн

- Лесно, брзо и agile

Ова им овозможува на организацијата да тестира и развива со податоци за тестирање на следното ниво за да испорача најсовремени софтверски решенија!

Повеќе информации

Заинтересирани? За повеќе информации за синтетичките податоци, посетете ја веб-локацијата на Syntho или контактирајте со Вим Кеес Јансен. За повеќе информации за SAS, посетете www.sas.com или контактирајте со kees@syntho.ai.

Во овој случај на употреба, Syntho, SAS и NL AIC работат заедно за да ги постигнат предвидените резултати. Syntho е експерт за синтетички податоци генерирани со вештачка интелигенција, а SAS е лидер на пазарот во аналитика и нуди софтвер за истражување, анализа и визуелизација на податоците.

* Предвидува 2021 година - Стратегии за податоци и аналитика за управување, размерување и трансформирање на дигиталниот бизнис, Гартнер, 2020 година.

Зачувајте го вашиот водич за синтетички податоци сега!

- Што се синтетички податоци?

- Зошто организациите го користат?

- Случаи за клиент со синтетички податоци за додавање вредност

- Како да започнете