Der unsichtbare Übeltäter der KI: Die innere Voreingenommenheit aufdecken

Bias-Blogserie: Teil 1

Einleitung

In unserer Welt der zunehmend künstlichen Intelligenz gewinnen Maschinen, die komplexe Entscheidungen treffen sollen, immer mehr an Bedeutung. Es gibt immer mehr Literatur, die auf den Einsatz von KI in verschiedenen Bereichen wie der Wirtschaft, der Entscheidungsfindung mit hohem Risiko und in den letzten Jahren auch im medizinischen Bereich hinweist. Mit dieser zunehmenden Verbreitung sind jedoch auch besorgniserregende Tendenzen in diesen Systemen aufgefallen; Das heißt, obwohl sie von Natur aus darauf ausgelegt sind, rein den Mustern in den Daten zu folgen, haben sie Anzeichen von Vorurteilen gezeigt, in dem Sinne, dass verschiedene sexistische und diskriminierende Verhaltensweisen beobachtet werden können. Das Kürzliche Europäisches KI-Gesetzbefasst sich auch recht ausführlich mit solchen Vorurteilen und legt eine Grundlage für die Bewältigung der damit verbundenen Probleme.

Im Laufe der Jahre der technischen Dokumentation haben Menschen dazu tendiert, den Begriff „Voreingenommenheit“ zu verwenden, um dieses verzerrte Verhalten gegenüber bestimmten Bevölkerungsgruppen zu beschreiben; ein Wort, dessen Bedeutung variiert, was Verwirrung stiftet und die Adressierung erschwert.

Dieser Artikel ist der erste einer Reihe von Blogbeiträgen zum Thema Voreingenommenheit. In dieser Serie möchten wir Ihnen ein klares und verständliches Verständnis der Voreingenommenheit in der KI vermitteln. Wir stellen Möglichkeiten zur Messung und Minimierung von Verzerrungen vor und untersuchen die Rolle synthetischer Daten auf diesem Weg zu gerechteren Systemen. Wir geben Ihnen auch einen Einblick, wie Syntho, ein führender Anbieter in der Generierung synthetischer Daten, zu diesen Bemühungen beitragen kann. Egal, ob Sie als Praktiker auf der Suche nach umsetzbaren Erkenntnissen sind oder sich einfach nur für dieses Thema interessieren, hier sind Sie richtig.

Voreingenommenheit in der Praxis: Ein Beispiel aus der Praxis

Sie fragen sich vielleicht: „Diese Tendenz in der KI ist wichtig, aber was bedeutet sie für mich, für normale Menschen?“ Die Wahrheit ist, dass die Auswirkungen weitreichend sind, oft unsichtbar, aber wirkungsvoll. Bias in der KI ist kein bloß akademisches Konzept; Es ist ein reales Problem mit schwerwiegenden Folgen.

Nehmen Sie als Beispiel den niederländischen Kindeswohlskandal. Das automatisierte System, angeblich ein Werkzeug, das geschaffen wurde, um mit minimalem menschlichen Eingriff faire und effiziente Ergebnisse zu erzielen, war voreingenommen. Es hat Tausende von Eltern fälschlicherweise wegen Betrugs angezeigt, der auf fehlerhaften Daten und Annahmen beruhte. Das Ergebnis? Familien geraten in Aufruhr, der persönliche Ruf wird geschädigt und es kommt zu finanziellen Schwierigkeiten – alles aufgrund von Vorurteilen in einem KI-System. Es sind Beispiele wie diese, die die Dringlichkeit verdeutlichen, Voreingenommenheit in der KI anzugehen.

Quelle: "Die Kompensation neuer Geschäftsbeziehungen kann bis 2030 dauern“, 2023. NR

Aber lasst uns hier nicht aufhören. Dieser Vorfall ist kein Einzelfall verheerender Voreingenommenheit. Die Auswirkungen von Voreingenommenheit in der KI erstrecken sich auf alle Bereiche unseres Lebens. Von der Person, die für einen Job eingestellt wird, der die Genehmigung für einen Kredit erhält, bis hin zur Person, die welche medizinische Behandlung erhält – voreingenommene KI-Systeme können bestehende Ungleichheiten aufrechterhalten und neue schaffen.

Bedenken Sie Folgendes: Ein KI-System, das auf voreingenommenen historischen Daten trainiert wird, könnte einem gut qualifizierten Kandidaten einfach aufgrund seines Geschlechts oder seiner ethnischen Zugehörigkeit eine Stelle verweigern. Oder ein voreingenommenes KI-System könnte einem würdigen Kandidaten aufgrund seiner Postleitzahl einen Kredit verweigern. Dabei handelt es sich nicht nur um hypothetische Szenarien; sie passieren gerade jetzt.

Die spezifischen Arten von Verzerrungen, wie z. B. historische Verzerrungen und Messverzerrungen, führen zu solchen fehlerhaften Entscheidungen. Sie sind den Daten inhärent, tief in gesellschaftlichen Vorurteilen verwurzelt und spiegeln sich in den ungleichen Ergebnissen verschiedener Bevölkerungsgruppen wider. Sie können die Entscheidungen von Vorhersagemodellen verzerren und zu einer unfairen Behandlung führen.

Im Großen und Ganzen kann Voreingenommenheit in der KI als stiller Einflussfaktor wirken und unsere Gesellschaft und unser Leben auf subtile Weise prägen, oft auf eine Weise, die uns gar nicht bewusst ist. All diese oben genannten Punkte könnten Sie zu der Frage veranlassen, warum keine Maßnahmen ergriffen wurden, um das Problem zu stoppen, und ob dies überhaupt möglich ist.

Tatsächlich wird es mit neuen technologischen Fortschritten immer einfacher, dieses Problem anzugehen. Der erste Schritt zur Lösung dieses Problems besteht jedoch darin, seine Existenz und Auswirkungen zu verstehen und anzuerkennen. Die Anerkennung seiner Existenz ist vorerst geschaffen, so dass die Frage des „Verstehens“ noch recht vage ist.

Voreingenommenheit verstehen

Während die ursprüngliche Definition von Voreingenommenheit, wie sie von der Cambridge Wörterbuch Obwohl sich die Bedeutung des Wortes in Bezug auf KI nicht allzu weit vom Hauptzweck des Wortes entfernt, gibt es selbst für diese einzigartige Definition viele verschiedene Interpretationen. Taxonomien, wie sie beispielsweise von Forschern vorgestellt werden Hellström et al. (2020) und Kliegr (2021), liefern tiefere Einblicke in die Definition von Voreingenommenheit. Ein einfacher Blick auf diese Papiere zeigt jedoch, dass die Definition des Begriffs stark eingeschränkt werden muss, um das Problem wirksam anzugehen.

Während es sich um eine Veränderung der Ereignisse handelt, kann man, um die Bedeutung von Voreingenommenheit optimal zu definieren und zu vermitteln, das Gegenteil besser definieren, nämlich Fairness.

Fairness definieren

Wie es in verschiedener neuerer Literatur definiert ist, wie z Castelnovo et al. (2022), Fairness kann näher erläutert werden, wenn man den Begriff des potenziellen Raums versteht. In seiner jetzigen Form bezieht sich der potenzielle Raum (Potential Space, PS) auf den Umfang der Fähigkeiten und des Wissens einer Person, unabhängig von ihrer Zugehörigkeit zu einer bestimmten demografischen Gruppe. Angesichts dieser Definition des PS-Konzepts kann man Fairness leicht als die Gleichbehandlung zweier Individuen mit gleichem PS definieren, unabhängig von ihren beobachtbaren und verborgenen Unterschieden in voreingenommenen Parametern (wie Rasse, Alter oder Geschlecht). Jede Abweichung von dieser Definition, auch Chancengleichheit genannt, ist ein klarer Hinweis auf Voreingenommenheit und bedarf weiterer Untersuchungen.

Den Praktikern unter den Lesern wird vielleicht auffallen, dass es angesichts der in unserer Welt vorhandenen Vorurteile möglicherweise völlig unmöglich ist, etwas wie hier definiert zu erreichen. Das ist wahr! Die Welt, in der wir leben, sowie alle Daten, die über Ereignisse in dieser Welt gesammelt werden, unterliegen großen historischen und statistischen Verzerrungen. Dies schmälert in der Tat die Zuversicht, eines Tages die Auswirkungen von Verzerrungen auf Vorhersagemodelle, die auf solchen „verzerrten“ Daten trainiert werden, vollständig abzumildern. Durch den Einsatz verschiedener Methoden kann jedoch versucht werden, die Auswirkungen von Vorurteilen zu minimieren. Aus diesem Grund wird sich die Terminologie in den restlichen Blogbeiträgen dahingehend verschieben, die Auswirkungen von Voreingenommenheit zu minimieren, anstatt sie vollständig abzumildern.

Okay! Nachdem nun eine Vorstellung davon entstanden ist, was Voreingenommenheit ist und wie man ihre Existenz möglicherweise bewerten könnte; Wenn wir das Problem jedoch richtig angehen wollen, müssen wir wissen, woher all diese Vorurteile kommen.

Die Quellen und Typen verstehen

Die bestehende Forschung liefert wertvolle Einblicke in die verschiedenen Arten von Verzerrungen beim maschinellen Lernen. Als Mehrabi et. al. (2019) Nachdem wir Vorurteile beim maschinellen Lernen unterteilt haben, kann man Vorurteile in drei Hauptkategorien einteilen. Nämlich die von:

- Von Daten zu Algorithmen: Eine Kategorie, die Vorurteile umfasst, die aus den Daten selbst stammen. Möglicherweise liegt dies an einer schlechten Datenerfassung, in der Welt vorhandenen Vorurteilen usw.

- Algorithmus zum Benutzer: Eine Kategorie, die sich auf Vorurteile konzentriert, die sich aus dem Design und der Funktionalität der Algorithmen ergeben. Dazu gehört, wie Algorithmen bestimmte Datenpunkte interpretieren, gewichten oder gegenüber anderen berücksichtigen, was zu verzerrten Ergebnissen führen kann.

- Benutzer zu Daten: bezieht sich auf Vorurteile, die sich aus der Benutzerinteraktion mit dem System ergeben. Die Art und Weise, wie Benutzer Daten eingeben, ihre inhärenten Vorurteile oder sogar ihr Vertrauen in die Systemausgaben können die Ergebnisse beeinflussen.

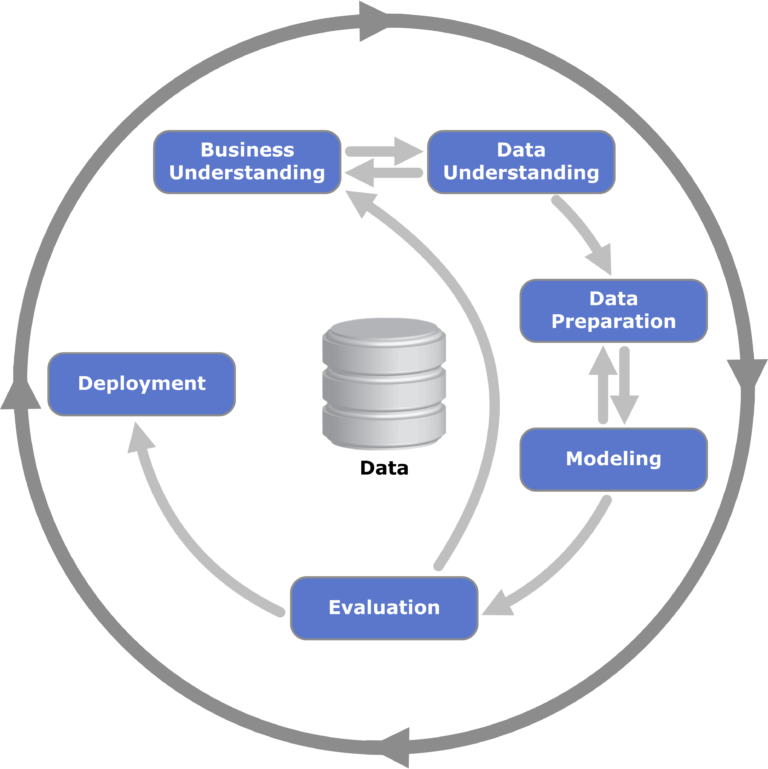

Abbildung 1: Eine Visualisierung des CRISP-DM-Frameworks für Data Mining; Wird häufig beim Data Mining verwendet und ist für den Prozess der Identifizierung der Phasen relevant, in denen Voreingenommenheit entstehen kann.

Auch wenn die Namen Hinweise auf die Form der Voreingenommenheit geben, könnte man dennoch Fragen dazu haben, welche Arten von Voreingenommenheit man unter diesen Oberbegriffen kategorisieren könnte. Für die Enthusiasten unter unseren Lesern haben wir Links zu Literatur bereitgestellt, die sich auf diese Terminologie und Klassifizierung bezieht. Der Einfachheit halber werden wir in diesem Blogbeitrag einige ausgewählte Vorurteile behandeln, die für die Situation relevant sind (fast alle davon gehören zur Kategorie „Daten für Algorithmen“). Die spezifischen Arten von Vorurteilen sind wie folgt:

- Historische Verzerrung: Eine Art von Verzerrung, die den Daten innewohnt und durch die in der Welt in verschiedenen sozialen Gruppen und in der Gesellschaft im Allgemeinen bestehenden natürlichen Vorurteile verursacht wird. Aufgrund der Inhärenz dieser Daten in der Welt können sie nicht durch verschiedene Methoden der Stichprobenziehung und Merkmalsauswahl gemindert werden.

- Messverzerrung und Darstellungsverzerrung: Diese beiden eng miteinander verbundenen Verzerrungen treten auf, wenn die verschiedenen Untergruppen des Datensatzes ungleiche Mengen an „günstigen“ Ergebnissen enthalten. Diese Art von Verzerrung kann daher das Ergebnis von Vorhersagemodellen verzerren

- Algorithmischer Bias: Bias, der ausschließlich mit dem verwendeten Algorithmus zusammenhängt. Wie auch in durchgeführten Tests beobachtet wurde (auf die im Beitrag weiter eingegangen wird), kann diese Art von Verzerrung enorme Auswirkungen auf die Fairness eines bestimmten Algorithmus haben.

Diese grundlegenden Erkenntnisse über Voreingenommenheit beim maschinellen Lernen werden genutzt, um das Problem in späteren Beiträgen effektiver anzugehen.

Abschließende Überlegungen

In dieser Untersuchung der Voreingenommenheit innerhalb der künstlichen Intelligenz haben wir die tiefgreifenden Auswirkungen beleuchtet, die sie in unserer zunehmend KI-gesteuerten Welt hat. Von realen Beispielen wie dem niederländischen Kindeswohlskandal bis hin zu den komplizierten Nuancen von Voreingenommenheitskategorien und -typen wird deutlich, dass das Erkennen und Verstehen von Voreingenommenheit von größter Bedeutung ist.

Die Herausforderungen, die Vorurteile mit sich bringen – sei es historischer, algorithmischer oder benutzerinduzierter Art – sind zwar erheblich, aber nicht unüberwindbar. Wenn wir die Ursprünge und Erscheinungsformen von Voreingenommenheit genau kennen, sind wir besser in der Lage, sie anzugehen. Allerdings sind Anerkennung und Verständnis nur die Ausgangspunkte.

Im weiteren Verlauf dieser Serie wird unser nächster Fokus auf den konkreten Tools und Frameworks liegen, die uns zur Verfügung stehen. Wie messen wir das Ausmaß der Verzerrung in KI-Modellen? Und was noch wichtiger ist: Wie minimieren wir die Auswirkungen? Dies sind die dringenden Fragen, mit denen wir uns als Nächstes befassen werden, um sicherzustellen, dass die Weiterentwicklung der KI sowohl fair als auch leistungsfähig ist.

Daten sind synthetisch, aber unser Team ist real!

Kontakt aufnehmen und einer unserer Experten wird sich blitzschnell mit Ihnen in Verbindung setzen, um den Wert synthetischer Daten zu erkunden!