KI-generierte synthetische Daten, einfacher und schneller Zugriff auf qualitativ hochwertige Daten?

KI generiert synthetische Daten in der Praxis

Syntho, ein Experte für KI-generierte synthetische Daten, will sich wenden privacy by design zu einem Wettbewerbsvorteil mit KI-generierten synthetischen Daten. Sie helfen Unternehmen beim Aufbau einer starken Datengrundlage mit einfachem und schnellem Zugriff auf qualitativ hochwertige Daten und haben kürzlich den Philips Innovation Award gewonnen.

Die Generierung synthetischer Daten mit KI ist jedoch eine relativ neue Lösung, die in der Regel häufig gestellte Fragen aufwirft. Um diese zu beantworten, hat Syntho zusammen mit SAS, dem Marktführer für Advanced Analytics und KI-Software, eine Fallstudie gestartet.

In Zusammenarbeit mit der Dutch AI Coalition (NL AIC) untersuchten sie den Wert synthetischer Daten, indem sie KI-generierte synthetische Daten, die von der Syntho Engine generiert wurden, mit Originaldaten über verschiedene Bewertungen zu Datenqualität, Rechtsgültigkeit und Nutzbarkeit verglichen.

Ist Datenanonymisierung keine Lösung?

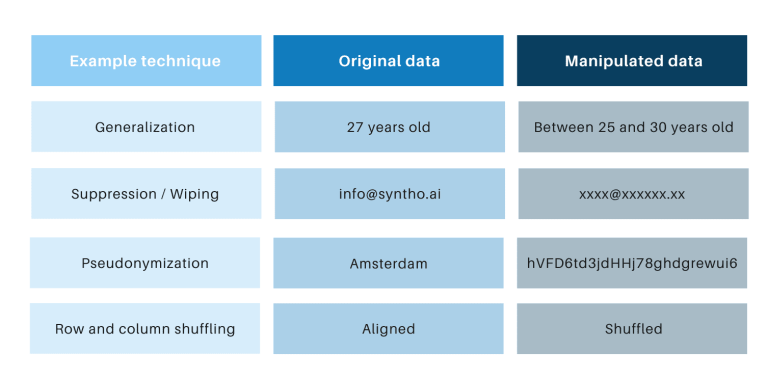

Klassische Anonymisierungstechniken haben gemeinsam, dass sie Originaldaten manipulieren, um die Rückverfolgung von Personen zu erschweren. Beispiele sind Generalisierung, Unterdrückung, Löschen, Pseudonymisierung, Datenmaskierung und Mischen von Zeilen und Spalten. Beispiele finden Sie in der folgenden Tabelle.

Diese Techniken bringen 3 zentrale Herausforderungen mit sich:

- Sie funktionieren je nach Datentyp und Datensatz unterschiedlich, wodurch sie schwer zu skalieren sind. Da sie außerdem unterschiedlich funktionieren, wird es immer Diskussionen darüber geben, welche Methoden anzuwenden sind und welche Kombination von Techniken erforderlich ist.

- Es besteht immer eine Eins-zu-Eins-Beziehung zu den Originaldaten. Dies bedeutet, dass es immer ein Datenschutzrisiko geben wird, insbesondere aufgrund aller offenen Datensätze und verfügbaren Techniken zur Verknüpfung dieser Datensätze.

- Sie manipulieren Daten und zerstören dabei Daten. Dies ist besonders verheerend für KI-Aufgaben, bei denen „Vorhersagekraft“ unerlässlich ist, da Daten von schlechter Qualität zu schlechten Erkenntnissen aus dem KI-Modell führen (Garbage-in führt zu Garbage-out).

Diese Punkte werden auch über diese Fallstudie bewertet.

Eine Einführung in die Fallstudie

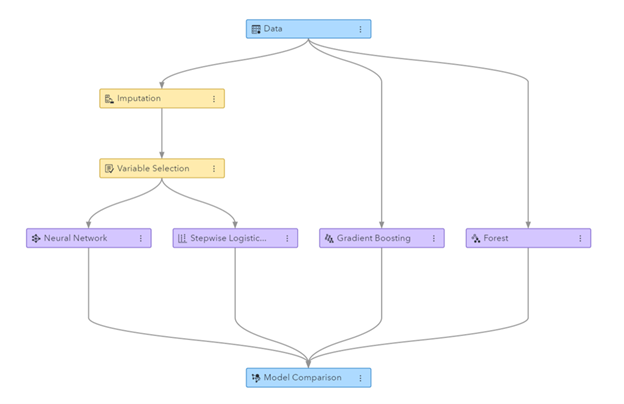

Für die Fallstudie war der Zieldatensatz ein von SAS bereitgestellter Telekommunikationsdatensatz mit den Daten von 56.600 Kunden. Der Datensatz enthält 128 Spalten, darunter eine Spalte, die angibt, ob ein Kunde das Unternehmen verlassen hat (dh „abgewandert“) ist oder nicht. Das Ziel der Fallstudie war es, die synthetischen Daten zu verwenden, um einige Modelle zu trainieren, um die Kundenabwanderung vorherzusagen, und die Leistung dieser trainierten Modelle zu bewerten. Da die Abwanderungsvorhersage eine Klassifizierungsaufgabe ist, hat SAS vier gängige Klassifizierungsmodelle ausgewählt, um die Vorhersagen zu treffen, darunter:

- Zufälliger Wald

- Steigungsverstärkung

- Logistische Regression

- Neurales Netzwerk

Vor der Generierung der synthetischen Daten teilte SAS den Telekom-Datensatz nach dem Zufallsprinzip in einen Train-Satz (zum Trainieren der Modelle) und einen Holdout-Satz (zum Scoring der Modelle). Ein separater Holdout-Satz für die Bewertung ermöglicht eine unvoreingenommene Bewertung der Leistung des Klassifizierungsmodells bei Anwendung auf neue Daten.

Unter Verwendung des Zugsatzes als Eingabe verwendete Syntho seine Syntho-Engine, um einen synthetischen Datensatz zu generieren. Für das Benchmarking erstellte SAS auch eine manipulierte Version des Zugsatzes, nachdem verschiedene Anonymisierungstechniken angewendet wurden, um einen bestimmten Schwellenwert (der k-Anonymität) zu erreichen. Die vorherigen Schritte führten zu vier Datensätzen:

- Ein Zugdatensatz (d. h. der Originaldatensatz abzüglich des Holdout-Datensatzes)

- Ein Holdout-Datensatz (dh eine Teilmenge des ursprünglichen Datensatzes)

- Ein anonymisierter Datensatz (basierend auf dem Zugdatensatz)

- Ein synthetischer Datensatz (basierend auf dem Zugdatensatz)

Die Datensätze 1, 3 und 4 wurden verwendet, um jedes Klassifizierungsmodell zu trainieren, was zu 12 (3 x 4) trainierten Modellen führte. SAS verwendete anschließend den Holdout-Datensatz, um die Genauigkeit zu messen, mit der jedes Modell die Kundenabwanderung vorhersagt. Die Ergebnisse werden unten präsentiert, beginnend mit einigen grundlegenden Statistiken.

Abbildung: Pipeline für maschinelles Lernen, die in SAS Visual Data Mining and Machine Learning generiert wurde

Grundlegende Statistiken beim Vergleich anonymisierter Daten mit Originaldaten

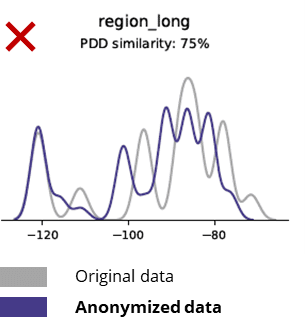

Anonymisierungstechniken zerstören sogar grundlegende Muster, Geschäftslogik, Beziehungen und Statistiken (wie im Beispiel unten). Die Verwendung anonymisierter Daten für grundlegende Analysen führt daher zu unzuverlässigen Ergebnissen. Tatsächlich machte es die schlechte Qualität der anonymisierten Daten fast unmöglich, sie für erweiterte Analyseaufgaben (z. B. KI/ML-Modellierung und Dashboarding) zu verwenden.

Grundlegende Statistiken beim Vergleich synthetischer Daten mit Originaldaten

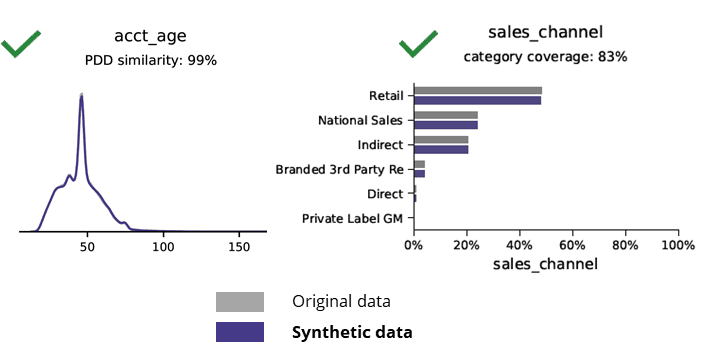

Die synthetische Datengenerierung mit KI bewahrt grundlegende Muster, Geschäftslogik, Beziehungen und Statistiken (wie im Beispiel unten). Die Verwendung synthetischer Daten für grundlegende Analysen führt somit zu zuverlässigen Ergebnissen. Schlüsselfrage: Halten synthetische Daten für erweiterte Analyseaufgaben (z. B. KI/ML-Modellierung und Dashboarding)?

KI-generierte synthetische Daten und fortschrittliche Analysen

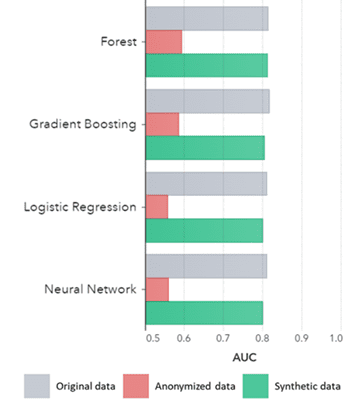

Synthetische Daten gelten nicht nur für grundlegende Muster (wie in den vorherigen Diagrammen gezeigt), sondern erfassen auch tief „versteckte“ statistische Muster, die für erweiterte Analyseaufgaben erforderlich sind. Letzteres wird im Balkendiagramm unten gezeigt, was darauf hinweist, dass die Genauigkeit von Modellen, die mit synthetischen Daten trainiert wurden, im Vergleich zu Modellen, die mit Originaldaten trainiert wurden, ähnlich ist. Darüber hinaus schneiden die auf anonymisierten Daten trainierten Modelle mit einer Fläche unter der Kurve (AUC*) nahe 0.5 bei weitem am schlechtesten ab. Der vollständige Bericht mit allen Advanced-Analytics-Bewertungen zu synthetischen Daten im Vergleich zu den Originaldaten ist auf Anfrage erhältlich.

*AUC: Die Fläche unter der Kurve ist ein Maß für die Genauigkeit von Advanced-Analytics-Modellen unter Berücksichtigung von Richtig-Positiven, Falsch-Positiven, Falsch-Negativen und Richtig-Negativen. 0,5 bedeutet, dass ein Modell zufällig vorhersagt und keine Vorhersagekraft hat, und 1 bedeutet, dass das Modell immer korrekt ist und die volle Vorhersagekraft hat.

Darüber hinaus können diese synthetischen Daten verwendet werden, um Dateneigenschaften und Hauptvariablen zu verstehen, die für das tatsächliche Training der Modelle benötigt werden. Die von den Algorithmen ausgewählten Eingaben für synthetische Daten im Vergleich zu Originaldaten waren sehr ähnlich. Daher kann der Modellierungsprozess auf dieser synthetischen Version durchgeführt werden, wodurch das Risiko von Datenschutzverletzungen reduziert wird. Beim Rückschluss auf einzelne Datensätze (z. B. TK-Kunde) empfiehlt sich jedoch ein Nachtrainieren auf Originaldaten zur Erklärbarkeit, erhöhten Akzeptanz oder auch nur aus regulatorischen Gründen.

AUC nach Algorithmus gruppiert nach Methode

Schlussfolgerungen:

- Modelle, die mit synthetischen Daten trainiert wurden, zeigen im Vergleich zu den Modellen, die mit Originaldaten trainiert wurden, eine sehr ähnliche Leistung

- Modelle, die auf anonymisierten Daten mit „klassischen Anonymisierungstechniken“ trainiert wurden, zeigen eine schlechtere Leistung im Vergleich zu Modellen, die auf den Originaldaten oder synthetischen Daten trainiert wurden

- Die Generierung synthetischer Daten ist einfach und schnell, da die Technik pro Datensatz und Datentyp genau gleich funktioniert.

Anwendungsfälle für wertschöpfende synthetische Daten

Anwendungsfall 1: Synthetische Daten für Modellentwicklung und Advanced Analytics

Eine starke Datengrundlage mit einfachem und schnellem Zugriff auf nutzbare, qualitativ hochwertige Daten ist für die Entwicklung von Modellen (z. B. Dashboards [BI] und Advanced Analytics [AI & ML]) unerlässlich. Viele Organisationen leiden jedoch unter einer suboptimalen Datengrundlage, was zu 3 zentralen Herausforderungen führt:

- Der Zugriff auf Daten dauert aufgrund von (Datenschutz-)Vorschriften, internen Prozessen oder Datensilos lange

- Klassische Anonymisierungstechniken zerstören Daten, wodurch die Daten nicht mehr für Analysen und Advanced Analytics geeignet sind (Garbage In = Garbage Out)

- Vorhandene Lösungen sind nicht skalierbar, da sie je nach Datensatz und Datentyp unterschiedlich funktionieren und große Datenbanken mit mehreren Tabellen nicht verarbeiten können

Synthetischer Datenansatz: Entwickeln Sie Modelle mit so gut wie realen synthetischen Daten, um:

- Minimieren Sie die Verwendung von Originaldaten, ohne Ihre Entwickler zu behindern

- Entsperren Sie persönliche Daten und haben Sie Zugriff auf mehr Daten, die zuvor eingeschränkt waren (z. B. aus Datenschutzgründen)

- Einfacher und schneller Datenzugriff auf relevante Daten

- Skalierbare Lösung, die für jeden Datensatz, Datentyp und für große Datenbanken gleich funktioniert

Dies ermöglicht es Unternehmen, eine starke Datengrundlage mit einfachem und schnellem Zugriff auf nutzbare, qualitativ hochwertige Daten aufzubauen, um Daten freizusetzen und Datenchancen zu nutzen.

Anwendungsfall 2: Intelligente synthetische Testdaten für Softwaretests, -entwicklung und -bereitstellung

Das Testen und Entwickeln mit qualitativ hochwertigen Testdaten ist für die Bereitstellung modernster Softwarelösungen unerlässlich. Die Verwendung originaler Produktionsdaten erscheint naheliegend, ist aber aufgrund von (Datenschutz-)Bestimmungen nicht erlaubt. Alternative Test Data Management (TDM)-Tools stellen „legacy-by-design“, um die Testdaten richtig zu machen:

- Produktionsdaten nicht widerspiegeln und Geschäftslogik und referenzielle Integrität werden nicht beibehalten

- Arbeiten Sie langsam und zeitaufwändig

- Handarbeit ist erforderlich

Synthetischer Datenansatz: Testen und entwickeln Sie mit KI-generierten synthetischen Testdaten, um hochmoderne Softwarelösungen bereitzustellen, die intelligent sind mit:

- Produktionsähnliche Daten mit erhaltener Geschäftslogik und referenzieller Integrität

- Einfache und schnelle Datengenerierung mit modernster KI

- Datenschutz durch Design

- Einfach, schnell und agile

Dies ermöglicht es Unternehmen, mit Testdaten der nächsten Stufe zu testen und zu entwickeln, um hochmoderne Softwarelösungen bereitzustellen!

Mehr Infos

Interessiert? Weitere Informationen zu synthetischen Daten erhalten Sie auf der Website von Syntho oder von Wim Kees Janssen. Weitere Informationen zu SAS finden Sie unter www.sas.com oder wenden Sie sich an kees@syntho.ai.

In diesem Anwendungsfall arbeiten Syntho, SAS und die NL AIC zusammen, um die beabsichtigten Ergebnisse zu erzielen. Syntho ist ein Experte für KI-generierte synthetische Daten und SAS ist ein Marktführer in der Analytik und bietet Software zum Erkunden, Analysieren und Visualisieren von Daten.

* Prognostiziert 2021 – Data and Analytics Strategies to Govern, Scale and Transform Digital Business, Gartner, 2020.

Speichern Sie jetzt Ihren Leitfaden für synthetische Daten!

- Was sind synthetische Daten?

- Warum nutzen Organisationen es?

- Kundenfälle mit Mehrwert für synthetische Daten

- Erste Schritte