Rate wer? 5 Beispiele, warum das Entfernen von Namen keine Option ist

Eine Einführung in Guess Who

Rate wer? Obwohl ich sicher bin, dass die meisten von euch dieses Spiel von früher kennen, hier eine kurze Zusammenfassung. Das Ziel des Spiels: Finden Sie den Namen der von Ihrem Gegner ausgewählten Zeichentrickfigur, indem Sie "Ja"- und "Nein"-Fragen stellen, wie "Trägt die Person einen Hut?" oder 'trägt die Person eine Brille'? Spieler eliminieren Kandidaten basierend auf der Reaktion des Gegners und lernen Attribute, die sich auf den mysteriösen Charakter ihres Gegners beziehen. Der erste Spieler, der den mysteriösen Charakter des anderen Spielers herausfindet, gewinnt das Spiel.

Du hast es. Man muss die Person aus einem Datensatz identifizieren, indem man nur Zugriff auf die entsprechenden Attribute hat. Tatsächlich sehen wir dieses Konzept von Guess Who regelmäßig in der Praxis angewendet, dann aber auf Datensätze angewendet, die mit Zeilen und Spalten formatiert sind, die Attribute realer Personen enthalten. Der Hauptunterschied bei der Arbeit mit Daten besteht darin, dass Menschen dazu neigen, die Leichtigkeit zu unterschätzen, mit der echte Personen durch den Zugriff auf nur wenige Attribute entlarvt werden können.

Wie das Guess Who-Spiel veranschaulicht, kann jemand Einzelpersonen identifizieren, indem er nur auf wenige Attribute Zugriff hat. Dies ist ein einfaches Beispiel dafür, warum das Entfernen von nur „Namen“ (oder anderen direkten Identifikatoren) aus Ihrem Datensatz als Anonymisierungstechnik fehlschlägt. In diesem Blog stellen wir Ihnen vier praktische Fälle vor, um Sie über die Datenschutzrisiken zu informieren, die mit dem Entfernen von Spalten als Mittel zur Datenanonymisierung verbunden sind.

2) Linkage-Angriffe: Ihr Datensatz ist mit anderen (öffentlichen) Datenquellen verknüpft

Die Gefahr eines Linkage-Angriffs ist der wichtigste Grund, warum das alleinige Entfernen von Namen als Methode zur Anonymisierung nicht (mehr) funktioniert. Bei einem Linkage-Angriff kombiniert der Angreifer die Originaldaten mit anderen zugänglichen Datenquellen, um eine Person eindeutig zu identifizieren und (oft sensible) Informationen über diese Person zu erfahren.

Entscheidend ist hier die Verfügbarkeit anderer Datenressourcen, die jetzt vorhanden sind oder in Zukunft vorhanden sein könnten. Denken Sie an sich. Wie viele Ihrer persönlichen Daten sind auf Facebook, Instagram oder LinkedIn zu finden, die potenziell für einen Linkage-Angriff missbraucht werden könnten?

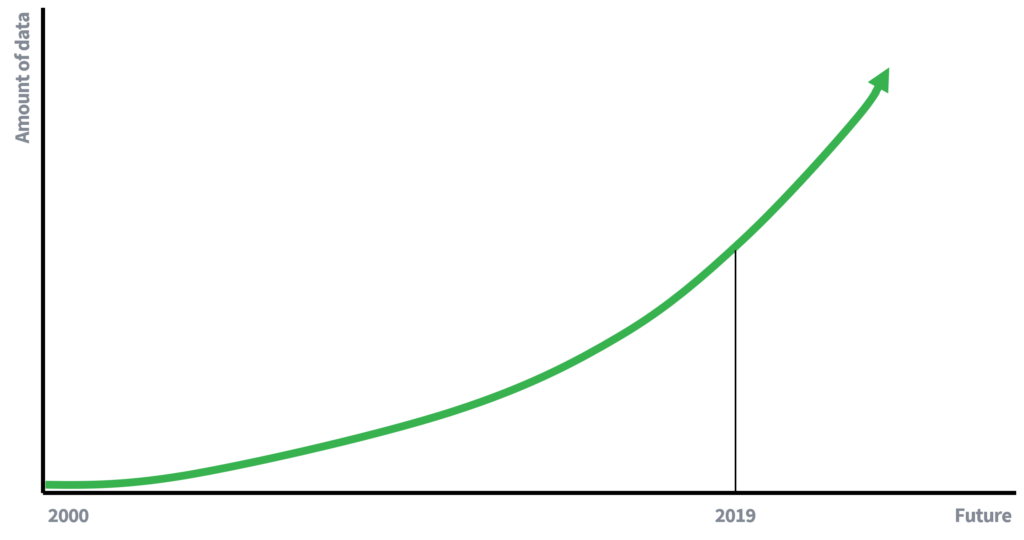

Früher war die Verfügbarkeit von Daten viel eingeschränkter, was zum Teil erklärt, warum die Entfernung von Namen ausreichte, um die Privatsphäre des Einzelnen zu wahren. Weniger verfügbare Daten bedeuten weniger Möglichkeiten zur Verknüpfung von Daten. Wir sind jedoch heute (aktive) Teilnehmer einer datengetriebenen Wirtschaft, in der die Datenmenge exponentiell wächst. Mehr Daten und eine verbesserte Technologie zum Sammeln von Daten werden zu einem erhöhten Potenzial für Linkage-Angriffe führen. Was würde man in 10 Jahren über das Risiko eines Linkage-Angriffs schreiben?

Abbildung 1

Exponentiell wachsende Daten sind eine Tatsache

Fallstudie

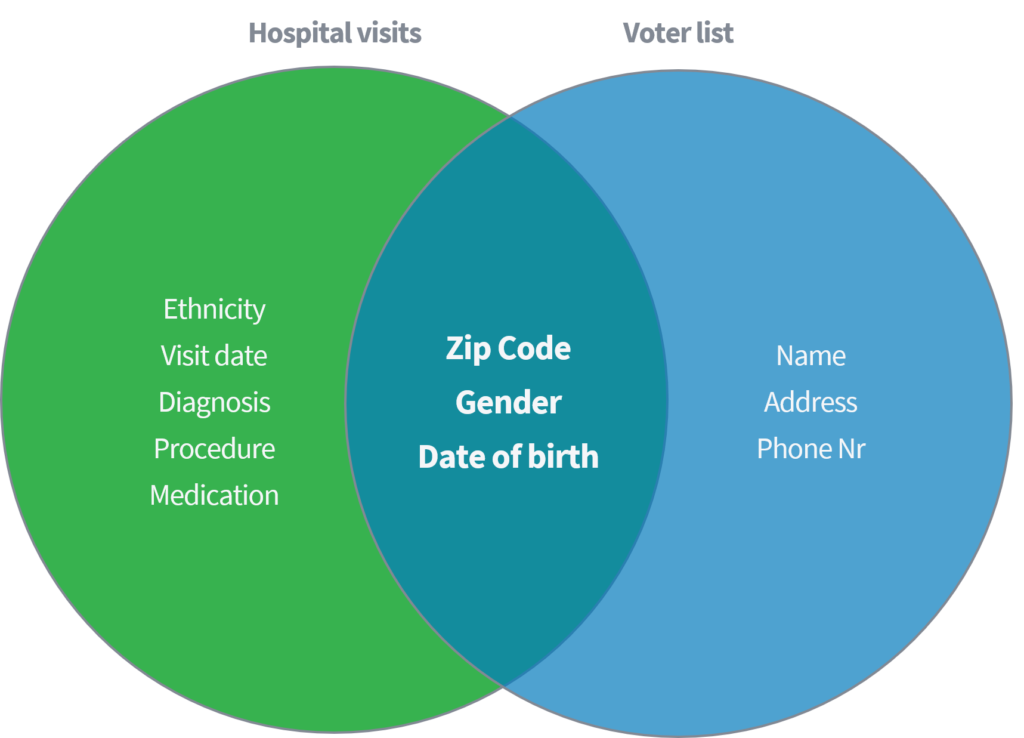

Sweeney (2002) demonstrierte in einer wissenschaftlichen Arbeit, wie sie sensible medizinische Daten von Einzelpersonen identifizieren und abrufen konnte, indem sie einen öffentlich verfügbaren Datensatz von „Krankenhausbesuchen“ mit dem öffentlich verfügbaren Wahlregister in den Vereinigten Staaten verknüpfte. Bei beiden Datensätzen wurde davon ausgegangen, dass sie durch das Löschen von Namen und anderen direkten Identifikatoren ordnungsgemäß anonymisiert wurden.

Abbildung 2

Linkage-Angriff in der Praxis

Basierend auf nur den drei Parametern (1) Postleitzahl, (2) Geschlecht und (3) Geburtsdatum zeigte sie, dass 87 % der gesamten US-Bevölkerung durch Abgleich der oben genannten Attribute aus beiden Datensätzen neu identifiziert werden konnten. Sweeney wiederholte dann ihre Arbeit mit "Land" als Alternative zu "Postleitzahl". Darüber hinaus zeigte sie, dass 18% der gesamten US-Bevölkerung nur durch den Zugriff auf einen Datensatz mit Informationen über (1) Heimatland, (2) Geschlecht und (3) Geburtsdatum identifiziert werden können. Denken Sie an die oben genannten öffentlichen Quellen wie Facebook, LinkedIn oder Instagram. Ist Ihr Land, Geschlecht und Geburtsdatum sichtbar oder können andere Nutzer dies abziehen?

Abbildung 3

Sweeneys Ergebnisse

| Quasi-Identifikatoren | % eindeutig identifiziert der US-Bevölkerung (248 Millionen) |

| 5-stellige PLZ, Geschlecht, Geburtsdatum | 87% |

| Ort, Geschlecht, Geburtsdatum | 53% |

| Land, Geschlecht, Geburtsdatum | 18% |

Dieses Beispiel zeigt, dass es bemerkenswert einfach sein kann, Einzelpersonen in scheinbar anonymen Daten zu deanonymisieren. Erstens weist diese Studie auf ein enormes Risiko hin, da 87 % der US-Bevölkerung können anhand von . leicht identifiziert werden wenige Eigenschaften. Zweitens waren die exponierten medizinischen Daten in dieser Studie hochsensibel. Beispiele für Daten exponierter Personen aus dem Datensatz zu Krankenhausbesuchen umfassen ethnische Zugehörigkeit, Diagnose und Medikation. Attribute, die man zum Beispiel vor Versicherungen lieber geheim halten darf.

3) Informierte Personen

Ein weiteres Risiko, nur direkte Identifikatoren wie Namen zu entfernen, entsteht, wenn informierte Personen über bessere Kenntnisse oder Informationen über Merkmale oder Verhaltensweisen bestimmter Personen im Datensatz verfügen. Der Angreifer kann dann aufgrund seines Wissens bestimmte Datensätze mit realen Personen in Verbindung bringen.

Fallstudie

Ein Beispiel für einen Angriff auf einen Datensatz mit überlegenem Wissen ist der Taxifall in New York, bei dem Atockar (2014) bestimmte Personen enttarnen konnte. Der verwendete Datensatz enthielt alle Taxifahrten in New York, angereichert mit Basisattributen wie Startkoordinaten, Endkoordinaten, Preis und Tipp der Fahrt.

Eine informierte Person, die New York kennt, konnte Taxifahrten zum Erwachsenenclub „Hustler“ ableiten. Durch die Filterung des „Endortes“ leitete er die genauen Startadressen ab und identifizierte so verschiedene häufige Besucher. Ebenso könnte man auf Taxifahrten schließen, wenn die Wohnadresse der Person bekannt war. Die Zeit und der Standort mehrerer berühmter Filmstars wurden auf Klatschseiten entdeckt. Nachdem diese Informationen mit den NYC-Taxidaten verknüpft wurden, war es einfach, ihre Taxifahrten, den bezahlten Betrag und das Trinkgeld abzuleiten.

Abbildung 4

Eine informierte Person

Abgabekoordinaten Hustler

Bradley Cooper

Jessica Alba

4) Daten als Fingerabdruck

Eine gängige Argumentation ist „diese Daten sind wertlos“ oder „niemand kann mit diesen Daten etwas anfangen“. Dies ist oft ein Missverständnis. Selbst die harmlosesten Daten können einen einzigartigen „Fingerabdruck“ bilden und zur Neuidentifizierung von Personen verwendet werden. Es ist das Risiko, das sich aus der Annahme ergibt, dass die Daten selbst wertlos sind, obwohl dies nicht der Fall ist.

Das Identifikationsrisiko wird mit der Zunahme von Daten, KI und anderen Tools und Algorithmen steigen, die das Aufdecken komplexer Zusammenhänge in Daten ermöglichen. Folglich kann Ihr Datensatz, auch wenn er heute nicht aufgedeckt werden kann und für Unbefugte vermutlich nutzlos ist, morgen nicht mehr sein.

Fallstudie

Ein gutes Beispiel ist der Fall, in dem Netflix beabsichtigte, seine Forschungs- und Entwicklungsabteilung durch die Einführung eines offenen Netflix-Wettbewerbs zu vertreiben, um sein Filmempfehlungssystem zu verbessern. "Derjenige, der den kollaborativen Filteralgorithmus verbessert, um Benutzerbewertungen für Filme vorherzusagen, gewinnt einen Preis von 1,000,000 US-Dollar". Um die Crowd zu unterstützen, hat Netflix einen Datensatz veröffentlicht, der nur die folgenden grundlegenden Attribute enthält: Benutzer-ID, Film, Datum der Note und Note (also keine weiteren Informationen zum Benutzer oder zum Film selbst).

Abbildung 5

Datensatzstruktur Netflix-Preis

| Benutzeridentifikation | Film | Datum der Note | Klasse |

| 123456789 | Mission impossible | 10-12-2008 | 4 |

Isoliert erschienen die Daten nutzlos. Auf die Frage „Gibt es Kundeninformationen im Datensatz, die privat bleiben sollten?“ lautete die Antwort:

'Nein, alle Informationen zur Kundenidentifikation wurden entfernt; Was bleibt, sind Bewertungen und Daten. Dies folgt unserer Datenschutzerklärung …'

Allerdings bewies Narayanan (2008) von der University of Texas at Austin das Gegenteil. Die Kombination aus Noten, Notendatum und Film einer Person bildet einen einzigartigen Film-Fingerabdruck. Denken Sie an Ihr eigenes Netflix-Verhalten. Wie viele Leute haben Ihrer Meinung nach die gleichen Filme gesehen? Wie viele haben sich gleichzeitig die gleichen Filme angesehen?

Hauptfrage, wie man diesen Fingerabdruck abgleicht? Es war ziemlich einfach. Basierend auf Informationen der bekannten Filmbewertungswebsite IMDb (Internet Movie Database) könnte ein ähnlicher Fingerabdruck gebildet werden. Folglich könnten Personen erneut identifiziert werden.

Auch wenn das Verhalten beim Ansehen von Filmen möglicherweise nicht als sensible Information gilt, denken Sie doch an Ihr eigenes Verhalten – würde es Ihnen etwas ausmachen, wenn es an die Öffentlichkeit geht? Beispiele, die Narayanan in seinem Artikel anführte, sind politische Präferenzen (Bewertungen zu „Jesus von Nazareth“ und „Das Johannesevangelium“) und sexuelle Vorlieben (Bewertungen zu „Bent“ und „Queer as folk“), die leicht destilliert werden könnten.

5) Datenschutz-Grundverordnung (DSGVO)

Die DSGVO ist vielleicht nicht besonders aufregend und auch nicht das Allheilmittel unter den Blog-Themen. Es ist jedoch hilfreich, die Definitionen bei der Verarbeitung personenbezogener Daten zu klären. Da es in diesem Blog um das weit verbreitete Missverständnis geht, Spalten zu entfernen, um Daten zu anonymisieren und Sie als Datenverarbeiter zu schulen, lassen Sie uns mit der Definition der Anonymisierung gemäß der DSGVO beginnen.

Gemäß Erwägungsgrund 26 der DSGVO sind anonymisierte Informationen definiert als:

„Informationen, die sich nicht auf eine identifizierte oder identifizierbare natürliche Person beziehen, oder personenbezogene Daten, die derart anonymisiert wurden, dass die betroffene Person nicht oder nicht mehr bestimmbar ist.“

Da man personenbezogene Daten verarbeitet, die sich auf eine natürliche Person beziehen, ist nur Teil 2 der Definition relevant. Um der Definition zu entsprechen, muss sichergestellt werden, dass die betroffene Person (Einzelperson) nicht oder nicht mehr identifizierbar ist. Wie in diesem Blog erwähnt, ist es jedoch bemerkenswert einfach, Einzelpersonen anhand einiger weniger Merkmale zu identifizieren. Das Entfernen von Namen aus einem Datensatz entspricht daher nicht der DSGVO-Definition der Anonymisierung.

Abschließend

Wir haben einen allgemein betrachteten und leider immer noch häufig angewendeten Ansatz der Datenanonymisierung in Frage gestellt: das Entfernen von Namen. Im Guess Who-Spiel und vier weiteren Beispielen zu:

- Verknüpfungsangriffe

- Informierte Personen

- Daten als Fingerabdruck

- Allgemeine Datenschutzverordnung (GDPR/DSGVO)

es hat sich gezeigt, dass das Entfernen von Namen als Anonymisierung fehlschlägt. Obwohl die Beispiele auffallende Fälle sind, zeigt jedes die Einfachheit der Re-Identifikation und die möglichen negativen Auswirkungen auf die Privatsphäre von Personen.

Zusammenfassend führt die Entfernung von Namen aus Ihrem Datensatz nicht zu anonymen Daten. Daher vermeiden wir es besser, beide Begriffe synonym zu verwenden. Ich hoffe aufrichtig, dass Sie diesen Ansatz nicht für die Anonymisierung anwenden. Und wenn Sie dies dennoch tun, stellen Sie sicher, dass Sie und Ihr Team die Datenschutzrisiken vollständig verstehen und diese Risiken im Namen der betroffenen Personen akzeptieren dürfen.

Daten sind synthetisch, aber unser Team ist real!

Kontakt aufnehmen und einer unserer Experten wird sich blitzschnell mit Ihnen in Verbindung setzen, um den Wert synthetischer Daten zu erkunden!

- D. Reinsel, J. Gantz, John Rydning. Die Digitalisierung der Welt vom Edge zum Core, Data Age 2025, 2018

- L. Sweeney. k-Anonymität: ein Modell zum Schutz der Privatsphäre. International Journal on Uncertainty, Fuzziness and Knowledge-based Systems, 10 (5), 2002: 557-570

- L. Sweeney. Einfache demografische Merkmale identifizieren Menschen oft eindeutig. Carnegie Mellon University, Datenschutz-Arbeitspapier 3. Pittsburgh 2000

- P. Samarati. Schutz der Identität der Befragten bei der Mikrodatenfreigabe. IEEE Transactions on Knowledge and Data Engineering, 13 (6), 2001: 1010-1027

- Atockar. Mit den Sternen fahren: Privatsphäre der Passagiere im NYC Taxicab Dataset, 2014

- Narayanan, A., & Shmatikov, V. (2008). Robuste De-Anonymisierung großer spärlicher Datensätze. In Proceedings – 2008 IEEE Symposium on Security and Privacy, SP (S. 111-125)

- Datenschutz-Grundverordnung (DSGVO), Erwägungsgrund 26, gilt nicht für anonyme Daten