Syntetyczne dane generowane przez sztuczną inteligencję, łatwy i szybki dostęp do danych wysokiej jakości?

Dane syntetyczne generowane przez sztuczną inteligencję w praktyce

Syntho, ekspert w dziedzinie danych syntetycznych generowanych przez sztuczną inteligencję, ma na celu zmianę privacy by design zyskać przewagę konkurencyjną dzięki syntetycznym danym generowanym przez sztuczną inteligencję. Pomagają organizacjom w budowaniu silnej bazy danych z łatwym i szybkim dostępem do wysokiej jakości danych, a ostatnio zdobyli nagrodę Philips Innovation Award.

Jednak generowanie danych syntetycznych za pomocą sztucznej inteligencji jest stosunkowo nowym rozwiązaniem, które zazwyczaj wprowadza często zadawane pytania. Aby odpowiedzieć na te pytania, Syntho wraz z SAS, liderem rynku zaawansowanego oprogramowania analitycznego i sztucznej inteligencji, rozpoczęło studium przypadku.

We współpracy z holenderską koalicją AI (NL AIC) zbadali wartość danych syntetycznych, porównując wygenerowane przez sztuczną inteligencję dane syntetyczne wygenerowane przez silnik Syntho z danymi oryginalnymi za pomocą różnych ocen jakości danych, ważności prawnej i użyteczności.

Czy anonimizacja danych nie jest rozwiązaniem?

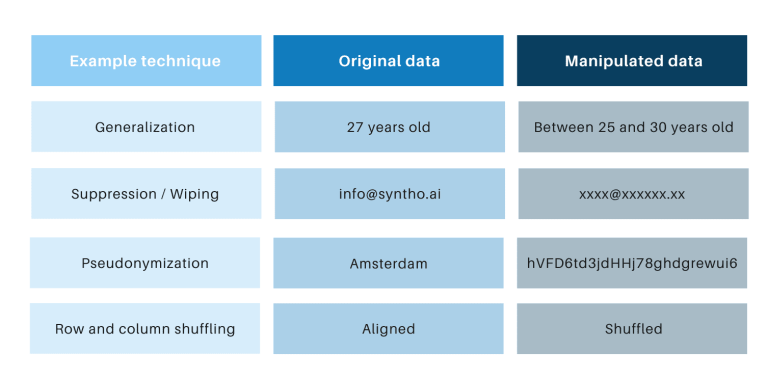

Klasyczne techniki anonimizacji mają tę wspólną cechę, że manipulują oryginalnymi danymi, aby utrudnić śledzenie osób. Przykładami są generalizacja, tłumienie, wymazywanie, pseudonimizacja, maskowanie danych oraz tasowanie wierszy i kolumn. Przykłady znajdziesz w poniższej tabeli.

Techniki te wprowadzają 3 kluczowe wyzwania:

- Działają inaczej w zależności od typu danych i zestawu danych, co utrudnia ich skalowanie. Co więcej, ponieważ działają one inaczej, zawsze będzie dyskusja na temat tego, jakie metody zastosować i jaka kombinacja technik jest potrzebna.

- Zawsze istnieje relacja jeden do jednego z oryginalnymi danymi. Oznacza to, że zawsze będzie istniało zagrożenie prywatności, zwłaszcza ze względu na wszystkie otwarte zbiory danych i dostępne techniki łączenia tych zbiorów danych.

- Manipulują danymi, a tym samym niszczą dane w procesie. Jest to szczególnie niszczycielskie w przypadku zadań AI, w których „moc predykcyjna” jest niezbędna, ponieważ dane o złej jakości spowodują złe spostrzeżenia z modelu AI (wprowadzenie śmieci spowoduje wyrzucenie śmieci).

Punkty te są również oceniane na podstawie tego studium przypadku.

Wprowadzenie do studium przypadku

W przypadku studium przypadku docelowym zbiorem danych był zbiór danych telekomunikacyjnych dostarczony przez SAS, zawierający dane 56.600 klientów. Zestaw danych zawiera 128 kolumn, w tym jedną kolumnę wskazującą, czy klient opuścił firmę (tj. „odszedł”), czy nie. Celem studium przypadku było wykorzystanie danych syntetycznych do trenowania niektórych modeli w celu przewidywania rezygnacji klientów i oceny wydajności tych trenowanych modeli. Ponieważ przewidywanie rezygnacji jest zadaniem klasyfikacyjnym, SAS wybrał cztery popularne modele klasyfikacji do tworzenia przewidywań, w tym:

- Losowy las

- Wzmocnienie gradientu

- Regresja logistyczna

- Sieć neuronowa

Przed wygenerowaniem danych syntetycznych SAS losowo podzielił zbiór danych telekomunikacyjnych na zestaw pociągów (w celu uczenia modeli) i zestaw wstrzymania (w celu oceny modeli). Posiadanie oddzielnego zestawu wstrzymań do oceniania pozwala na obiektywną ocenę tego, jak dobrze model klasyfikacji może działać po zastosowaniu do nowych danych.

Używając zestawu pociągów jako danych wejściowych, Syntho użyło swojego silnika Syntho do wygenerowania syntetycznego zestawu danych. Na potrzeby analizy porównawczej SAS stworzył również zmanipulowaną wersję składu pociągu po zastosowaniu różnych technik anonimizacji w celu osiągnięcia określonego progu (k-anonimowości). Poprzednie kroki zaowocowały czterema zestawami danych:

- Zbiór danych pociągu (tj. oryginalny zbiór danych bez zbioru danych o wstrzymaniu)

- Zbiór danych wstrzymanych (tj. podzbiór oryginalnego zbioru danych)

- Zanonimizowany zbiór danych (na podstawie zbioru danych pociągu)

- Syntetyczny zbiór danych (na podstawie zbioru danych pociągu)

Zestawy danych 1, 3 i 4 zostały użyte do trenowania każdego modelu klasyfikacji, w wyniku czego powstało 12 (3 x 4) modeli trenowanych. SAS następnie wykorzystał zestaw danych o wstrzymaniu, aby zmierzyć dokładność, z jaką każdy model przewiduje odejście klientów. Wyniki przedstawiono poniżej, zaczynając od podstawowych statystyk.

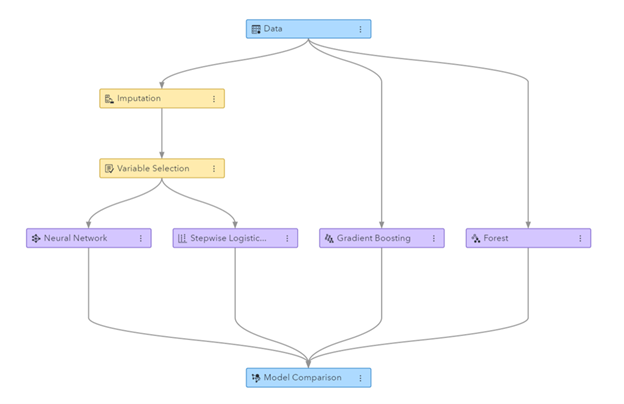

Rysunek: Potok uczenia maszynowego wygenerowany w SAS Visual Data Mining i uczeniu maszynowym

Podstawowe statystyki przy porównywaniu danych anonimowych z danymi oryginalnymi

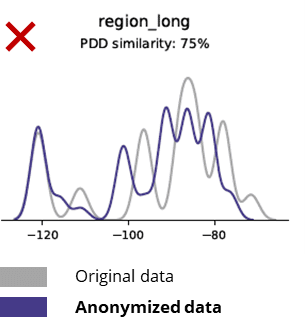

Techniki anonimizacji niszczą nawet podstawowe wzorce, logikę biznesową, relacje i statystyki (jak w poniższym przykładzie). Używanie anonimowych danych do podstawowych analiz daje zatem niewiarygodne wyniki. W rzeczywistości słaba jakość zanonimizowanych danych praktycznie uniemożliwiła wykorzystanie ich do zaawansowanych zadań analitycznych (np. modelowanie AI/ML i dashboarding).

Podstawowe statystyki przy porównywaniu danych syntetycznych z danymi oryginalnymi

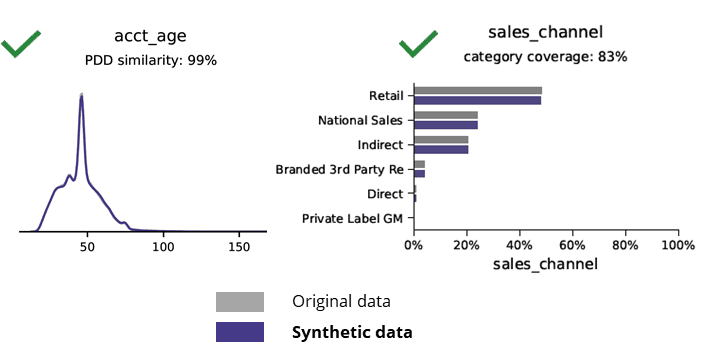

Generowanie danych syntetycznych za pomocą AI zachowuje podstawowe wzorce, logikę biznesową, relacje i statystyki (jak w poniższym przykładzie). Wykorzystanie danych syntetycznych do podstawowych analiz daje zatem wiarygodne wyniki. Kluczowe pytanie, czy dane syntetyczne są przechowywane dla zaawansowanych zadań analitycznych (np. modelowanie AI/ML i dashboarding)?

Syntetyczne dane generowane przez sztuczną inteligencję i zaawansowana analityka

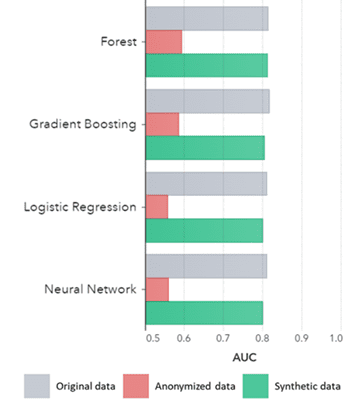

Dane syntetyczne zawierają nie tylko podstawowe wzorce (jak pokazano na poprzednich wykresach), ale także przechwytują głębokie „ukryte” wzorce statystyczne wymagane do zaawansowanych zadań analitycznych. To ostatnie przedstawiono na poniższym wykresie słupkowym, wskazującym, że dokładność modeli wyszkolonych na danych syntetycznych w porównaniu z modelami wyszkolonymi na danych oryginalnych jest podobna. Co więcej, przy obszarze pod krzywą (AUC*) bliskim 0.5 modele wytrenowane na danych anonimowych radzą sobie zdecydowanie najgorzej. Pełny raport ze wszystkimi zaawansowanymi ocenami analitycznymi na danych syntetycznych w porównaniu z danymi oryginalnymi jest dostępny na żądanie.

*AUC: obszar pod krzywą jest miarą dokładności modeli zaawansowanej analityki, z uwzględnieniem wyników prawdziwie pozytywnych, fałszywie pozytywnych, fałszywie negatywnych i prawdziwie negatywnych. 0,5 oznacza, że model przewiduje losowo i nie ma mocy predykcyjnej, a 1 oznacza, że model jest zawsze poprawny i ma pełną moc predykcyjną.

Ponadto te syntetyczne dane można wykorzystać do zrozumienia cech danych i głównych zmiennych potrzebnych do rzeczywistego uczenia modeli. Dane wejściowe wybrane przez algorytmy na danych syntetycznych w porównaniu z danymi oryginalnymi były bardzo podobne. W związku z tym proces modelowania można przeprowadzić na tej syntetycznej wersji, co zmniejsza ryzyko naruszenia danych. Jednak w przypadku wnioskowania o poszczególnych rekordach (np. klienta telekomunikacyjnego) zaleca się przeszkolenie na oryginalnych danych w celu wyjaśnienia, większej akceptacji lub po prostu z powodu przepisów.

AUC według algorytmu pogrupowane według metody

Wnioski:

- Modele wytrenowane na danych syntetycznych w porównaniu z modelami wyszkolonymi na oryginalnych danych wykazują bardzo podobną wydajność

- Modele wytrenowane na danych zanonimizowanych za pomocą „klasycznych technik anonimizacji” wykazują niższą wydajność w porównaniu z modelami wytrenowanymi na danych oryginalnych lub danych syntetycznych

- Generowanie danych syntetycznych jest łatwe i szybkie, ponieważ technika działa dokładnie tak samo dla zestawu danych i typu danych.

Przypadki użycia danych syntetycznych o wartości dodanej

Przypadek użycia 1: Dane syntetyczne do tworzenia modeli i zaawansowanej analityki

Posiadanie silnego fundamentu danych z łatwym i szybkim dostępem do użytecznych danych wysokiej jakości jest niezbędne do tworzenia modeli (np. pulpitów nawigacyjnych [BI] i zaawansowanej analityki [AI i ML]). Jednak wiele organizacji cierpi z powodu nieoptymalnej bazy danych, co skutkuje 3 kluczowymi wyzwaniami:

- Uzyskanie dostępu do danych trwa wieki ze względu na regulacje (prywatności), wewnętrzne procesy lub silosy danych

- Klasyczne techniki anonimizacji niszczą dane, dzięki czemu nie nadają się już do analizy i zaawansowanej analizy (śmieci wchodzące = śmieci wychodzące)

- Istniejące rozwiązania nie są skalowalne, ponieważ działają inaczej w zależności od zestawu danych i typu danych i nie mogą obsługiwać dużych wielotabelowych baz danych

Podejście do danych syntetycznych: opracuj modele z tak dobrymi jak rzeczywiste danymi syntetycznymi, aby:

- Zminimalizuj wykorzystanie oryginalnych danych, nie przeszkadzając programistom

- Odblokuj dane osobowe i uzyskaj dostęp do większej ilości danych, które były wcześniej ograniczone (np. ze względu na prywatność)

- Łatwy i szybki dostęp do odpowiednich danych

- Skalowalne rozwiązanie, które działa tak samo dla każdego zestawu danych, typu danych i ogromnych baz danych

Pozwala to organizacji zbudować solidną podstawę danych z łatwym i szybkim dostępem do użytecznych danych wysokiej jakości w celu odblokowania danych i wykorzystania możliwości związanych z danymi.

Przypadek użycia 2: inteligentne syntetyczne dane testowe do testowania, opracowywania i dostarczania oprogramowania

Testowanie i rozwój z wykorzystaniem wysokiej jakości danych testowych jest niezbędne do dostarczania najnowocześniejszych rozwiązań programowych. Korzystanie z oryginalnych danych produkcyjnych wydaje się oczywiste, ale nie jest dozwolone ze względu na przepisy (prywatność). Alternatywny Test Data Management (TDM) narzędzia wprowadzają „legacy-by-design” w uzyskaniu prawidłowych danych testowych:

- Nie odzwierciedlają danych produkcyjnych, a logika biznesowa i integralność referencyjna nie są zachowywane

- Pracuj wolno i czasochłonnie

- Wymagana jest praca ręczna

Podejście do danych syntetycznych: Testuj i rozwijaj za pomocą syntetycznych danych testowych generowanych przez sztuczną inteligencję, aby dostarczać najnowocześniejsze rozwiązania programowe, inteligentne dzięki:

- Dane o charakterze produkcyjnym z zachowaną logiką biznesową i integralnością referencyjną

- Łatwe i szybkie generowanie danych dzięki najnowocześniejszej sztucznej inteligencji

- Prywatność według projektu

- Łatwo, szybko i agile

Dzięki temu organizacja może testować i rozwijać się z danymi testowymi następnego poziomu, aby dostarczać najnowocześniejsze rozwiązania programowe!

Więcej informacji

Zainteresowany? Aby uzyskać więcej informacji na temat danych syntetycznych, odwiedź stronę internetową Syntho lub skontaktuj się z Wim Kees Janssen. Aby uzyskać więcej informacji o SAS, odwiedź www.sas.com lub skontaktuj się z kees@syntho.ai.

W takim przypadku Syntho, SAS i NL AIC współpracują ze sobą, aby osiągnąć zamierzone wyniki. Syntho jest ekspertem w dziedzinie danych syntetycznych generowanych przez sztuczną inteligencję, a SAS jest liderem na rynku analiz i oferuje oprogramowanie do eksploracji, analizy i wizualizacji danych.

* Przewiduje rok 2021 – Strategie danych i analiz służące zarządzaniu, skalowaniu i przekształcaniu cyfrowego biznesu, Gartner, 2020.

Zapisz teraz swój przewodnik po danych syntetycznych!

- Co to są dane syntetyczne?

- Dlaczego organizacje z niego korzystają?

- Przypadki klientów z danymi syntetycznymi o wartości dodanej

- Jak zacząć