AI-genererede syntetiske data, nem og hurtig adgang til data af høj kvalitet?

AI genererede syntetiske data i praksis

Syntho, en ekspert i AI-genererede syntetiske data, sigter mod at vende privacy by design til en konkurrencefordel med AI-genererede syntetiske data. De hjælper organisationer med at opbygge et stærkt datagrundlag med nem og hurtig adgang til data af høj kvalitet og vandt for nylig Philips Innovation Award.

Syntetisk datagenerering med AI er dog en relativt ny løsning, der typisk introducerer ofte stillede spørgsmål. For at besvare disse startede Syntho et case-studie sammen med SAS, markedsleder inden for Advanced Analytics og AI-software.

I samarbejde med den hollandske AI Coalition (NL AIC) undersøgte de værdien af syntetiske data ved at sammenligne AI-genererede syntetiske data genereret af Syntho Engine med originale data via forskellige vurderinger af datakvalitet, juridisk gyldighed og anvendelighed.

Er dataanonymisering ikke en løsning?

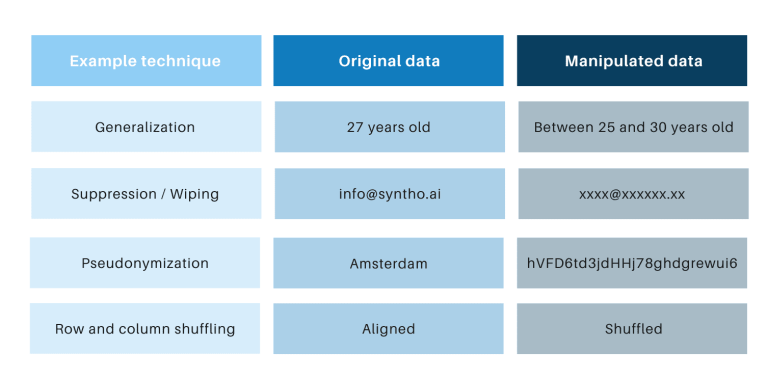

Klassiske anonymiseringsteknikker har det til fælles, at de manipulerer originale data for at forhindre sporing af individer. Eksempler er generalisering, undertrykkelse, sletning, pseudonymisering, datamaskering og blanding af rækker og kolonner. Du kan finde eksempler i tabellen nedenfor.

Disse teknikker introducerer 3 nøgleudfordringer:

- De fungerer forskelligt pr. datatype og pr. datasæt, hvilket gør dem svære at skalere. Da de fungerer forskelligt, vil der desuden altid være debat om, hvilke metoder der skal anvendes, og hvilken kombination af teknikker der er behov for.

- Der er altid et en-til-en forhold til de originale data. Det betyder, at der altid vil være en privatlivsrisiko, især på grund af alle åbne datasæt og tilgængelige teknikker til at forbinde disse datasæt.

- De manipulerer data og ødelægger derved data i processen. Dette er især ødelæggende for AI-opgaver, hvor "forudsigelseskraft" er afgørende, fordi data af dårlig kvalitet vil resultere i dårlig indsigt fra AI-modellen (Garbage-in vil resultere i garbage-out).

Disse punkter vurderes også via dette casestudie.

En introduktion til casestudiet

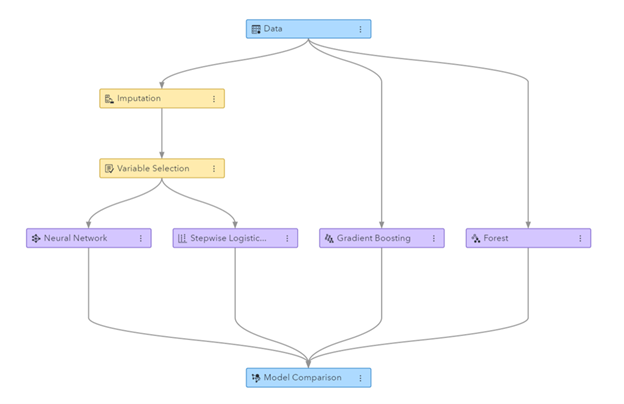

Til casestudiet var måldatasættet et teledatasæt leveret af SAS, der indeholdt data fra 56.600 kunder. Datasættet indeholder 128 kolonner, heraf en kolonne, der angiver, om en kunde har forladt virksomheden (dvs. 'churned') eller ej. Målet med casestudiet var at bruge de syntetiske data til at træne nogle modeller til at forudsige kundeafgang og til at evaluere ydeevnen af disse trænede modeller. Da churn-forudsigelse er en klassifikationsopgave, valgte SAS fire populære klassifikationsmodeller til at lave forudsigelserne, herunder:

- Tilfældig skov

- Gradientboosting

- Logistisk regression

- Neuralt netværk

Før generering af de syntetiske data opdelte SAS tilfældigt teledatasættet i et togsæt (til træning af modellerne) og et holdout-sæt (til scoring af modellerne). At have et separat holdout-sæt til scoring giver mulighed for en uvildig vurdering af, hvor godt klassifikationsmodellen kan præstere, når den anvendes på nye data.

Ved at bruge togsættet som input brugte Syntho sin Syntho Engine til at generere et syntetisk datasæt. Til benchmarking skabte SAS også en manipuleret version af togsættet efter at have anvendt forskellige anonymiseringsteknikker for at nå en vis tærskel (af k-anonimitet). De tidligere trin resulterede i fire datasæt:

- Et togdatasæt (dvs. det originale datasæt minus holdoutdatasættet)

- Et holdout-datasæt (dvs. en delmængde af det originale datasæt)

- Et anonymiseret datasæt (baseret på togdatasættet)

- Et syntetisk datasæt (baseret på togdatasættet)

Datasæt 1, 3 og 4 blev brugt til at træne hver klassifikationsmodel, hvilket resulterede i 12 (3 x 4) trænede modeller. SAS brugte efterfølgende holdout-datasættet til at måle den nøjagtighed, hvormed hver model forudsiger kundeafgang. Resultaterne er præsenteret nedenfor, begyndende med nogle grundlæggende statistikker.

Figur: Machine Learning pipeline genereret i SAS Visual Data Mining og Machine Learning

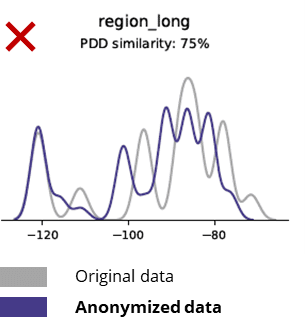

Grundlæggende statistik ved sammenligning af anonymiserede data med originale data

Anonymiseringsteknikker ødelægger selv grundlæggende mønstre, forretningslogik, relationer og statistik (som i eksemplet nedenfor). Brug af anonymiserede data til grundlæggende analyser giver således upålidelige resultater. Faktisk gjorde den ringe kvalitet af de anonymiserede data det næsten umuligt at bruge dem til avancerede analyseopgaver (f.eks. AI/ML-modellering og dashboarding).

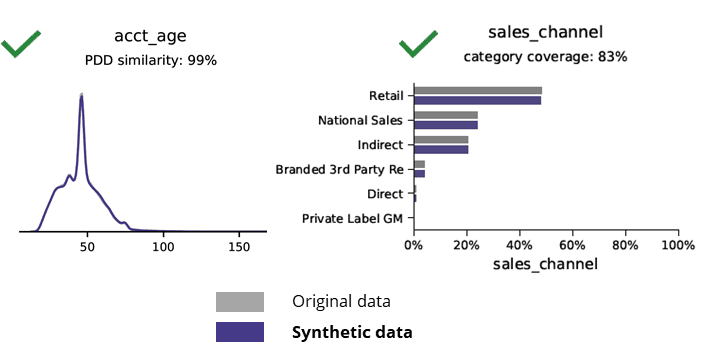

Grundlæggende statistik ved sammenligning af syntetiske data med originale data

Syntetisk datagenerering med AI bevarer grundlæggende mønstre, forretningslogik, relationer og statistik (som i eksemplet nedenfor). Brug af syntetiske data til grundlæggende analyser giver således pålidelige resultater. Nøglespørgsmål, holder syntetiske data for avancerede analyseopgaver (f.eks. AI/ML-modellering og dashboarding)?

AI-genererede syntetiske data og avancerede analyser

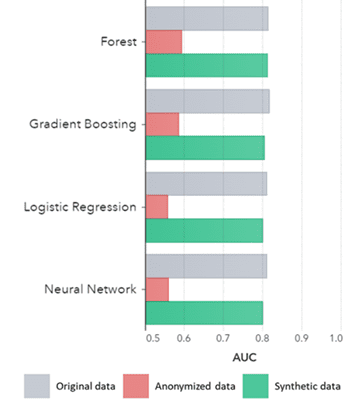

Syntetiske data gælder ikke kun for grundlæggende mønstre (som vist i de tidligere plots), de fanger også dybe 'skjulte' statistiske mønstre, der kræves til avancerede analyseopgaver. Sidstnævnte er demonstreret i søjlediagrammet nedenfor, hvilket indikerer, at nøjagtigheden af modeller trænet på syntetiske data versus modeller trænet på originale data er ens. Ydermere, med et område under kurven (AUC*) tæt på 0.5, klarer de modeller, der er trænet på anonymiserede data, sig langt dårligst. Den fulde rapport med alle avancerede analysevurderinger af syntetiske data i sammenligning med de originale data er tilgængelig på anmodning.

*AUC: arealet under kurven er et mål for nøjagtigheden af avancerede analysemodeller, idet der tages højde for sande positive, falske positive, falske negative og sande negative. 0,5 betyder, at en model forudsiger tilfældigt og ikke har nogen forudsigelseskraft, og 1 betyder, at modellen altid er korrekt og har fuld forudsigelseskraft.

Derudover kan disse syntetiske data bruges til at forstå datakarakteristika og hovedvariabler, der er nødvendige for egentlig træning af modellerne. De input, der blev valgt af algoritmerne på syntetiske data sammenlignet med originale data, var meget ens. Derfor kan modelleringsprocessen udføres på denne syntetiske version, hvilket reducerer risikoen for databrud. Men når man udleder individuelle poster (f.eks. telco-kunder), anbefales det at genoptræne originale data for forklaring, øget accept eller blot på grund af regulering.

AUC efter algoritme grupperet efter metode

Konklusioner:

- Modeller trænet på syntetiske data sammenlignet med modeller trænet på originale data viser meget lignende ydeevne

- Modeller trænet på anonymiserede data med 'klassiske anonymiseringsteknikker' viser ringere ydeevne sammenlignet med modeller trænet på de originale data eller syntetiske data

- Syntetisk datagenerering er let og hurtig, fordi teknikken fungerer nøjagtigt ens pr. datasæt og pr. datatype.

Værdiskabende brugscases for syntetiske data

Use case 1: Syntetiske data til modeludvikling og avanceret analyse

At have et stærkt datagrundlag med nem og hurtig adgang til brugbare data af høj kvalitet er afgørende for at udvikle modeller (f.eks. dashboards [BI] og avanceret analyse [AI & ML]). Mange organisationer lider dog af et suboptimalt datagrundlag, hvilket resulterer i 3 nøgleudfordringer:

- At få adgang til data tager aldre på grund af (fortroligheds-) regler, interne processer eller datasiloer

- Klassiske anonymiseringsteknikker ødelægger data, hvilket gør dataene ikke længere egnede til analyse og avanceret analyse (skrald ind = skrald ud)

- Eksisterende løsninger er ikke skalerbare, fordi de fungerer forskelligt pr. datasæt og pr. datatype og ikke kan håndtere store multi-table databaser

Syntetisk datatilgang: Udvikl modeller med så gode som rigtige syntetiske data til:

- Minimer brugen af originale data uden at forhindre dine udviklere

- Lås personlige data op og få adgang til flere data, der tidligere var begrænset (f.eks. På grund af privatlivets fred)

- Nem og hurtig dataadgang til relevante data

- Skalerbar løsning, der fungerer ens for hvert datasæt, datatype og for massive databaser

Dette giver organisationen mulighed for at opbygge et stærkt datagrundlag med nem og hurtig adgang til brugbare data af høj kvalitet for at låse op for data og udnytte datamuligheder.

Use case 2: smarte syntetiske testdata til softwaretest, udvikling og levering

Test og udvikling med testdata af høj kvalitet er afgørende for at kunne levere avancerede softwareløsninger. Brug af originale produktionsdata virker indlysende, men er ikke tilladt på grund af (privatlivs)regler. Alternativ Test Data Management (TDM) værktøjer introducerer "legacy-by-design” for at få testdataene rigtige:

- Afspejler ikke produktionsdata, og forretningslogik og referenceintegritet er ikke bevaret

- Arbejd langsomt og tidskrævende

- Manuelt arbejde er påkrævet

Syntetisk datatilgang: Test og udvikle med AI-genererede syntetiske testdata for at levere state-of-the-art softwareløsninger smart med:

- Produktionslignende data med bevaret forretningslogik og referenceintegritet

- Nem og hurtig datagenerering med topmoderne AI

- Privacy-by-design

- Nemt, hurtigt og agile

Dette giver organisationen mulighed for at teste og udvikle med testdata på næste niveau for at levere state-of-the-art softwareløsninger!

Mere information

Interesseret? For mere information om syntetiske data, besøg Synthos hjemmeside eller kontakt Wim Kees Janssen. For mere information om SAS, besøg www.sas.com eller kontakt kees@syntho.ai.

I dette tilfælde arbejder Syntho, SAS og NL AIC sammen for at opnå de tilsigtede resultater. Syntho er ekspert i AI-genererede syntetiske data, og SAS er markedsleder inden for analyse og tilbyder software til at udforske, analysere og visualisere data.

* Forudsiger 2021 – Data and Analytics Strategies to Govern, Scale and Transform Digital Business, Gartner, 2020.

Gem din guide til syntetiske data nu!

- Hvad er syntetiske data?

- Hvorfor bruger organisationer det?

- Værdiskabende syntetiske data klientcases

- Sådan starter du