Il colpevole invisibile dell'intelligenza artificiale: svelare i pregiudizi interiori

Serie di blog sui pregiudizi: parte 1

Introduzione

Nel nostro mondo caratterizzato da forme di intelligenza sempre più artificiali, le macchine incaricate di prendere decisioni complesse stanno diventando sempre più diffuse. Esiste una crescente quantità di letteratura che indica l’utilizzo dell’intelligenza artificiale in vari settori come il business, i processi decisionali ad alto rischio e, negli ultimi anni, nel settore medico. Con questa crescente prevalenza, tuttavia, le persone hanno notato tendenze preoccupanti in detti sistemi; Cioè, pur essendo intrinsecamente progettati per seguire puramente modelli nei dati, hanno mostrato segni di pregiudizio, nel senso che si possono osservare vari comportamenti sessisti e discriminatori. Il recente Legge europea sull'IA, tratta anche la questione di tali pregiudizi in modo piuttosto ampio e getta le basi per affrontare i problemi ad essi associati.

Nel corso degli anni di documentazione tecnica, le persone hanno avuto la tendenza a usare il termine “pregiudizio” per descrivere questo tipo di comportamento distorto nei confronti di determinati dati demografici; una parola il cui significato varia, causando confusione e complicando il compito di affrontarla.

Questo articolo è il primo di una serie di post di blog che trattano il tema dei pregiudizi. In questa serie mireremo a darti una comprensione chiara e comprensibile dei pregiudizi nell'intelligenza artificiale. Introdurremo modi per misurare e ridurre al minimo i bias ed esploreremo il ruolo dei dati sintetici in questo percorso verso sistemi più equi. Ti daremo anche un'idea di come Syntho, un attore leader nella generazione di dati sintetici, può contribuire a questo sforzo. Quindi, che tu sia un professionista alla ricerca di approfondimenti pratici o semplicemente curioso di sapere questo argomento, sei nel posto giusto.

Bias in azione: un esempio del mondo reale

Forse ti starai chiedendo: "Questo pregiudizio nell'intelligenza artificiale è importantissimo, ma cosa significa per me, per la gente comune?" La verità è che l’impatto è di vasta portata, spesso invisibile ma potente. Il bias nell’intelligenza artificiale non è un mero concetto accademico; è un problema del mondo reale con gravi conseguenze.

Prendiamo come esempio lo scandalo olandese del welfare infantile. Il sistema automatizzato, presumibilmente uno strumento creato per generare risultati equi ed efficienti con un intervento umano minimo, era parziale. Ha erroneamente segnalato migliaia di genitori per frode sulla base di dati e ipotesi errate. Il risultato? Famiglie gettate nello scompiglio, reputazioni personali danneggiate e difficoltà finanziarie, tutto a causa di pregiudizi in un sistema di intelligenza artificiale. Sono esempi come questi che evidenziano l’urgenza di affrontare i pregiudizi nell’intelligenza artificiale.

Fonte: "La compensazione ouders toeslagenaffaire kan zomaar tot 2030 duren”, 2023. Stati Uniti

Ma non fermiamoci qui. Questo incidente non è un caso isolato di pregiudizi che provocano il caos. L’impatto dei pregiudizi nell’intelligenza artificiale si estende a tutti gli aspetti della nostra vita. Da chi viene assunto per un lavoro, chi ottiene l’approvazione per un prestito, a chi riceve che tipo di trattamento medico: i sistemi di intelligenza artificiale distorti possono perpetuare le disuguaglianze esistenti e crearne di nuove.

Considera questo: un sistema di intelligenza artificiale addestrato su dati storici distorti potrebbe negare un lavoro a un candidato ben qualificato semplicemente a causa del suo genere o etnia. Oppure un sistema di intelligenza artificiale parziale potrebbe negare un prestito a un candidato meritevole a causa del suo codice postale. Questi non sono solo scenari ipotetici; stanno accadendo proprio adesso.

Tipi specifici di pregiudizi, come il bias storico e il bias di misurazione, portano a tali decisioni errate. Sono inerenti ai dati, profondamente radicati nei pregiudizi sociali e riflessi nella disuguaglianza dei risultati tra i diversi gruppi demografici. Possono distorcere le decisioni dei modelli predittivi e comportare un trattamento ingiusto.

Nel grande schema delle cose, i pregiudizi nell’intelligenza artificiale possono agire come un influenzatore silenzioso, modellando sottilmente la nostra società e le nostre vite, spesso in modi di cui non ci rendiamo nemmeno conto. Tutti questi punti sopra menzionati potrebbero portarvi a chiedervi perché non sono state intraprese azioni per fermarlo e se ciò sia possibile.

Infatti, con i nuovi progressi tecnologici diventa sempre più accessibile affrontare questo problema. Il primo passo per affrontare questo problema, tuttavia, è comprenderne e riconoscerne l’esistenza e l’impatto. Per ora il riconoscimento della sua esistenza è stato creato, lasciando la questione della “comprensione” ancora piuttosto vaga.

Comprensione del pregiudizio

Mentre la definizione originale di bias presentata dal Dizionario di Cambridge non si allontana troppo dallo scopo principale della parola in relazione all'intelligenza artificiale, si possono dare molte interpretazioni diverse anche di questa singolare definizione. Tassonomie, come quelle presentate da ricercatori come Hellström et al (2020) ed Kliegr (2021), forniscono approfondimenti sulla definizione di bias. Un semplice sguardo a questi documenti rivelerà, tuttavia, che per affrontare efficacemente il problema è necessario restringere notevolmente la definizione del termine.

Pur essendo un cambiamento di eventi, per definire e trasmettere in modo ottimale il significato di bias si può meglio definire il contrario, ovvero Equità.

Definire l'equità

Come viene definito in varie letterature recenti come Castelnovo et al. (2022), l'equità può essere elaborata data la comprensione del termine spazio potenziale. Così com'è, lo spazio potenziale (PS) si riferisce all'estensione delle capacità e delle conoscenze di un individuo indipendentemente dalla sua appartenenza a un determinato gruppo demografico. Data questa definizione del concetto di PS, si può facilmente definire l’equità come l’uguaglianza di trattamento tra due individui con uguale PS, indipendentemente dalle loro differenze osservabili e nascoste nei parametri che inducono pregiudizi (come razza, età o genere). Qualsiasi deviazione da questa definizione, chiamata anche Uguaglianza di Opportunità, è una chiara indicazione di parzialità e merita ulteriori indagini.

I professionisti tra i lettori potrebbero notare che realizzare qualcosa come qui definito potrebbe essere completamente impossibile dati i pregiudizi intrinseci esistenti nel nostro mondo. Questo è vero! Il mondo in cui viviamo, insieme a tutti i dati raccolti da eventi in questo mondo, è soggetto a molti pregiudizi storici e statistici. Ciò, infatti, riduce la fiducia che un giorno si riuscirà a mitigare completamente gli impatti dei bias sui modelli predittivi addestrati su tali dati “distorti”. Tuttavia, attraverso l’uso di vari metodi, si può cercare di minimizzare l’impatto dei bias. Stando così le cose, la terminologia utilizzata nel resto di questo post del blog si sposterà verso l’idea di minimizzare l’impatto del bias piuttosto che mitigarlo completamente.

Va bene! Quindi ora che è stata fatta un'idea di cosa sia il pregiudizio e di come si potrebbe potenzialmente valutarne l'esistenza; Se vogliamo affrontare adeguatamente il problema, però, dobbiamo sapere da dove provengono tutti questi pregiudizi.

Comprensione delle fonti e dei tipi

La ricerca esistente fornisce preziose informazioni sui diversi tipi di pregiudizi nell’apprendimento automatico. COME Mehrabi et. al. (2019) hanno proceduto a dividere i pregiudizi nell'apprendimento automatico, è possibile dividerli in 3 categorie principali. Cioè quelli di:

- Data to Algorithm: una categoria che comprende pregiudizi che hanno origine dai dati stessi. Ciò potrebbe essere causato da una scarsa raccolta di dati, da pregiudizi intrinseci esistenti nel mondo, ecc.

- Algorithm to User: una categoria incentrata sui pregiudizi che derivano dalla progettazione e dalla funzionalità degli algoritmi. Comprende il modo in cui gli algoritmi potrebbero interpretare, valutare o considerare determinati punti dati rispetto ad altri, il che può portare a risultati distorti.

- User to Data: riguarda i pregiudizi che derivano dall'interazione dell'utente con il sistema. Il modo in cui gli utenti inseriscono i dati, i loro pregiudizi intrinseci o anche la loro fiducia nei risultati del sistema possono influenzare i risultati.

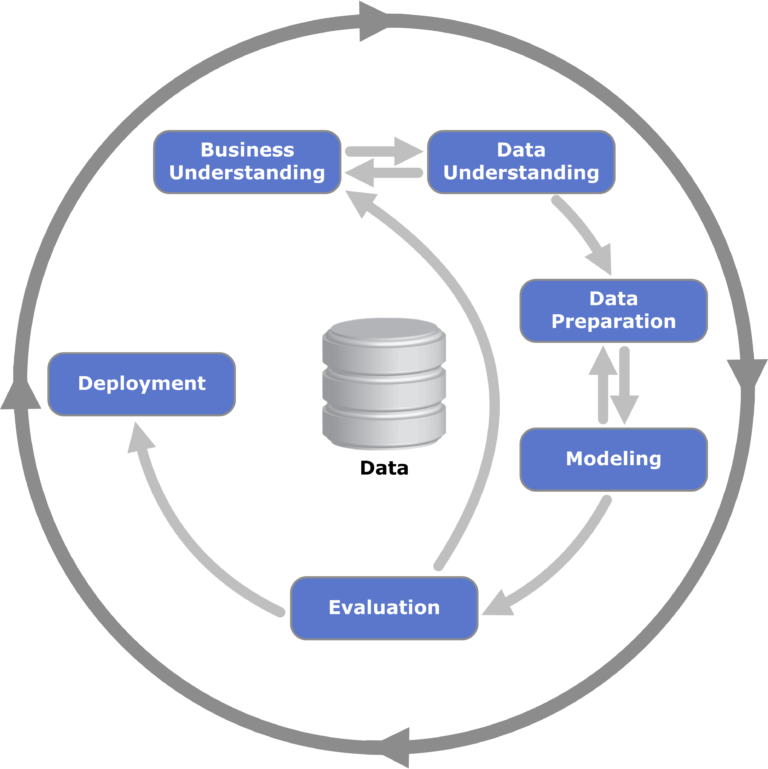

Figura 1: una visualizzazione del framework CRISP-DM per il data mining; comunemente usato nel data mining e rilevante per il processo di identificazione delle fasi in cui possono verificarsi pregiudizi.

Sebbene i nomi siano indicativi della forma di pregiudizio, si potrebbero ancora avere domande sui tipi di pregiudizi che si potrebbero classificare sotto questi termini generali. Per gli appassionati tra i nostri lettori, abbiamo fornito collegamenti ad alcuni documenti relativi a questa terminologia e classificazione. Per ragioni di semplicità in questo post del blog, tratteremo alcuni pregiudizi selezionati rilevanti per la situazione (quasi tutti appartengono alla categoria dati per algoritmo). I tipi specifici di bias sono i seguenti:

- Bias storico: un tipo di bias inerente ai dati causato dai pregiudizi naturali esistenti nel mondo in diversi gruppi sociali e nella società in generale. È a causa della loro inerenza nel mondo che non possono essere mitigati attraverso vari mezzi di campionamento e selezione delle caratteristiche.

- Bias di misurazione e bias di rappresentazione: questi due bias strettamente correlati si verificano quando i diversi sottogruppi del set di dati contengono quantità disuguali di risultati “favorevoli”. Questo tipo di bias può quindi distorcere il risultato dei modelli predittivi

- Bias algoritmico: bias puramente legato all'algoritmo in uso. Come osservato anche nei test condotti (approfonditi più avanti nel post), questo tipo di bias può avere un effetto enorme sull’equità di un dato algoritmo.

Queste interpretazioni fondamentali dei bias nell'apprendimento automatico verranno utilizzate per affrontare il problema in modo più efficace nei post successivi.

Considerazioni finali

In questa esplorazione dei pregiudizi all'interno dell'intelligenza artificiale, abbiamo messo in luce le profonde implicazioni che essa comporta nel nostro mondo sempre più guidato dall'intelligenza artificiale. Dagli esempi del mondo reale come lo scandalo olandese del welfare infantile alle intricate sfumature delle categorie e dei tipi di pregiudizi, è evidente che riconoscere e comprendere i pregiudizi è fondamentale.

Sebbene le sfide poste dai pregiudizi – siano essi storici, algoritmici o indotti dagli utenti – siano significative, non sono insormontabili. Con una solida conoscenza delle origini e delle manifestazioni dei pregiudizi, siamo meglio attrezzati per affrontarli. Tuttavia, il riconoscimento e la comprensione sono solo il punto di partenza.

Mentre andiamo avanti in questa serie, il nostro prossimo focus sarà sugli strumenti e sulle strutture tangibili a nostra disposizione. Come misuriamo l’entità della distorsione nei modelli di intelligenza artificiale? E, cosa ancora più importante, come possiamo minimizzarne l’impatto? Queste sono le domande urgenti che approfondiremo in seguito, assicurandoci che, man mano che l'intelligenza artificiale continua ad evolversi, lo faccia in una direzione che sia allo stesso tempo equa e performante.

I dati sono sintetici, ma il nostro team è reale!

Contatta Syntho e un nostro esperto si metterà in contatto con te alla velocità della luce per esplorare il valore dei dati sintetici!