Dati sintetici generati dall'IA, accesso facile e veloce a dati di alta qualità?

In pratica, l'IA ha generato dati sintetici

Syntho, un esperto di dati sintetici generati dall'IA, punta a dare una svolta privacy by design in un vantaggio competitivo con i dati sintetici generati dall'IA. Aiutano le organizzazioni a costruire una solida base dati con accesso facile e veloce a dati di alta qualità e hanno recentemente vinto il Philips Innovation Award.

Tuttavia, la generazione di dati sintetici con l'intelligenza artificiale è una soluzione relativamente nuova che in genere introduce domande frequenti. Per rispondere a queste domande, Syntho ha avviato un case study insieme a SAS, leader di mercato nell'analisi avanzata e nel software di intelligenza artificiale.

In collaborazione con la Dutch AI Coalition (NL AIC), hanno studiato il valore dei dati sintetici confrontando i dati sintetici generati dall'IA generati dal Syntho Engine con i dati originali attraverso varie valutazioni sulla qualità dei dati, sulla validità legale e sull'usabilità.

L'anonimizzazione dei dati non è una soluzione?

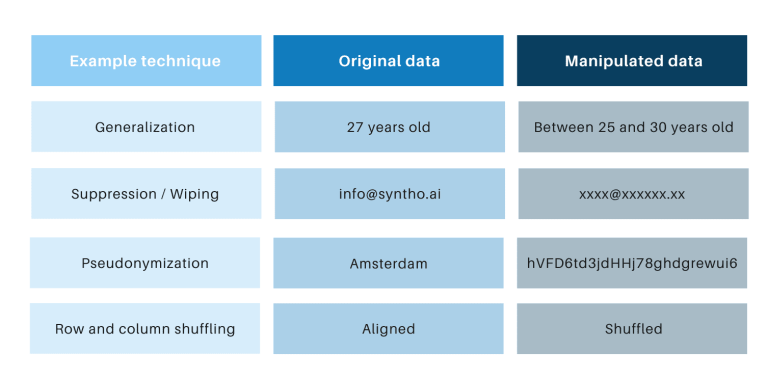

Le tecniche classiche di anonimizzazione hanno in comune il fatto che manipolano i dati originali al fine di ostacolare la rintracciabilità delle persone. Esempi sono generalizzazione, soppressione, cancellazione, pseudonimizzazione, mascheramento dei dati e mescolamento di righe e colonne. Puoi trovare esempi nella tabella seguente.

Queste tecniche introducono 3 sfide chiave:

- Funzionano in modo diverso per tipo di dati e per set di dati, il che li rende difficili da scalare. Inoltre, poiché funzionano in modo diverso, ci sarà sempre un dibattito su quali metodi applicare e quale combinazione di tecniche sono necessarie.

- C'è sempre una relazione uno-a-uno con i dati originali. Ciò significa che ci sarà sempre un rischio per la privacy, soprattutto a causa di tutti i set di dati aperti e delle tecniche disponibili per collegare tali set di dati.

- Manipolano i dati e quindi distruggono i dati nel processo. Ciò è particolarmente devastante per le attività di intelligenza artificiale in cui il "potere predittivo" è essenziale, perché i dati di scarsa qualità risulteranno in cattive informazioni dal modello di intelligenza artificiale (l'ingresso di rifiuti risulterà in un'eliminazione di rifiuti).

Questi punti sono valutati anche attraverso questo caso di studio.

Un'introduzione al caso di studio

Per il caso di studio, il set di dati di destinazione era un set di dati per le telecomunicazioni fornito da SAS contenente i dati di 56.600 clienti. Il set di dati contiene 128 colonne, inclusa una colonna che indica se un cliente ha lasciato l'azienda (ossia "sfornato") o meno. L'obiettivo del caso di studio era utilizzare i dati sintetici per addestrare alcuni modelli per prevedere l'abbandono dei clienti e per valutare le prestazioni di quei modelli addestrati. Poiché la previsione dell'abbandono è un'attività di classificazione, SAS ha selezionato quattro modelli di classificazione popolari per effettuare le previsioni, tra cui:

- Foresta casuale

- Aumento del gradiente

- Regressione logistica

- Rete neurale

Prima di generare i dati sintetici, SAS ha suddiviso casualmente il set di dati di telecomunicazione in un set di treni (per addestrare i modelli) e un set di controllo (per assegnare un punteggio ai modelli). Avere un set di controllo separato per il punteggio consente una valutazione imparziale delle prestazioni del modello di classificazione quando applicato a nuovi dati.

Utilizzando il set di treni come input, Syntho ha utilizzato il suo motore Syntho per generare un set di dati sintetico. Per il benchmarking, SAS ha anche creato una versione manipolata del treno dopo aver applicato varie tecniche di anonimizzazione per raggiungere una certa soglia (di k-anonimato). I primi passaggi hanno portato a quattro set di dati:

- Un set di dati del treno (ovvero il set di dati originale meno il set di dati di controllo)

- Un set di dati di controllo (ovvero un sottoinsieme del set di dati originale)

- Un set di dati anonimo (basato sul set di dati del treno)

- Un set di dati sintetico (basato sul set di dati del treno)

I set di dati 1, 3 e 4 sono stati utilizzati per addestrare ciascun modello di classificazione, risultando in 12 (3 x 4) modelli addestrati. SAS ha successivamente utilizzato il set di dati di controllo per misurare l'accuratezza con cui ciascun modello prevede l'abbandono dei clienti. I risultati sono presentati di seguito, partendo da alcune statistiche di base.

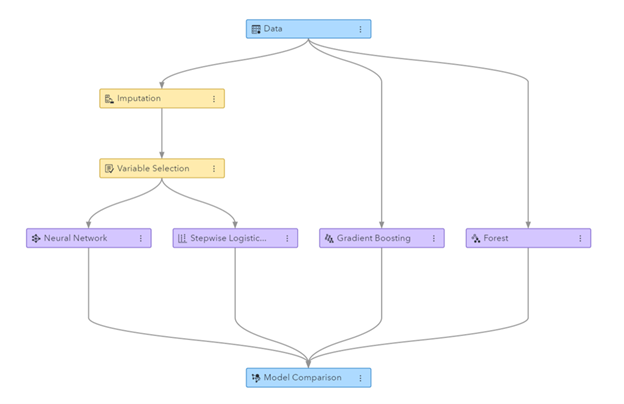

Figura: pipeline di Machine Learning generata in SAS Visual Data Mining e Machine Learning

Statistiche di base quando si confrontano dati anonimi con dati originali

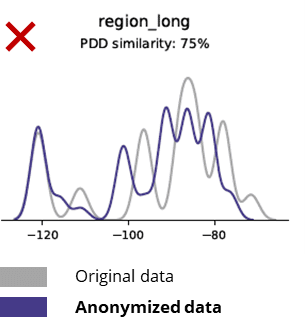

Le tecniche di anonimizzazione distruggono anche i modelli di base, la logica aziendale, le relazioni e le statistiche (come nell'esempio seguente). L'utilizzo di dati anonimi per l'analisi di base produce quindi risultati inaffidabili. In effetti, la scarsa qualità dei dati resi anonimi rendeva quasi impossibile utilizzarli per attività di analisi avanzate (ad es. modellazione AI/ML e dashboarding).

Statistiche di base quando si confrontano dati sintetici con dati originali

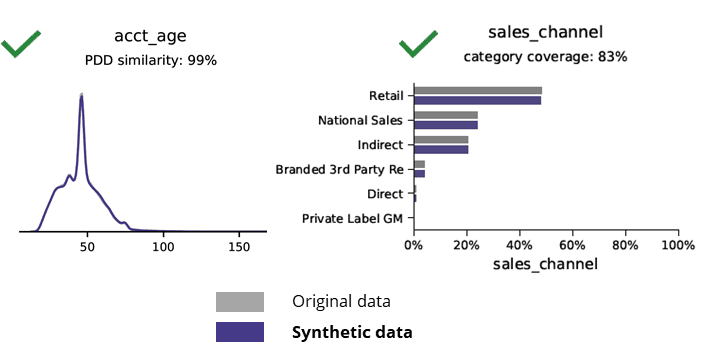

La generazione di dati sintetici con l'IA preserva i modelli di base, la logica aziendale, le relazioni e le statistiche (come nell'esempio seguente). L'utilizzo di dati sintetici per l'analisi di base produce quindi risultati affidabili. Domanda chiave, i dati sintetici sono conservati per attività di analisi avanzate (ad es. modellazione AI/ML e dashboarding)?

Dati sintetici generati dall'intelligenza artificiale e analisi avanzate

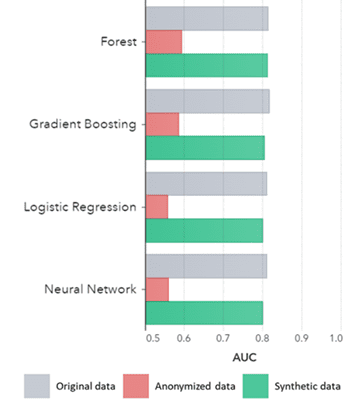

I dati sintetici valgono non solo per i modelli di base (come mostrato nei grafici precedenti), ma acquisiscono anche modelli statistici "nascosti" profondi necessari per attività di analisi avanzate. Quest'ultimo è dimostrato nel grafico a barre sottostante, indicando che l'accuratezza dei modelli addestrati su dati sintetici rispetto ai modelli addestrati su dati originali sono simili. Inoltre, con un'area sotto la curva (AUC*) vicina a 0.5, i modelli addestrati su dati anonimi hanno le prestazioni di gran lunga peggiori. Il report completo con tutte le valutazioni analitiche avanzate sui dati sintetici rispetto ai dati originali è disponibile su richiesta.

*AUC: l'area sotto la curva è una misura dell'accuratezza dei modelli di analisi avanzata, tenendo conto dei veri positivi, dei falsi positivi, dei falsi negativi e dei veri negativi. 0,5 significa che un modello prevede in modo casuale e non ha potere predittivo e 1 significa che il modello è sempre corretto e ha pieno potere predittivo.

Inoltre, questi dati sintetici possono essere utilizzati per comprendere le caratteristiche dei dati e le principali variabili necessarie per il training effettivo dei modelli. Gli input selezionati dagli algoritmi sui dati sintetici rispetto ai dati originali erano molto simili. Pertanto, il processo di modellazione può essere eseguito su questa versione sintetica, che riduce il rischio di violazione dei dati. Tuttavia, quando si deduce record individuali (ad es. cliente telco) si consiglia di riqualificare i dati originali per ragioni di spiegazione, maggiore accettazione o semplicemente per regolamentazione.

AUC per Algoritmo raggruppato per Metodo

Conclusioni:

- I modelli addestrati su dati sintetici rispetto ai modelli addestrati su dati originali mostrano prestazioni molto simili

- I modelli addestrati su dati anonimizzati con "tecniche di anonimizzazione classiche" mostrano prestazioni inferiori rispetto ai modelli addestrati sui dati originali o sui dati sintetici

- La generazione di dati sintetici è facile e veloce perché la tecnica funziona esattamente allo stesso modo per set di dati e per tipo di dati.

Casi d'uso di dati sintetici a valore aggiunto

Caso d'uso 1: dati sintetici per lo sviluppo di modelli e analisi avanzate

Avere una solida base dati con accesso facile e veloce a dati utilizzabili e di alta qualità è essenziale per sviluppare modelli (ad es. dashboard [BI] e analisi avanzate [AI e ML]). Tuttavia, molte organizzazioni soffrono di una base dati non ottimale che si traduce in 3 sfide chiave:

- L'accesso ai dati richiede tempo a causa di normative (privacy), processi interni o silos di dati

- Le classiche tecniche di anonimizzazione distruggono i dati, rendendo i dati non più adatti per l'analisi e l'analisi avanzata (garbage in = garbage out)

- Le soluzioni esistenti non sono scalabili perché funzionano in modo diverso per set di dati e per tipo di dati e non possono gestire database multi-tabella di grandi dimensioni

Approccio ai dati sintetici: sviluppare modelli con dati sintetici altrettanto validi per:

- Riduci al minimo l'uso dei dati originali, senza ostacolare i tuoi sviluppatori

- Sblocca i dati personali e accedi a più dati che in precedenza erano limitati (ad es. a causa della privacy)

- Accesso facile e veloce ai dati rilevanti

- Soluzione scalabile che funziona allo stesso modo per ogni set di dati, tipo di dati e per database di grandi dimensioni

Ciò consente all'organizzazione di creare una solida base dati con accesso facile e veloce a dati utilizzabili e di alta qualità per sbloccare i dati e sfruttare le opportunità di dati.

Caso d'uso 2: dati di test sintetici intelligenti per test, sviluppo e consegna del software

Il test e lo sviluppo con dati di test di alta qualità sono essenziali per fornire soluzioni software all'avanguardia. L'utilizzo dei dati di produzione originali sembra ovvio, ma non è consentito a causa delle normative (sulla privacy). Alternativa Test Data Management (TDM) gli strumenti introducono “legacy-by-design” nell'ottenere correttamente i dati del test:

- Non riflettono i dati di produzione e la logica aziendale e l'integrità referenziale non vengono preservate

- Lavoro lento e dispendioso in termini di tempo

- È richiesto il lavoro manuale

Approccio ai dati sintetici: testare e sviluppare con dati di test sintetici generati dall'intelligenza artificiale per fornire soluzioni software all'avanguardia intelligenti con:

- Dati simili alla produzione con logica aziendale preservata e integrità referenziale

- Generazione di dati facile e veloce con l'IA all'avanguardia

- Privacy in base alla progettazione

- Facile, veloce e agile

Ciò consente all'organizzazione di testare e sviluppare dati di test di livello successivo per fornire soluzioni software all'avanguardia!

Maggiori informazioni

Interessato? Per ulteriori informazioni sui dati sintetici, visitare il sito Web di Syntho o contattare Wim Kees Janssen. Per ulteriori informazioni su SAS, visitare www.sas.com o contatta kees@syntho.ai.

In questo caso d'uso, Syntho, SAS e NL AIC collaborano per ottenere i risultati attesi. Syntho è un esperto di dati sintetici generati dall'intelligenza artificiale e SAS è leader di mercato nell'analisi e offre software per esplorare, analizzare e visualizzare i dati.

* Predicts 2021 – Strategie di dati e analisi per governare, scalare e trasformare il business digitale, Gartner, 2020.

Salva ora la tua guida ai dati sintetici!

- Cosa sono i dati sintetici?

- Perché le organizzazioni lo usano?

- Casi cliente di dati sintetici a valore aggiunto

- Come iniziare